Ruby 0

[Solaris10] カテゴリの記事

全60件 (60件中 1-50件目)

-

さよなら OpenSolaris

Oracle signals an end to OpenSolaris を読む。"All of Oracle's efforts on binary distributions of Solaris technology will be focused on Solaris 11," the memo states. "We will not release any other binary distributions, such as nightly or bi-weekly builds of Solaris binaries, or an OpenSolaris 2010.05 or later distribution."ということで、OpenSolaris 死亡確定。Oracle will release a free developer edition of Solaris 11 later this year, called Solaris 11 Express, which will come with an optional support plan, the memo says. 開発者用の Solaris 11 Express が無償で使えるようになるようだけど、やっぱり Oracle はお金持ちだけを相手にする企業だから、貧乏人は、これ以上、お付き合いはできないなぁ。ということで OpenSolaris にはさよならする。悲しい結末。ZFS 気に入ってたんだけどなぁ。他のプラットフォームに移植されたものって、どの程度、安心して使える状態なんだろうか。それにしても、今後、どういう扱いになるかわからないしなぁ。。。。とりあえず、CentOS に戻ることにした。Oracle 嫌い。民主党も嫌い。どちらも私の気分を悪くさせる。ウソつきは嫌い。

2010.08.14

コメント(0)

-

OpenSolaris 2009.06 をダウンロード

OpenSolaris 2009.06 がリリースされたということで見てみる。opensolaris.orgを見ると、Network Virtualization with CrossbowTurn any host into a SCSI target with COMSTARHost virtual guests using xVM Hypervisor or LDomsSPARCR support for Distro Constructor, Auto Install, and SnapIntel Xeon 5500 processor support with deep power managementMySQL and PHP DTrace Probes in the WebStackImproved usability of the package management systemZFS Time Slider Snapshot ManagementContribute new applications with SourceJuicerGet 24/7 support with OpenSolaris Subscriptions ということなのだが、日本語記事を少し拾う。この最新版では、「Solaris 10」と同等の企業レベルのサポート契約が提供されるほか、Sunのハイエンドプロセッサ「SPARC」のサポートも追加される。同社によると、このサポート契約は、OpenSolarisが企業による導入を視野に入れていることを示すものだという。サン、企業向け機能を追加した「OpenSolaris」最新版を公開SPARC 版でも OpenSolaris が使えるようになったようなのが嬉しい。Solaris 10 を動かしている SPARC マシンはいったん潰して OpenSolaris に統一しようかな。けど、HDD の整理中だから SPARC マシンは後回しかな。いざやるとなると面倒だし。。。。新OSには、「Crossbow」プロジェクトに由来するネットワーキング技術が搭載される。これは、ネットワーク仮想化やリソース制御などの手法を通してパフォーマンスを向上させることを目的とする、再記述されたネットワーキングスタックだ。サン、企業向け機能を追加した「OpenSolaris」最新版を公開ということで、Crossbow は以前から興味津々だったのだが、これで簡単に使えるようになったので試してみたいところ。OpenSolarisを含んだ現在の一般的なOSは、仮想化されたゲストOSに対してCPUやメモリといったリソース機能を備えている。 Crossbowは、CPUやメモリのパーティショニングのようにネットワークリソースを区分けして、ゲストOSに対して割り当てできるという機能をもたらす。またCrossbowは、たとえばhttpsのトラフィックに優先順位をつけるといったQoSポリシーも追加できるようになっている。サン、「OpenSolaris」最新版公開--ネットワーク仮想化技術盛り込むProject Crossbow beta release(気になるもの。Solaris 関係とか適当に(´・ω・`) 2008年3月13日)を見ると、以下のドキュメントでは、マシン 4 台と 2 個の switch から構成される物理的なネットワーク構成を、crossbow を使って1台の Solaris マシンで実現してみる方法が書かれているので参考になるかと思います。http://www.opensolaris.org/os/project/crossbow/Docs/Crossbow_Workshop.pdfPDF ファイルを見てみるとこういう図がある。、手順が一つ一つ順を追って手順が書かれているので、ざっくりと抜き書き。まずは下のように、dladm コマンドを使って Virtual Network を作る(仮想スイッチ 2つと、仮想 NIC を 5枚)。gz# dladm create-etherstub 1gz# dladm create-etherstub 3gz# dladm create-vnic -d etherstub1 1gz# dladm create-vnic -d etherstub1 2gz# dladm create-vnic -d etherstub1 3gz# dladm create-vnic -d etherstub3 6gz# dladm create-vnic -d etherstub3 9次に、ベースになる Zone を作って、Clone を作って仮想マシンの準備。gz# zonecfg -z vnmbase(詳細省略)gz# zoneadm -z vnmbase installさらに、Virtual Router も Zone として作る。gz# zonecfg -z vRouter(詳細省略)それぞれの Zone をインストール、起動したあとに、Virtual Router では、vRouter# svcadm enable network/ipv4-forwarding:defaultのように IP のフォワーディングをイネーブルにする。そして、。。。と。でこの仮想 nic を何に使うと便利かというと、Exclusive IP の non-global zone では今まで物理 nic しか使えなかったのですが、crossbow が入って仮想 nic を使えるようになったことだと思います(Xen や VirtualBox からだとすでに内部インターフェースで使っていますが、public interface になったということでしょうか)。以下のような zonecfg ファイルに set ip-type=exclusive, set physical=vnic0 を指定することで Exclusive IP な zone を仮想 nic で構築できます。仮想 nic なので通常の nic 同様に snoop とったり DHCP clieint と構成したりでき、Exclusive IP の non-global zone をたくさん作成することが可能になりました。Osamu Sayama's Weblogcrossbow を自在に使いたいなら、nwam は disable だろ も参照。SunのZFSファイルシステムにネイティブのSSD管理技術が追加されたようだが、SSD はまだ持ってないので試せないが、そのうち入手して試してみようかなといいつつ、コレはいつ買うか分からない。その他、期待して試してみたいのが、さらに、Sunは「OpenSolaris CIFS Server」プロジェクトを通して、MicrosoftのCIFSネットワークファイルシステムのネイティブサポートをZFSに追加した。これにより、「Windows」と「Linux」、Solarisをまたいだファイルの使用および共有が可能になる。ZFSは、NFSなど、Microsoftのほかのファイルシステムもサポートする。追加した「OpenSolaris」最新版を公開ついでに、サンのクラウドは、Amazon EC2とどう違うのか? の記事も読む。Amazon EC2 とえいば、早速、OpenSolaris 2009.06 32-bit AMI が公開されている。OpenSolaris based AMI catalog on Amazon EC2。その他、参考資料米サン、性能を大幅に強化した「OpenSolaris 2009.06」オペレーティングシステムを発表Release Notes for the SPARC: OpenSolaris 2009.06 ReleaseRelease Notes for the x86: OpenSolaris 2009.06 ReleaseCrossbow Documentationちなみに OpenSolaris 2009.06 はダウンロードしたが、まだインストールしてない。そういえば、ここでさらに dynamips とかも動かすとかやってみたりして。VNUML and Dynamips/Dynagen mixed scenario みたいなことする。というのは VNUML さえあればよいのだが。なんにせよ、そこそこの CPU パワーとメモリを積んだマシンがあれば、いろんな実験ができちゃうのね。IPv6 を使った実験とかも、1台のマシンがあればできちゃうな。

2009.06.04

コメント(0)

-

OpenSolaris 2008.11 等

中古格安SunサーバでSolarisに挑戦! 5万円でSun Fireがあなたの部屋に…… と、中古格安SunサーバでFirebirdに挑戦! エラーメッセージとの戦いの果てに…… を読む。FireBird は Solaris 上だと入り口で苦労するようだ。ちなみにパッケージのインストールは Sunfreeware のものを使うなら、Solaris pkg-get tool を使った方が楽。とはいえ、CSW (Blastwave) と違って、依存性を自動的に解決してくれないから、どのパッケージをインストールするかを確認しなければならないのが面倒。このところ Solaris 10 だけでなく OpenSolaris 2008.11 も使い始めた。OpenSolaris 2008.11 の新機能OpenSolaris 2008.11 入門 だけど、IPS (第3回:IPSでパッケージ管理! 、OpenSolarisのIPS、pkgコマンドの利用方法 など参照) を使えば、楽になるから嬉しいのだけど、例えば R とかインストールしようと思ったらあらないわ。Sunfreeware.com に Solaris 10 のパッケージはあるのだけど、OpenSolaris のリポジトリには、まだないのね。ということで、そういうものを使う場合は、依然として Image Packaging System (IPS) だけじゃパッケージが管理できないのがちょっと悲しい。R はけっこうあれこれパッケージをインストールしなきゃならないので、こういうのこそ IPS で簡単インストールになって欲しいけど、サーバー系で使うようなものが優先されているだろうな。でも、WebStack みたいな感じで MathStack なんてコンセプトでそっち系統の人も惹きつけるとか手もあるんじゃなかろうか。ちなみに、パッケージがあるものはよいけど、パッケージがなくて、例えば、上記の Firebird のように手がかかったりすることはある。このあたり、まだ、Linux なんかに比べると不利だったりする。このあたりも使う人がもっと増えてフィードバックが循環していくようになれば、時間と共によくなっていくのだろう。ハードウェアについても、まだまだ追いつくには時間がかかるのだろう。Opensolaris に自分のマシンが対応しているかを確認するには Sun Device Detection Tool 2.2 を使うとよいらしい。けれど日本語のページのリンクからダウンロードできないので、英語のページ Start Sun Device Detection Tool 2.2 からダウンロードした。これまでノート PC で使ったことはなかったのだけど、ノート PC の対応具合を見てみた。モデム以外は大丈夫そう。モデムはもう使ってないし問題ないな。OpenSolaris 2008.11 は 無線LAN も対応したようだから、そのうち試してみよう。(HCL for OpenSolaris)。そういえば、OpenSolarisプリインストールの東芝製ラップトップが来春発売 って、こういうやつなのか。Toshiba Integrates New Technology into Business Laptops and Announces New LED Projector on Display at CES 2009。OpenSolaris 搭載の TOSHIBA Laptop はこれらしい。こういうのだと苦労はしなくてよいかもね。OpenSolaris も用途を限れば、それなりに実用的なところに来ている感じなので、本格的に OpenSolaris を使い始めようと思う今日この頃。何台も OpenSolaris マシンにしちゃう。そうすると Running a content mirror of pkg.opensolaris.org/dev とかでパッケージファイルをローカルにミラーリングしておいて、アップデートした方がいいのかな。バックアップも Zmanda Integrates OpenSolaris とか使ってみるかと、以前から思っていたがやってなかったな。OpenSolaris に統合されてメンテナンスも楽になったようだから使ってみるか。Solaris と関係ないけど Zope は Python 2.4.x から Python 2.5 (ACCEPTABLE) と 2.6 (TARGET) へと舵をきったらしい。Zope 2.12 では Python 2.4 の公式サポートを終了。OpenSolaris は Python 2.4 がベースになっているけれど 2.5 のパッケージもすでにあるから問題ないか。最近、Zope は使っていなかったけど、また使ってみるかな。和訳 [Zope-dev] Plans for Zope 2.12 など参照。システム監視ソフトの Zenoss を使ってみる とか以前に試してみたが、これも常時動かしてみるかな。中古品ながらサーバマシンを増強したので、あれこれ試せるようになったし。

2009.01.22

コメント(0)

-

壊した ZFS の RAIDZ2 を復旧

ZFS で RAIDZ2 壊す実験 (2008.12.07) の続き。わざと HDD を引き抜きまくって、RAIDZ2 を壊滅的な状況に追い込んだ。引き抜いた HDD を挿し直して、zpool status してみると、次のような状態まで戻った。 プール: xpool 状態: DEGRADED状態: 1 つまたは複数のデバイスが、持続エラーへの応答に失敗しています。 十分な複製が存在するため、プールは縮退状態で動作を継続 できます。アクション: 失敗したデバイスを置き換えるか、または修復されたデバイスを 'zpool clear' を使用して マークしてください。 スクラブ: Sun Dec 7 08:13:19 2008 上で 0 エラーが発生した 0h0m のあとの resilver completed構成: NAME STATE READ WRITE CKSUM xpool DEGRADED 0 0 0 raidz2 DEGRADED 0 0 0 c2t0d0 ONLINE 0 0 0 c2t1d0 FAULTED 0 0 0 エラーが多すぎます c2t2d0 FAULTED 0 0 0 エラーが多すぎます spare DEGRADED 0 0 0 c2t3d0 FAULTED 0 0 0 エラーが多すぎます c2t10d0 ONLINE 0 0 0 c2t8d0 ONLINE 0 0 0 c2t9d0 ONLINE 0 0 0 スペア c2t10d0 INUSE 現在使用中ですエラー: 既知のデータエラーはありませんそこで、とりあえず、# zpool clear xpool c2t1d0# zpool clear xpool c2t2d0 として、2台追加。これで、1台壊れて、ホットスワップが生きている状態まで戻った。 プール: xpool 状態: DEGRADED状態: 1 つまたは複数のデバイスが、持続エラーへの応答に失敗しています。 十分な複製が存在するため、プールは縮退状態で動作を継続 できます。アクション: 失敗したデバイスを置き換えるか、または修復されたデバイスを 'zpool clear' を使用して マークしてください。 スクラブ: Sun Dec 7 08:13:19 2008 上で 0 エラーが発生した 0h0m のあとの resilver completed構成: NAME STATE READ WRITE CKSUM xpool DEGRADED 0 0 0 raidz2 DEGRADED 0 0 0 c2t0d0 ONLINE 0 0 0 c2t1d0 ONLINE 0 0 0 c2t2d0 ONLINE 0 0 0 spare DEGRADED 0 0 0 c2t3d0 FAULTED 0 0 0 エラーが多すぎます c2t10d0 ONLINE 0 0 0 c2t8d0 ONLINE 0 0 0 c2t9d0 ONLINE 0 0 0 スペア c2t10d0 INUSE 現在使用中ですエラー: 既知のデータエラーはありません使われているスペアをここで、いったん外してみる。# zpool detach xpool c2t10d0で NAME STATE READ WRITE CKSUM xpool DEGRADED 0 0 0 raidz2 DEGRADED 0 0 0 c2t0d0 ONLINE 0 0 0 c2t1d0 ONLINE 0 0 0 c2t2d0 ONLINE 0 0 0 c2t3d0 FAULTED 0 0 0 エラーが多すぎます c2t8d0 ONLINE 0 0 0 c2t9d0 ONLINE 0 0 0 スペア c2t10d0 AVAIL そして、clear にする。# zpool clear xpool c2t3d0で プール: xpool 状態: ONLINE スクラブ: Sun Dec 7 08:13:19 2008 上で 0 エラーが発生した 0h0m のあとの resilver completed構成: NAME STATE READ WRITE CKSUM xpool ONLINE 0 0 0 raidz2 ONLINE 0 0 0 c2t0d0 ONLINE 0 0 0 c2t1d0 ONLINE 0 0 0 c2t2d0 ONLINE 0 0 0 c2t3d0 ONLINE 0 0 0 c2t8d0 ONLINE 0 0 0 c2t9d0 ONLINE 0 0 0 スペア c2t10d0 AVAIL エラー: 既知のデータエラーはありません元に戻った。ここで、もう一度、しつこく一台引き抜いて、入れ替えてとかやってみる。# zpool detach xpool c2t3d0# zpool add xpool spare c2t3d0# zpool remove xpool c2t3d0# zpool replace xpool c2t10d0 c2t3d0# zpool detach xpool c2t3d0# zpool add xpool spare c2t3d0# zpool status -xすべてのプールが正常ですこの状態では NAME STATE READ WRITE CKSUM xpool ONLINE 0 0 0 raidz2 ONLINE 0 0 0 c2t0d0 ONLINE 0 0 0 c2t1d0 ONLINE 0 0 0 c2t2d0 ONLINE 0 0 0 c2t10d0 ONLINE 0 0 0 c2t8d0 ONLINE 0 0 0 c2t9d0 ONLINE 0 0 0 スペア c2t3d0 AVAIL 途中で status はどのように推移したでしょうって、クイズじゃないが、ディスクの抜き差しはかなり柔軟にできるのがいい感じ。ぐちゃぐちゃ、入れ替えても大丈夫なのね。あれこれやってみて、ZFS の縮退モードはかなり強そうということが確認できた。ちなみに、もしも「起動のたびに ZFS がパニック状態になったらどうすればよいですか」1. boot using '-m milestone=none'2. # mount -o remount /3. # rm /etc/zfs/zpool.cache4. # rebootこれにより、プールのすべてのデータがシステムから削除されます。プールを作成し直し、バックアップから復元してください。ZFS についてよくあるご質問 (Frequently Asked Questions、FAQ)らしい。パニック状態にするには、どうやったらよいかな。とりあえず、そこまでは面倒なので実験しない。

2008.12.08

コメント(0)

-

ZFS で RAIDZ2 壊す実験

そういえば、Blade 1000 に Solaris 10 08/10 をインストールし直したら、そのとき D2 (Sun StorEdge D2 を買った (2008.06.21)) を切ったままにしたせいか分からないが、D2 のディスクが見えなくなってしまった。以前と同様 devfsadm を実行したら見えるようになった。(デバイスへのアクセス (概要))。ディスクが見えるようになったら zpool import poolname でインポート。ほっと一息。以前はストライプにしていたのだが、ついでなので信頼性重視で、RAID-Z で作り直すことにした。ダブルパリティーを使うことにする。HDD は中古のやつだし、いつ壊れるか分からないからw1 つまたは 2 つのデバイスで障害が発生しても、データを失うことなく処理を続行できることを意味します。raidz2 キーワードを指定すれば、ダブルパリティー RAID-Z 構成にすることができます。あるいは、raidz または raidz1 キーワードを指定すれば、シングルパリティー RAID-Z 構成にすることができます。ダブルパリティー RAID-Z (raidz2)そういえば、ZFS Disk Crash Demo、ZFS is Smashing Baby とか、端的に分かりやすいデモだけど、でもでも、まったくもう。。。。って感じ。まあ、銃弾打ち込んだり、爆破したりするのに比べたらましだけど。ディスクが 7 台あるので、6台で RAID を組んで 1台をホットスペアにしてみる。とりあえず、zfs のスナップショットの機能を使って、別のマシンにバックアップを取る。ZFS データを送信および受信する など参照。# zfs snapshot mypool/mydata@snap1# zfs send mypool/mydata@snap1 | ssh another-host zfs recv mypool/mydata_snap1リモートの storage_snap1 のところは、使われていない名前を指定するか、あらかじめ作ってあってもアンマウントできる状態にしておく。アンマウントできない状態だとエラーになるみたい。ちなみに、root で、これをやるには受け側のホストで root で ssh ログインできるようにしておかないとダメなので、/etc/ssh/sshd_config で PermitRootLogin yes と一時的にしておく。でも、セキュリティ上、受ける側を user@another-host とした方がいいな。それにしても、こういうのをやるときにはネットワークがギガビット対応でないと時間がかかる。。。。加えて ssh 使うから CPU をそれなりに使うのね。あまりロースペックなマシンだと、ここでもだと時間がかかる。ssh 使わずにできないのか。。。。ssh を使わない zfs send/recv という手もあるのね。mbuffer を使って ZFS data stream を送受信してあげるのね。おぉ、ちなみに、zfs recv の -v オプションを利用すると、全ての data stream 受信完了後、受信にかかった時間や受信データ量、1 秒間の平均転送速度を出してくれます。このオプションは気づいていなかった。-v つけるようにしよっと。んー、でも、ssh を使う場合は、送信側だけでえいとやれるのに、mbuffer を使う場合は受信側でも用意をしてから、投げないとダメなのが若干、面倒。特に自動化する場合とか。ちなみに、zfs data stream を送受信中に他のホストからゴミを投げつけるとか、別のバックアップ開始しちゃったら壊れるかw 他のホストからは、そのポートに通信を受けないようにしておけば安心できるか。自動化するなら、ホストごとにポートを変えるだな。時間が予想以上かかって別のマシンから送られてきたらドカンじゃまずいものね。バックアップができたら、いったん、ちゃんとバックアップができたか確認してからプールを破壊して、作り直す。とりあえず、1台は念のためスペアにして、raidz2 で作成。# zpool destroy mypool# zpool create xpool raidz2 c2t0d0 c2t1d0 c2t2d0 c2t3d0 c2t8d0 c2t9d0 spare c2t10d0 そして、ptime mkfile 1g test.dat で簡単にパフォーマンスを見てみる。あれ、やけに遅いな。何でかな。ストライプで試してみたけど、やっぱり遅くなっている。んー、以前、作成データの大きさを間違えるとか、何か間違ったことして速いと思っちゃっただけなのかな。。。。1GB の書き込みがかなり遅くなっているけど、数百MB 以下のファイルは速くなっているから、実用上は困らない。まあ、いいや。ちなみに、今回は raidz2 でホットスペア 1台にしてみた。稼働中のディスクが仮に 2台すっ飛んでも、1台はホットスペアが入るから、さらに 1台飛んでも死なないかなと。さすがに 4台すっ飛ぶ間に手は打てるだろうと。とりあえず 1台引っこ抜いて、ちょっと待つと。ホットスペアが機能して、使用中になる。NAME STATE READ WRITE CKSUMxpool DEGRADED 0 0 0 raidz2 DEGRADED 0 0 0 c2t0d0 ONLINE 0 0 0 c2t1d0 ONLINE 0 0 0 c2t2d0 ONLINE 0 0 0 spare DEGRADED 0 0 0 c2t3d0 FAULTED 0 110 0 エラーが多すぎます c2t10d0 ONLINE 0 0 0 c2t8d0 ONLINE 0 0 0 c2t9d0 ONLINE 0 0 0スペア c2t10d0 INUSE 現在使用中ですさらに1台ディスクを引っこ抜く。ホットスペアがもうないので、DEGRADED になる。そうすると、状態: DEGRADED状態: 1 つまたは複数のデバイスが、持続エラーへの応答に失敗しています。 十分な複製が存在するため、プールは縮退状態で動作を継続 できます。アクション: 失敗したデバイスを置き換えるか、または修復されたデバイスを 'zpool clear' を使用して マークしてください。 スクラブ: Sun Dec 7 00:00:00 2008 上で 0 エラーが発生した 0h0m のあとの resilver completed構成: NAME STATE READ WRITE CKSUM xpool DEGRADED 0 0 0 raidz2 DEGRADED 0 0 0 c2t0d0 ONLINE 0 0 0 c2t1d0 ONLINE 0 0 0 c2t2d0 FAULTED 0 207 0 エラーが多すぎます spare DEGRADED 0 0 0 c2t3d0 FAULTED 0 110 0 エラーが多すぎます c2t10d0 ONLINE 0 0 0 c2t8d0 ONLINE 0 0 0 c2t9d0 ONLINE 0 0 0 スペア c2t10d0 INUSE 現在使用中ですとりあえず、2台死んでもまだ大丈夫(実質、ホットスペアが機能しているので 1台が死んだ状態)。ダブルパリティだから、もう1台死んでも大丈夫なはず。さらにもう 1台ディスクを引っこ抜く。 プール: xpool 状態: DEGRADED状態: 1 つまたは複数のデバイスが、持続エラーへの応答に失敗しています。 十分な複製が存在するため、プールは縮退状態で動作を継続 できます。アクション: 失敗したデバイスを置き換えるか、または修復されたデバイスを 'zpool clear' を使用して マークしてください。 スクラブ: Sun Dec 7 00:10:53 2008 上で 0 エラーが発生した 0h0m のあとの resilver completed構成: NAME STATE READ WRITE CKSUM xpool DEGRADED 0 0 0 raidz2 DEGRADED 0 0 0 c2t0d0 ONLINE 0 0 0 c2t1d0 FAULTED 0 128 0 エラーが多すぎます c2t2d0 FAULTED 0 207 0 エラーが多すぎます spare DEGRADED 0 0 0 c2t3d0 FAULTED 0 110 0 エラーが多すぎます c2t10d0 ONLINE 0 0 0 c2t8d0 ONLINE 0 0 0 c2t9d0 ONLINE 0 0 0 スペア c2t10d0 INUSE 現在使用中でエラー: 既知のデータエラーはありません3台引っこ抜いたけれど、1台はホットスワップが入って、実質 2台が壊れた状況。それでも、「エラー: 既知のデータエラーはありません」の状態で生きている。強い!さて、もう 1台引っこ抜くとどうなるか。つまり、7台中、4台引っこ抜く。残り3台。これで壊れるはず。なかなかステータスが返ってこない。うー、全然返ってこない。この状態で zfs list とか、zpool list とかやっても返ってこない。意外な弱点。ひょえぇ。もし、こういうダメ状態になったときに、ステータスが返ってこないと対処できないじゃん。それにしても、壊滅的に壊れた場合の追試が必要だなぁ。壊滅的に壊れてから zfs status でどのディスクが壊れているか確認できないのが辛い。もし、いつでも、こうなっちゃうとすると、万が一に備えてもう少しディスクを増やして、さらに一台ホットスワップのディスクを用意した方がいいか。。。。それにしても、zpool status や zpool listや zfs list のプロセスは Ctrl-C しても殺せない。kill コマンドも効かない。ssh のセッションごと殺しちゃえ。いえいえ、それでもプロセスはまだまだ生き延びてます。ちなみに、こういう状態でも、恐ろしいことに、その pool をマウントしたところで読み書きできるなぁ。生きているディスクだけに書き込みするのか。試しにここで、強引に reboot してみる。うー、なかなか起動時の処理が終わらない。生き残ったディスクがガリガリやっている。ログインもできない状態が続く。ZFS が強いと言っても、ほんとうに壊れちゃうところまでやると、やっぱり、大変なことになるようだw 仕様上、壊れるところまでやって壊れるのは当然だからよいとして、その後、お手上げ状態になるのがちと困るな。壊滅的に壊れた後の運用ノウハウもきちんと身につけておかないといかんね。

2008.12.07

コメント(0)

-

Solaris 10 10/08 と Cool Stack 1.3.1 をインストールした

Blade 1000 に Solaris 10 10/08 をインストールし直した。boot cdrom - text でテキストモードでインストールしたのでルートのファイルシステムも ZFS にできた。これで気持ちよくなった。グラフィック画面からのインストールでも、デフォルトで ZFS のインストールになればいいのにな。まあ、過渡的な状態だろうから、いつかはそうなるんだろう。とりあえず Cool Stack 1.3.1 をインストールしてみた。Optimized Open Source Software Stack (Cool Stack)。CoolStack のご紹介、第2回 Cool Stackで手軽に「SAMP」、SAMP構築 - Cool Stack使用 - など参照。Apache Roller でブログサーバーを構築してみよう! を参考に Apache Roller を CoolStack で動かしてみる。一応、動くことだけ確認。CoolStack じゃないのと比べてどうか比較しようと思ったが面倒なので止めた。楽に環境を整えられるだけでもメリットはある。ちなみに、古めの CoolStack 1.2.x の関連の文書を見ていると、# svcadm enable svc:/network/csk-http:CSKapache2みたいになっているけど、1.3 だと、# svcadm enable svc:/network/http:apache22-cskとか、SMF でのサービスの名前が変わっていたりするのね。svcs -a | grep csk とかやって調べればよいようだ。svc:/application/database/mysql:mysql-csksvc:/network/http:apache22-csksvc:/network/http:tomcat5-csksvc:/network/http:tomcat6-csksvc:/network/http:lighttpd-csksvc:/network/http:squid-cskちなみに、CoolStack って、Sun Studio 12 を使って Selecting the Best Compiler Options でコンパイルしてるのね。たとえば、Python の場合、README.python を見ると、次のようなオプションでコンパイルされている。Python 2.6 も同じようにしてコンパイルしてみるか。まあ、劇的に速くなるってもんじゃないだろうけど、気持ち速くなればいいかなと。SunStudio12 もインストールしておく。LDFLAGS="-L/opt/coolstack/lib" \OPT="-fast -xipo -xtarget=generic" \BASECFLAGS="-I/opt/coolstack/include" \LINKFORSHARED="-fast -xipo -xtarget=generic -xipo_archive=writeback" \BLDSHARED='$(CC) -G -R/opt/coolstack/lib' ./configure \ --prefix=/opt/coolstack \ --disable-static \ --enable-ipv6 \ --without-gcc \ --with-threads

2008.12.01

コメント(0)

-

Blade 1000 を改造する

Yahoo!オークションでジャンクものの Sun Blade 2000 を 2600円で先日落札した。送料とか消費税とか合わせると 5000円くらい。起動できないジャンクものなので、部品取りに使う。とりあえず、以前から持っている Blade 1000 の部品と付け替えてみたけれどダメっぽい。マザーボードがダメなのかな。ということで、以前から持っている Blade 1000 のマザーボードを Blade 2000 に付け替え。グラフィックカードや DVD-ROM ドライブとかは、そのままジャンクもののを使ってといったように、別のマシンとハイブリッドにする。表は Blade 2000 で中身は Blade 1000 のマザーボードで、部品は Blade 2000 のものという感じ。とりあえず、両方のマシンを分解。勢いで組み立てる。一部ケーブルのつなぐの忘れたりとかして、再起動まで、ちょっと時間を食うが、とりあえず動くようになった。体感速度が上がった感じ。グラフィックカードが XVR-1000 になったのも効いているか。あとは筐体がきれいになったのが嬉しいかな。SunPCi-II のカードもささっていたので使うことにする。SPARC マシンだと x86 を仮想マシンの類で動かすことができないけど、SunPCi があればハード的に x86 の CPU がカードに載っているので Windows が動かせちゃう。ラッキー。また、遊び道具がまたひとつ増えた。ということで、SUNPCI Downloads から、SunPCi 2.3.2 をダウンロードしてインストール。途中でエラーが出るがとりあえず無視して先に進んでみる。SunPCI II pro で Windows をつかおー! のあたりが参考になるか。Blade 1000改には、 Nevada なので、シンボリックリンクの名前をちょっと変えた。# ./sunpcload The SunPCi 2 driver installation has failed. Cannot find the driver file: sunpcidrv.2110と、やっぱりエラーが出るので、# cd /opt/SUNWspci2/drivers/solaris# ln -s sunpcidrv.290 sunpcidrv.2110# ln -s sunpcidrv.290.64 sunpcidrv.2110.64として、# cd /opt/SUNWspci2/drivers/solaris#./sunpcloadこれで使えそうな感じ。sunpci を起動してディスク作成。作成後に、warning が出るが、とりあえず気にしないでおく。DRDOS のドライブを作って、sunpci -C C.image 起動してみると DRDOS が動いた。次に、Windows 2000 を試しにインストールしてみる。そこそこ使えそうな感じ。メモリは 128MB しかついてないけど、せっかくだから CPU を速いのに載せ替えて、メモリを増設しようかなと、一瞬思ったがやめておく。Sun Quad Fast Ethernet を買ってあったので、ついでに設定する。980円とかで買える。Sun Quad FastEthernet Adapter を Sun Trunkingとともに使用することによって、アプリケーションや既設の配線を変更することなく 800Mbps の「ビッグパイプ」が実現できます。というのをやってみたくて。FastEthernet だと最大 16までトランキングできるようだし、PCI のスロットがもう一つ空いているので、もう1枚買ってもいいかなぁ。800Mbps x 2 = 1.6Gbps。「Sun Trunking 1.3は、IEEE 802.3ad Link Aggregationの静的 (static) モードと互換性」なので、このあたり実験しようかと。現状でも 4 + 元のポート 1つ、SunPCi のポートが 1つで 6ポートも使っているから、これにさらに 4つ加わると、1台から10ポートかw そこまでやるとタコかイカのような状態になるから Gbit のカード買った方がいいか。ケーブル代とかもかかるし。Gigabit Ethernet (GBE/P) も安くなっているが、1000BASE-SXで光ケーブルだからちと困る。まあ、これで十分だな。とりあえず、カードをさして起動し、# grep qfe /etc/path_to_inst"/pci@8,700000/pci@3/SUNW,qfe@0,1" 0 "qfe""/pci@8,700000/pci@3/SUNW,qfe@1,1" 1 "qfe""/pci@8,700000/pci@3/SUNW,qfe@2,1" 2 "qfe""/pci@8,700000/pci@3/SUNW,qfe@3,1" 3 "qfe"で、カードが認識されているのを確認。/etc/hostname.qfe0 から /etc/hostname.qfe3 を作り、各々のホスト名を入れる。/etc/hosts に各々のホスト名と IPアドレスを入れる。システムを再起動すると使えるようになった。次に、Sun TrunkingソフトウェアをSun Trunking Utility 1.3 Updateをダウンロード、インストール。install スクリプト実行時 Nevada だと Solaris 11 でディレクトリがないことになってインストールできないので(uname -r が 5.11 でスクリプトは 5.10 が前提になっている)、ちょっとスクリプトをいじって、さらに「ln -s Solaris_10 Solaris_11 」とかしてパッケージのディレクトリのシンボリックリンクを作るなどしてやらないとインストールできなかった。ifconfig qfe0 unplumb 等、いったんインタフェースを削除しておいてからトランクの設定に移る。OpenBoot で「ok setenv local-mac-address? true」として起動しなおす。加えて、スイッチの方も Trunk の設定をしておく。そして、nettr -setup でトランクの設定をして、-conf で設定確認後、ifconfig でインタフェースをアップして、snoop でパケットチェック。# PATH=$PATH:/etc/opt/SUNWconn/bin# nettr -setup 0 device=qfe members=0,1,2,3 policy=2# nettr -conf# ifconfig qfe0 plumb 192.168.1.10 up# snoop d qfe0外部から ping を打ってパケットが入ってくるのを確認。# nettr -stats 0 device=qfe intreval=1とかやって、統計情報を取ってみると、ちゃんとそれぞれのインタフェースが使われているようだ。いまだに Blade 1000とか 2000とか持って使っている人は、Quad Fast Ethernet をつけるとけっこうよいかもしれない。トランキングを解除するには、# nettr -release 0 device=qfe発売当初は百万円以上もしたものが、6年もすると たいてい 10万以下、ものによっては 1万円以下で買えるので、大人のおもちゃになる。ソフトウェアのみの仮想環境はそれはそれなりにおもしろいが、やっぱり物理的にマシンをいじるというのもプラモデルを作るのと同じようなおもしろさがある。ネットワーク機器なんかも、シミュレータやエミュレータを使って遊ぶのとは別の楽しみがある。そういえば、VMware ESX Server って VLANやチーミングにも対応する仮想ネットワーク なのね。仮想化の技術ってすごいなぁと改めて思う。けれども、昔の男の子は機械いじりが好きなのね。物理的なマシンをいじるとそれだけでも楽しみになる。

2008.11.03

コメント(0)

-

仮想環境を試しはじめる

Sun Fire V40z の BIOS 等をアップデートした からの続き。SunFire V40z にいったん Windows Server 2003 を試しにインストールして気が済んだので、Solaris インストールしよっとで、Solaris 10 5/08 vs Nevada あなたならどっちを使う? を読む。複数のOSを同時に動かしたいから、Nevada にしようかなと思ったのだが、やっぱり安定感をとって Solaris 10 をインストールすることにした。もうすぐアップグレード出るだろうし、そうしたら、xVM のパフォーマンスも改善するかなと期待して。とりあえず、Solaris 10 10 5/08 をインストールして、やっぱり画面とか Nevada の方が気分的にいいよなぁとか思いながら、まぁいいか。OpenSolaris 2008.05 でもよかったか。Virtual Box をインストールして、OpenSolaris 2008.5 を動かしてみる。V40z でビデオカードはサーバだけに弱いから、描画が遅いな。別のマシンからX端末のエミュレータで動かしてみると使える。どうせ近くにいるとうるさいし、こっちの使い方になるか。それにしても、V40z はうるさいマシンだ。家庭に置く方がいけないのだけどw うるささの程度は掃除機を一日中動かしている感じ。内蔵のファンを止めてしまうかなぁ。ついでだから、Nexenta も動かそうか。1.0.1 が stable で、2.0 が Alpha 1 なのね。2.0 は、Ubuntu 8.04 LTS (Hardy Heron) ベースで、"100% native Debian environmen" なんだ。Nexenta をベースとした NexentaStor の TUTORIALS & DEMOS を見てみると、へぇ、これよくできてる。ストレージの扱いに特化しているのね。スナップショットの自動化とかもできるし、GUI も CLI も使いやすそう。Solaris もオープンソースにすることによって、こういうアプライアンス系が出てくる余地が産まれたのだから成功だな。有償版はそれなりのお値段だけど。あれこれ仮想環境で動かすなら、ベースは VMware ESXi Hypervisor にしておいた方が効率がいいかなぁとか思い始める。【仮想化を楽しむ】 徹底解説!VMware ESXi。Solaris 10 + xVM でパフォーマンス的に OK になるまで、VMware ESXi で遊ぶのもいいかな。Virtual Network Security Analyzer なんていうのもあるのね。仮想環境のネットワークのトラフィックでも、これがあればチェックできると。こういうアプライアンスものには、仮想アプライアンスに最適な「JeOS(ジュース)」 が使われるのね。OpenSolaris もこの手のものがそのうち出てくるかな。仮想環境の Hypervisor をベースに考えると OS の姿も微妙に変わってくる。ネットワーク管理も微妙に変わってくるだろう。Solaris は xVM でどこまで健闘できるかな。

2008.10.05

コメント(0)

-

Sun Fire V40z の BIOS 等をアップデートした

中古の Sun Fire V40z を買ってしまった ので、地道に使うことにする。とりあえず、SP と BIOS のアップデートがまだだった。ということで設置マニュアルに従ってアップデート。別マシン上でアップデート用のサーバを java -jar updateServer.jar -c updateServer.config -p 52708 -l logfile.log のように動かしておいて、リモートアップデートをしてみた。updateServer.config ファイルは事前に編集する必要があるが、記述に間違いがあるとサーバが起動しないようになっている。更新後、SP のコマンドラインで「inventory get software」とするとバージョンの確認ができる。BIOS を更新すると "Error. Invalid operation for current platform state." のようなエラーが出るときは、本体の OS が動いている状態。「platform get power state」を入力すれば状態が分かる。「platform set power state off -f」でオフにできる。とにかく、リモートでアップデートができてしまうので、大量のサーバがある場合やサーバが離れたところにある場合に重宝するだろう。こういう仕組みも便利でいいなと思う。Google のように高度な機能がない普通の PC ベースをたくさん使ってるところとは対局的な発想のマシンだけど、これはこれでおもしろい。んー、Google って BIOS アップデートするときどうしてるんだろう。アップデートも済んだので、次に OS は何をインストールするか迷ったのだが、Solaris Express Community Edition をインストールすることにした。Solaris Express Community Edition b90以降なら ZFS Root が使えるが、Solaris 10 はまだそれはできないようだから。ZFS boot と ZFS root がやってくる。ZFS Root を使うときには、CUI でインストールしなきゃいけないのね。あと、Solaris 10 5/08 vs Nevada あなたならどっちを使う? を見ると、Solaris 10 5/08 だと xVM 遅い感じだし。cifs server も試したいし。そもそも、V40z は実験専用マシンだからつぶすのも躊躇ないし。Download xVM Server を見たら、バイナリリリースはまだなのね。もうリリースされているんだと思いこんでいた。とりあえずはソースからコンパイルすればよいのだけど。Sun xVM Virtualization Portfolio 気合い入っているなぁ。ちょっと待てよ。もうちょい待つと Solaris 10 10/08 availability is planned for mid October なようだから、もう少し待つか。あれこれ入れて潰してとするか。とりあえずやってみればいいのだな。ネタになるし。Windows Server 2008 を仕事で使わなきゃいけないので、Windows Server 2008 をインストールして、Microsoft,サーバー仮想化ソフト「Hyper-V Server」の無償提供を開始 も試してみるか。まったく関係ない話だが、名脇役だと思う女優ランキング2008 を見ていたら、やっぱり猫が好き を思い出した。こういう番組ってまた見てみたいと思う。やっぱり Sun がスキ! の人って、やっぱり猫が好きも好きだったのかな。過去記事は ここ の拾い読みしてみるか。

2008.10.02

コメント(0)

-

中古の Sun Fire V40z を買ってしまった

先日、Sun Fire V40z (pdf)をオークションで落札したものが届いたのだが、実に重い。鉄の塊。腰が抜けそうな程重い。やっとのことでラックに載せたのだが、これほど重いと思わなかった。ここで、いったん力尽きる。なぜに一世代前のこんなものを買ったかと言えば、OS は Solaris 10 でも、Red Hat でも Windows でも使える Opteron のマシンだから。Blade 1000 を持っているけど SPARC だから x86 系のものが欲しかったのね。CPU は AMD Opteron 4 個でメモリ 16GB なので、仮想マシンの実験用にはピッタリかなと。その気になればメモリはもっと増やせるし。安いデスクトップパソコンだと、その気になってもメモリの増設には限度があるものね。このスペックで 54,800円 なら許せるでしょ。増設したHDD 含めて 67,800円。中古だからどの程度持つか分からないけど、とりあえず満足。それにしても、馬鹿でかくて重い (445mm/756mm/133mm/最大34kg)。筐体が鉄の塊なのに加えて、電源やファンが冗長化されているから余計重いのね。ディスクは追加で買ったので 5台積んでるし。普通、家庭には置かないよなぁ。ファンの音もうるさい。この手の物は仕方ないなぁ。でもうるさい。。。。家で使おうとする方がバカなのだな。まるで飛行機が飛び立つときのような音。気を取り直して、とりあえず電源を入れて動かしてみると、CPU が 2つしか認識されていない。んんっ。まさか、2つしか入っていないの?と、全面のパネルを空けて CPU のオプションボードを確認する。しっかりと差し込まれていない。ぐっと差し込み直して再起動。ん、今度は "LOSS of Extended Memory due to Memory Test Errors!" で止まる。何っ、今度はメモリー。もう一度、CPU のオプションボードを引き出してメモリをつけ直す。やっと、起動できるようになった。輸送中に衝撃が加わってゆるんじゃったのかなぁ。とりあえず、Sun Fire V20z and Sun Fire V40z Servers Documentation - Japanese からマニュアルをダウンロードしてざっと見る。ボディーの全面に LCD とボタンがあって、メニューからあれこれできるのだが、さすがにこういうものはマニュアルを見ないと分からない。SunFire V40z には管理用のサービスプロセッサ (SP) があって遠隔管理ができる。管理用の OS が動いていて、それ用にネットワークポートを別途持っているのね。このあたりが普通の x86 マシンと違っておもしろいところ。SP の IP アドレスなども、このメニューを使って設定する。通常使う OS と別にハードウェアの管理用の Linux が動いていて、あれこれできる。通常使う OS がハングしてどうしようもない状態になっていても、専用のネットワークで管理用の OS にアクセスすればハードの状態を把握できるし、電源のオンオフもリモートからできる。サーバルームにサーバがおいてある場合は重宝するだろう。まぁ、自宅に置いておく場合は、それほどでもないか。でも、ファンの音がうるさいので別の部屋で動かすので、リモートからリブートできるのは便利だったりするが。とりあえず、パネルから IP アドレスを設定した後、初期アカウントを作成しようと、# ssh ip_address -l setupで接続するがアクセスに失敗する(やっぱり中古なのでパスワードが設定されている状態だからだろう)。パネルのメニューから SP - Use defaults オプションを選択して、SP をリセットすると自動的に SP がリブートする。でもって再設定。初期化されると IP アドレスなどの設定も消えるので再設定。デフォルトでは DHCP で IP アドレスを取得するようになっている。初期アカウントを作ると ssh で SP にアクセスできるようになる。ログインしたあと uname -a してみると、Sun MicrosystemsIPMI v1.5 Service Processorlocalhost $ uname -aLinux localhost 2.4.18 #5 Wed Feb 25 13:30:32 CST 2004 ppc unknownと、Linux の kernel 2.4.18 が動いているのね。ここは Solaris じゃないのがお茶目。サーバ名の定義も操作パネルから、panel menu で行う。名前を定義すると LCD に IP アドレスではなく名前が表示されるようになる。1台だけしかないので、サーバ名の表示は設定せず、IP アドレスの表示にしておく。もう一つおもしろいところは、ネットワーク共有ボリューム (NSV) で、イベントログファイル、ソフトウェアの更新、診断や障害追跡用のダンプユーティリティをおくこと。ソフトウェアのアップデートをSun Fire V40z Server - Downloadsからダウンロードしておく。ソフトウェアやドライバのアップデートだけでなく、SNMP MIB なども含まれている。ダウンロードしたファイルを別のマシンで解凍して、NFS で export して、V40z のサーバからマウントして使うようだ。ソフトウェアのアップデートやツールの類は一カ所に持ってエクスポートしておいて、他の沢山のマシンは、そこをマウントして使うという感じ。たくさんマシンがあるところで管理が楽なように作られているのね。OS のインストールは、Sun Installation Assistant から行う。そうすれば、必要なドライバもちゃんとインストールされるようだ。これも上記のダウンロードから落とせる。対応している OS は、Solaris 9, 10、Red Hat Enterprise Linux 3, SUSE Linux 8, 9, 10、Windows Server 2003, 2000。V40z 自体は終わっている製品だから Windows Server 2008 とかはもうダメかな。まあ、Installation CD を使わないでインストールするしかない。どの程度 Windows Server 2008 がちゃんと動くかはそのうち試してみる。でも、基本は Solaris 10 で動かす予定なので VM 上で動かせばよしとする。ちなみに、通常の CD-ROM/DVD-ROM からのインストールだけでなく、Linux の場合、PXE サーバからのインストールもできてマニュアルに手順が書かれている。ネットワークインストールができること自体は、インストールする OS 側の問題なのだけど、手順が書かれているので楽かも。その他、SP のコマンドでソフトウェアのバージョンを確認するには、次のコマンドで BIOS のバージョンなどが確認できる。localhost $ inventory get softwareハードウェアは、localhost $ inventory get hardwareなかなかおもしろいなぁと思いつつ、CD-ROM 焼いたりする下準備が面倒なので、とりあえず、Installation Assistant は使わずに、Windows Server 2003 をインストールしてマシンが動くか確認。ちゃんと動いた。やっぱり Sun のマシンで Windows 動かすってとりあえずやってみたかったしw

2008.09.28

コメント(0)

-

Sun の WebStack

Sun が Web Stack とかいうものを公開するとかいうニュースを見る。Sun,Solaris/Linux向けAMPスタックを公開,Java System Web Server/ProxyをOSS化米Sun、Webアプリ実行基盤「Sun Web Stack」を提供開始米Sun、SolarisとLinux向けApache/MySQL/PHP/PerlスタックCoolStack があるのに、どうしたのかなと思ったら、OpenSolaris Project: Web Stack のダウンロードのリンク見たら Sun Web や Proxy Server も加えて CoolStack を拡大したってことなのか。Solaris だけでなく Linux も対象になったということなのか。Sun Microsystems Unveils Enterprise LAMP Stack for Solaris and Linux - Releases Open Source Java System Web Server into the OpenSolaris Community や Sun Optimezed MP Stack あたり見てみる。Sun Web Stack (previously called Cool Stack) provides developers and systems administrators with a superior LAMP and SAMP stack for building and deploying Web services and applications. Using Sun's optimized Apache, MySQL, and PHP/Perl/Python stack with Solaris or OpenSolaris (SAMP), or Linux (LAMP), AMP-based web sites can easily be developed, tested, and deployed; they can be deployed faster and more efficiently; and support and consulting from Sun assures help when you need it most. (previously called Cool Stack) ってあるから、そういうことなのだな。それにしても、Python もちゃんとスタックの中に入っているんだから、ちゃんと Python についてもニュースで振れて欲しいものだ。ちなみに Python のバージョンは 2.5.2。mod_python も含まれている。これを機会にとりあえず Optimized Open Source Software Stack (Cool Stack) をインストールして、Solaris の環境を作り直そうかな。環境作り直しといえば、MySQL backups using ZFS snapshot を読んで、MySQLのバックアップを自動化するのに Zmanda を使ってみようかなと思った。オープンソース版と商用版がある。mysqldump データベースバックアッププログラム だと丸ごとバックアップを取ることになるけど、Zmanda の ZFS snapshot plugin でバックアップを取ればディスクの消費量も少なくてすむだろうし。ちなみに Zmanda Internet Backup to Amazon S3 みたいのも zmanda は出しているのね。Zmanda に関するメモ米Zmanda、オープンソースのMySQL用バックアップソフトをリリース(2006/09/28)MySQLのストレージエンジンを自動認識してバックアッププロセスを最適化するほか、自動バックアップスケジューラ、保存ポリシー、レポーティングなどの機能を備える。また、バックアップ先はローカルとリモートをサポートするZmanda Recovery Manager for MySQL (MOONGIFT)ZRM for MySQLはCUIベースのソフトウェアで、Perlで作られている。インストールをしたら、設定ファイルを作成し、後はZRM for MySQLを実行するだけだ。処理完了はメールで連絡を受け取る設定にもできる。cronに設定しておけば、日々待っているだけでバックアップが自動的に行われる。簡単な使い方は、How to setup and verify a backup solution for MySQL in 15 minutes - all using open source software!! にある。ちなみにこの文章は Fedora Core 5 向けに書かれている。MySQLオンラインバックアップの方法を見たら商用ソフトでは、INNODB Hot BackupZRM for MySQLNetVault BackupBrightStor ARCserveとかいろいろあるのね。InnoDB Plugin 1.0.1 for MySQL 5.1 Released を見たら GPLv2 のラインセンスだから、これも試してみるか。Hot Backup を見ると、オンラインバックアップは有償か。単純に自動バックアップするだけなら innobackup-1.4.0 の perl スクリプトがあればよいのかな。これも GPLv2。Hot Backup Features を見ると、Solaris も対応していた。Sun の Web Stack にはこうしたバックアップソフトも一緒にパッケージしてくれるとバージョン管理が楽でいいかもしれない。

2008.07.24

コメント(0)

-

Solaris Express Community Edition Build 91 と MilaX 等

Blade 1000 に Solaris Express Community Edition Build 91 をインストールし直した。OpenSolaris 2008.05 は SPARC 版がないから。以前のデータ用の ZFS の領域は、そのまま残してインポートしなおして upgrade したが問題なかったし、iSCSI の領域も大丈夫だった。Sun StorEdge D2 を買った も無事動いている。ディスクが1個動いていないと思ったけど、単に一つ pool に足すの忘れただけだったので、めでたしめでたしと思ったら、付け足したあと速度が遅くなってしまった。ちょっと実験してみる必要がありそう。んー、いやそういうことでなくて、Solaris 10 8/07 の方が HDD のアクセスが速いんじゃなかろうか。というか SXCE のディスクアクセスってもしかして遅いのかなぁ?ディスク 1台でやっても遅くなっている。最適化はやっぱり製品版の方がきっちりしているからその差かな。OpenSolaris の方はデバグ用のコードとかたくさん入っているとかあるのかな。Solaris 10 5/08 も試してみるか。ちなみに OpenSolaris 2008.05 を使っている場合、Update OpenSolaris 2008.05 to Build 91 in five steps (詳細は、Repository update: snv91)で、リポジトリが snv91 に上がっているので最新にできる。OpenSolarisのアップデート。MilaX という最小限の環境の Live CD もできあるのね。MilaX 0.3.1 LiveCD が 126.7 MB とコンパクト。Beaver, Gtk-Terminal, Vim, Netsurf, Sylpheed, Midnight Commander, emelFM, XMMS, Xpdf, VNC viewer, Rdesktop, Nmap, gFTP, gPicview, Conky, XChat, Xpad などが含まれている。USB メモリからでも起動できて、メインメモリも 256MB あれば動くらしい。GUI なしだと 128MB。これを VM で動かせば、軽い実験環境ができるな。見た目はこんな感じで でウィンドウマネージャは IceWM。パッケージは、How to use IPS pkg のように Indiana と同じ、IPS が使える。login ユーザは、alex、パスワードも alex。su - で root になるときはパスワード root。OpenSolaris and Linux on One USB Stick for Dual Usage のあたりも参照。普段、Linux を使っている人も、これを仮想マシンで動かせば OpenSolaris 環境を比較的低い負荷で動かしておけるかも。日本語環境がなくても気にしないような用途なら。OpenSolaris2008.05 LiveUSB Ver.2 イメージファイル公開 している日本の方がいらっしゃる。Firefox3、OpenOffice、DVDプレーヤー、NetBeans が入って、これ一つでDVD鑑賞(但しUSBメモリーにインストールした時のみ)、ワープロ、表計算、プレゼンテーションの作成、Javaアプリケーションの開発を行えます。らしい。ただし、MilaX のコンパクトさとは違って 1.5GB ぐらいなそうだけど。Solaris Express Community Edition に上記のものなど足しているから、当然、大きくなるということだな。OpenSolaris も、バリエーションが徐々に増えつつある印象。FUSE経由でZFSを使う とか記事があった。ZFS_on_FUSE で Linux でもZFS が使えるようだが、そっち方面はとりあえず見ない。

2008.06.25

コメント(0)

-

Sun StorEdge D2 を買った

古い Sun StorEdge D2 を買ってしまった。なんてものを買うんだぁ。個人でこなもの持っている人あまりいないだろう。Sun StorEdge[tm] D2 Array ね。腰が抜けるほど重い(30Kg程度)。運送屋のお兄ちゃんありがとう。発売された当時は サン、80万円台のディスクアレイ普及機(2002.4.25) ぐらいの値段だったものが、もうジャンク扱いなので送料、手数料込みで 1万3千円弱で買えた。最近の安い PC 用の外付け USB のハードディスク 1個の同じディスク容量のものを買うのとどっちが安いかといえば、そりゃ新しいハードディスクだし、中古の HDD なんていつ壊れるかというのもあるのだけど、ダブルパリティー RAID-Z (raidz2) の実験に使えるかなと。HDD が壊れる度に中古の入れていくと、障害時にどうなるか、いい実験になるかな。Solaris もアップグレードしなきゃ。まあ、違う性質のものを比べるのもなんなので、この手のものには、この手のもののよさはあるわけだし。値段が値段だけに、もしかしたら、動かないかなぁと思ったのだが、Blade 1000 に繋いだら、あっさらい動いてラッキー。ん、HDD 7台あるが 1台は HDD 認識してない。まあ、いいか。また買い足そう。probe-scsi-all したらハードは認識してくれた。format で見たら最初ディスクが見えなかったのだが、devfsadm したら format で見えるようになった。とりあえず、ストライプでプールを作って、ZFS ストレージプールの健全性状態を調べる。# zpool create storage c3t1d0 c3t2d0 c3t3d0 c3t4d0 c3t5d0 c3t8d0# zpool status -xall pools are healthy# zpool status pool: storage state: ONLINE scrub: none requestedconfig: NAME STATE READ WRITE CKSUM storage ONLINE 0 0 0 c3t1d0 ONLINE 0 0 0 c3t2d0 ONLINE 0 0 0 c3t3d0 ONLINE 0 0 0 c3t4d0 ONLINE 0 0 0 c3t5d0 ONLINE 0 0 0 c3t8d0 ONLINE 0 0 0ちょっとテストして# zpool iostat -v capacity operations bandwidthpool used avail read write read write---------- ----- ----- ----- ----- ----- -----storage 26.2G 176G 4 17 523K 1.76M c3t1d0 4.38G 29.4G 0 2 87.0K 300K c3t2d0 4.37G 29.4G 0 2 87.1K 300K c3t3d0 4.38G 29.4G 0 2 87.1K 300K c3t4d0 4.37G 29.4G 0 2 87.1K 300K c3t5d0 4.37G 29.4G 0 2 87.3K 300K c3t8d0 4.37G 29.4G 0 2 87.3K 300K---------- ----- ----- ----- ----- ----- -----# zpool listNAME SIZE USED AVAIL CAP HEALTH ALTROOTstorage 202G 26.2G 176G 12% ONLINE -ちゃんと動いているみたい。ゴミを買わずに済んでラッキー。ZFS の ZIL を USB フラッシュメモリにするの失敗 のときに USB メモリを使って試してみたりしたけど、これで、まともに使えるようになるので嬉しい。Solaris もアップデートして ZFS の ZIL をメインプールと別に用意すると書き込みが速くなるらしい を実験し直すかな。SSD の安いのが出てくるといいんだけど(ZIL と言っても Python の ZIL じゃなくて、ZFS Intent log)とりあえず、1GB のファイルを作ってテストをしてみると、ディスクアクセスが速くなった。これだけでも嬉しい。内蔵 HDD 1台の場合$ ptime mkfile 1g test.datreal 27.094user 0.217sys 6.250StorEdge D2 HDD 6台の場合$ ptime mkfile 1g test.datreal 6.364user 0.182sys 6.071まあ、高性能の 200GB のハードディスクを 1万3千円弱と考えると、なかなかよい買い物であった。今時の安いのと比べたら、やたら、でかくて重いからスペースのパフォーマンスは悪いけど。

2008.06.21

コメント(0)

-

Amazon EC2 で OpenSolaris を動かす (4) - Elasticfox を使う

Amazon EC2 で OpenSolaris を動かす (3) SXCE のイメージでテスト までで、とりあえず、Amazon EC2 を使えるようになったが、もう少し楽に使えるように Elasticfox Firefox Extension for Amazon EC2 (sourceforge: Firefox Extension for Amazon EC2) (elasticfox) も使ってみることにした。インストールは、http://s3.amazonaws.com/ec2-downloads/elasticfox.xpi からインストールした。インストール後の設定などは、Gigazine:「Amazon EC2」と「Amazon S3」を実際に使ってみた、今度はEC2の操作環境セットアップ など参照。とりあえずは、コマンドラインベースで作業する場合、ssh で接続するとき ec2-descrie-instances でインスタンスの DNS 名を調べて、「ssh -i keypairname root@DNS名」のコピーアンドペーストで接続していたが、Elasticfox の GUI からならもっと楽に接続できる。Elasticfox の起動中のインスタンスのリストから、SSH で接続したいホストを選択して右クリックし、[SSH to Public DNS Name] を選択すれば putty を起動できる。特に、複数のインスタンスを起動しているとき、コマンドラインだとどれがどのインスタンスだか見づらいので、コマンドラインでも、何かちょっとスクリプトを書いて、起動中のリストから選択できるようなものを作ってもいいのかもしれない。その場合、インスタンスのリストをキャッシュするようにしておいた方が快適に使えるかもしれない。ec2-describe-instances は結構反応が遅いから。ちなみに putty の秘密鍵は、ec2-add-keypair で表示されたものの -----BEGIN RSA PRIVATE KEY----- から -----END RSA PRIVATE KEY----- をファイルに保存したものをそのまま使えないので形式を変換しておく必要がある。putty-gen.exe で [File]メニュー [Load private key] を選択して読み込み、次に、[File]メニュー [Save private key] で保存し直す必要がある。さらに Elasticfox の Tools で SSH Arguments に -ssh を追加した。つまり、「-i "${key}" ${user}@${host}」ではなくて「-ssh -i "${key}" ${user}@${host}」に変更した。とりあえず、基本環境と AMI の作り方までは理解できたのでベースになるイメージを作り直して、必要に応じて複数のインスタンスを起動してやる方向で考えることにする。が、ベースになるイメージを SXCE (Solaris Express Developer Edition) で作るか、OpenSolaris のイメージが使えるようになるまで待つか、どうしようかなぁ。早く OpenSolaris のマシンイメージが一般に使えるようになると良いのだけど。傀儡師の館の Amazon 関連の記事Amazon EC2 で OpenSolaris を動かす (3) SXCE のイメージでテスト (2008.06.11)ZFS のスナップショットを Amazon S3 に保存する方法 (2008.06.09)Amazon EC2 で OpenSolaris を動かす (2) - S3 の復習 (2) (2008.06.07)Amazon EC2 で OpenSolaris を動かす (2) - S3 の復習 (2008.06.06)Amazon EC2 で OpenSolaris を動かす (1) (2008.06.05)Amazon SimpleDB (2007.12.22)Amazon S3 の SLA (2007.10.09)ZFS のスナップショットを Amazon S3 に保存する方法 (Python で途中まで) (2007.09.09)

2008.06.15

コメント(0)

-

Amazon EC2 で OpenSolaris を動かす (3) SXCE のイメージでテスト

Amazon EC2 で OpenSolaris を動かす (2) - S3 の復習 からの続き。その前にどうでもいいこと。米アマゾン・ドット・コムが2時間ダウン--トラブルの原因は? を読む。米国時間6月6日に発生したAmazon.comのサービス停止は約2時間で解消した。まだ、Amazon もと待っちゃうことあるのね。バックアップのために S3 を使う程度であれば、その程度であれば許容範囲なのだけど。でも、クリティカルなインフラを載せていたら、やっぱり勘弁してくれよなぁとなっただろうな。そういえば 「米Amazon.comがダウン、株価が下がっている」、新手の迷惑メール出 は、私のところにも送られてきた。かなり広範囲に送られているようだ。メールにはロイターの報道によるとと書かれているのだが、記事ではロイターについて触れられていない。まあ、本質とは関係ないのだけど、日経の報道によるとではないのが、世界の日経じゃないところだな。トヨタが標的にされるとしたら Nikkei になるか Reuters になるか。これはおもしろいところだ。何はともあれ、 2007年中は、特定企業の株価を上げることを目的に、その企業に関する偽情報を流す「パンプ・アンド・ダンプ(pump and dump)」と呼ばれる迷惑メールが大量に出回った。ソフォスによれば、全迷惑メールの30%がパンプ・アンド・ダンプだったという。同社によれば、パンプ・アンド・ダンプでは、株価の低い小規模企業が対象になるのに対して、ショート・アンド・ディストートでは、アマゾン・ドット・コムのように有名で大規模な企業が対象になるとしている。また、バズワードを覚えることになってしまったが、その手の spam は確かに多い。ちなみに、記事にはちゃんと Short-and-distort stock spam? のリンクが張られているのがいい。そこからさらに The Short And Distort - Stock Manipulation In A Bear Market の記事にたどり着ける。But the short-and-distort type of short seller uses misinformation and a bear market to manipulate stocks. Short and distort is as illegal as the pump and dump, but is mainly used in a bear market. It is important for investors to be aware of the dangers and to know how to protect themselves.ということで、通常の短期の空売り(short selling) とは違って、偽の情報を流しながら不安を煽って売り込んで行くやり方ということで、まあ、日本では普通にやられていることだな。日本の場合、マスメディアが進んで便乗するから質が悪い。NHKや野村證券の個人のインサイダー取引よりも、マスメディアを使った情報操作の方が悪質。しかし、これはなかなか犯罪として立証するのは難しい。おもしろいのが Amazon の株価のリンク が Google であること。Yhoo! Finance じゃないのね。あるいは、その筋のものでもなく。よく見ると、カナダの Google のサイトなのがおもしろい。Tronto か Vancouver の人が書いたのかな。それはどうでもいいけど、Google Finance みたいなものがあるから Google Chart ってできたのかな。なんか、またグレードアップしてる。サービス停止といえば、はてなが止まっているのは直ったのかなと見てみると、直っている。明け方アクセスしたら止まっていた。止まってみると、あぁ、自分が読んでるブログって、そこそこの数、はてなに置かれてたのねぇと改めて思った。でも、楽天ブログなんか、正式メンテナンスでしょっちゅう止まっているものねぇ。その上、メンテナンス予定時間より長くかかることも多々あるし。。。。。前置きが長くなったがまた、マシンが欲しい病が復活してきたので、いよいよ Amazon EC2 を使ってみることにする。とりあえず、まず、はじめてのAmazon EC2&S3 ~これからの新サービスの公開の形~ 第3回 Amazon EC2でサーバを立てよう を参考にやってみる。ちなみに、インスタンスのシャットダウンの仕方は第4回にある。これって、第3回と第4回って同時に公開されたんだろうか。第3回の記事だけ見てやろうとした人はシャットダウンの仕方が分からなくて困っちゃうのだな。Amazon Web Services Developer Connection から、リンクをたどって Amazon EC2 Command-Line Tools をダウンロード。記事の手順に従って、とりあえず試してみる。欲しいと思ったら、すぐに新しいマシンが手に入るというのは嬉しい。もっとも、物欲は満足できないが。。。。たぶん、欲望からするとマシンを買って所有するということ自体にも意味があるんだろう。というのはさておき、ami-eb7a9f82 も動かしてみる。これは、OpenSolaris 2008.05 ではなくて Solaris Express Community Edition (SXCE.79) なのね。OpenSolaris 2008.05 はまだ使用できるユーザーが限定されているらしいので、仕方なく SXCE を使うことにした次第。新しいマシンイメージの作り方については、OPENSOLARIS OPERATING SYSTEM GETTING STARTED GUID FOR AMAZON EC2 の Rebuilding and uploadin OpenSolaris images on Amazon EC2 を見ながらやってみる。ここに書かれているのと同じ手順でできた。はまるところといえば、タイプミスをしないように気をつけることと、vbdcfg コマンドで root.file アーカイブを作ったあとにbash # $BUILDDIR/xc/xvm/myImage/root.fileというところは、単にそういうファイルができているということだけで、コマンドを実行するところではないというところ、そして、ec2-bundle-image の --user オプションで指定するのは、ACCESS_KEY や SECRET_KEY の類ではなく、Amazon Web Services サイトでログインして Your AWS Profile ページを表示したときに出てくる Account Number ということ。しかし、やたらと時間がかかった。特に system flash archive を作成する flar コマンドを使っているところと、Amazon EC2 インスタンスのリビルドに vbdcfg コマンドを使っているところはかなり時間がかかる。コマンド打ったらしばらく放置モード。作成したイメージを S3 に転送するところは数分で終わる。コスト的には、半日動かしておいても、ネットワークのトラフィックがほとんどなければ、アイスクリーム一つ食べるのを我慢すればいい程度。とりあえず、動かして、マシーンイメージの作成も成功したので、いろいろ遊んでみようかと思う。これは価格的にもリーズナブルで、とてもいいサービスだと思う。ただし、ターミナルで入って操作した感じ、やっぱり遠くにあるなぁという印象。日本にもこれ用のデータセンターが早くできるといいのだけど。あとは、OpenSolaris のイメージが早く使えるようになるといいのだけど。

2008.06.11

コメント(0)

-

Amazon EC2 で OpenSolaris を動かす (2) - S3 の復習 (2)

Amazon EC2 で OpenSolaris を動かす (2) - S3 の復習 の続き。EC2 を使う前にもう少し S3 の復習をしておく。とりあえず、これまであれこれ調べたもののまとめをしておく。ちなみに、EC2 や S3 そのものについては、Amazon EC2/S3を使ってみた - まとめ がよくまとまっていて参考になる。S3 をファイルシステムにマウントするのとかも、そのうちやってみるつもり。Fuse on Solaris とかあるので、なんとかなるだろう。とりあえず S3 をファイルシステムとして使うときに参考になるものをメモ。Amazon EC2/S3を使ってみた - 5.S3をファイルシステムとして扱うs3fs - Google CodeFuseOverAmazon - s3fs - Google CodeMOONGIFT:>> Amazon S3をマウントする「s3fs」:オープンソースを毎日紹介Python で S3 を使うときに参考になるもの下のものは S3 をバックアップメディアとして使った例。Incremental backups to Amazon S3Duplicity + Amazon S3 = incremental encrypted remote backupHow I'm using Amazon S3 to serve media files (update_s3.py)Backing Up Flickr Photos with Amazon S3Duplicity についてduplicity (Encrypted bandwidth-efficient backup using the rsync algorithm) を使えば、ファイル圧縮転送されるので、単純に rsync するのに比べてネットワークの使用帯域が抑えられる。また、全部をバックアップするのでなく、インクリメンタルにバックアップが行えるので、S3 のように従量制の課金が行われるサービスを使うときには、お金の点でもメリットがあるだろう。リモート上で圧縮されていないローカルとミラーな状態を作りたければ rdiff-backup もある。S3 などは関係なくても、duplicity は要チェックかもしれない。Tim McCormackさんの Duplicity + Amazon S3 = incremental encrypted remote backup は、duplicity (Encrypted bandwidth-efficient backup using the rsync algorithm) を使って GnuPG で暗号化し librsync で圧縮した上で rsync するような話が書かれている。Grig Gheorghiu さんの Incremental backups to Amazon S3 は、これを CentOS 5.1 と Python 2.5 で実際に試した手順等が書かれている。duplicity を動かすには、boto, GnuPGInterface, librsync, duplicity などが必要。boto や GnuPGInterface For Python などは pure python なので Windows 上でも動かせるだろうが (gnupg は、Windows のバイナリもあるし)、librsync などは cygwin とか使っていないと Windows では厳しいか? 試していないので不明。duplicity は便利そうなのでそのうち使えるようにしてみようかな。Solaris 上でうまく動かせるだろうか。だめでも、zfs のスナップショット単位に tar.gz ファイルを作ったものを暗号化して、S3 上にバックアップしているのと、インクリメンタルに rsync しているのと、それほど変わらないだろうから使えなくても困らないけど、そのうちパフォーマンス的にどうかも調べてみたいところ。そのうち Duplicity については調べて使えるようにするつもり。update_s3.py についてfind | grep -v ".svn" | python /path/to/update_s3.py のように、find を使って抽出したファイルのリストを作っておいて S3 にバックアップする短いスクリプト(標準入力からファイル名を渡して、そのファイルをアップロードするもの)。mimetypes.guess_type で mime-type を判定して、それに従ってアップロードしている。update_s3.py を使うには S3.py が必要。AWS_ACCESS_KEY_ID, AWS_SECRET_ACCESS_KEY, BUCKET_NAM の CHANGE と書かれているところを書き換えれば、簡単に使える。ただし、このままの状態で使うと 'x-amz-acl': 'public-read' になってしまうので、公開したくなければ private に書き換えないとダメね。Backing Up Flickr Photos with Amazon S3Backing Up Flickr Photos with Amazon S3 は、flicker の写真を S3 に保存するシンプルなスクリプト。flickrbackup.py がそのスクリプト。James Clarke さんの flickr.py と BitBucket を使っている。S3 対応している Python のライブラリ等私が今使っているのは boto。boto (Python interface to Amazon Web Services)Amazon S3 Library for REST in PythonBitBucket (BitBucket 0.4a)Python-Amazon 0.5 (python-amazon (Python modules for Amazon web services))duplicity (Encrypted bandwidth-efficient backup using the rsync algorithm)python-amazon についてまだ、試していない。python-amazon の最新版は次のようにダウンロードできる。svn checkout http://python-amazon.googlecode.com/svn/trunk/ python-amazon-read-onlyまたは、Python-Amazon 0.5 の python-amazon-0.5.tar.gz をダウンロードしてインストールするか、easy_install Python-Amazon でインストール。easy_install は、"Could't find a setup script ..." でエラーになった。S3 と SQS 用の 2つのライブラリがあるが、セットアップスクリプトがないので、インストールできない。手動で lib/site-packages にコピーする必要がある。ドキュメントはきちんとしているので、そのうち、セットアップスクリプトも入ってくるだろう。Amazon Web Service 関連の私の過去の記事とりあえず、これまで書いたものをリストアップしておく。Amazon EC2 で OpenSolaris を動かす (2) - S3 の復習 (2008.06.06)Amazon EC2 で OpenSolaris を動かす (1) (2008.06.05)Amazon SimpleDB (2007.12.22)Amazon S3 の SLA (2007.10.09)ZFS のスナップショットを Amazon S3 に保存する方法 (Python で途中まで) (2007.09.09)

2008.06.07

コメント(1)

-

Amazon EC2 で OpenSolaris を動かす (2) - S3 の復習

Amazon EC2 で OpenSolaris を動かす (1) で OpenSolaris AMI の申し込みをしたと書いたが、登録は樹里されたが、残念ながら、現状ではテストも十分でないので人数制限をしているらしく OpenSolaris 2008.05 AMI は使えないよとメールが来た。残念。ゆえに、使えるようになるまでこのシリーズは終わらないwでも、SXCE (Solaris Express Community Edition) なら使えるよとのことなので、そちらを使うことにする。メールに 32-bit AMI と 64-bit AMI の両方の AMI の名前が書かれている。64bit AMI の方は AMI ID を見ると OpenSolaris (SXCE) AMI for Developers. だった。まあ、とりあえず使える状況が整ったのでやってみる前に、準備運動として、第2回 Amazon S3をバックアップストレージとして使おう を見る。S3 は Python からも使えるのだが、Ruby がこの記事では使われているので、たまには Ruby を使ってみる(使ってみた)。AWS-S3 を使って、バケット一覧の取得と、ファイル一覧の取得、ファイルの保存をやっている。なるほど、Ruby だとそう書けるのね。ついでなので Using Amazon S3 from Amazon EC2 with Ruby あたりも見てみる。S3Sync.net の s3sync や s3cmd は使えるかも。How I automated my backups to Amazon S3 using s3sync を見ると、ssl にも対応している。とりあえず、「Amazon S3をバックアップストレージとして使おう」の記事の方に戻って、自分は Python を使うので同じようなことを Python で書いてみる。Python から使える S3 を扱うためのライブラリには、Amazon S3 Library for REST in Python と boto - AWS for Python (http://boto.googlecode.com/) あたり。他にも探すと、サンプルコードがいろいろ見つかるが、ライブラリとしてちゃんとメンテナンスされて期待が持てそうなのは boto (Python interface to Amazon Web Services) に思えるので、これを引き続き使う。boto って何かと思ったら、アマゾン河に住んでいる淡水イルカの一種 Boto (Wikipedia) だったのね。「Amazon S3をバックアップストレージとして使おう」だと bucket 名が 'webdbpress' になっているが、実際にはアクセスできないので、別な名前を使う必要がある(あらかじめ自分で作っておく必要がある)。バケット一覧の取得ls_buckets.rb 相当の ls_buckets.py#!/usr/bin/env python# -*- coding: utf-8 -*-from boto.s3.connection import S3Connectionfrom boto.s3.key import Keyconn = S3Connection('<Access Key Id>', '<Secret Access Key>')rs = conn.get_all_buckets()print rs[<Bucket: bkttest20080606>]ファイル一覧の取得ls_webdbpress.rb 相当の ls_bucket.py#!/usr/bin/env python# -*- coding: utf-8 -*-from boto.s3.connection import S3Connectionfrom boto.s3.key import Keyconn = S3Connection('<Access Key Id>', '<Secret Access Key>')bucket = conn.get_bucket('<your bucket name>')for key in bucket.get_all_keys(): print key.nameファイルの保存tar ファイルを作るのをコマンド呼び出しでなく、Python のライブラリを使っているので若干長くなった。加えて、ファイルのアップロードはもっとよいやり方あるのかな。s3_backup.rb 相当の s3_backup.py#!/usr/bin/env python# -*- coding: utf-8 -*-import osimport timeimport tarfileimport tempfilefrom boto.s3.connection import S3Connectionfrom boto.s3.key import Keyconn = S3Connection('<Access Key Id>', '<Secret Access Key>')bucket = conn.get_bucket('<your bucket name>')folder = "/work/%s" % bucket_namekey = "%s.tar.gz" % time.strftime("%Y%m%d%H%M%S", time.localtime())tar_file = tempfile.mktemp()[1]tar = tarfile.open(tar_file, "w:gz")for name in os.listdir(folder): tar.add("%s/%s" % (folder, name))tar.close()bucket = conn.get_bucket(bucket_name)k = Key(bucket)k.key = keyk.set_contents_from_filename(tar_file)print "Backup to %s/%s" % (bucket_name, key)とりあえず、S3 の復習をしておしまい。明日以降に、EC2 を動かしてみる。

2008.06.06

コメント(0)

-

Amazon EC2 で OpenSolaris を動かす (1)

Microsoft Silverlight のオープンソース版の Moonlight を試そうと思いつつ、それっきりになっていた。けど、とりあえず、今その気分じゃないので放置。マイクロソフト、「Silverlight 2.0」ベータ2をリリース とか見て、またちょっとやってみるかと思ったがやっぱりやめた。Jython も Jython 本買おうかと思ったのだが、まだ先延ばし。マシンが遅くて苛つくことが多いので、新しいマシンを買いたいという衝動に突き動かされる今日この頃、この物欲を抑えるために、また、Amazon EC2 に近づく。Google App Engine は Python の世界なのでひいきにしたいところだが、Django はまだ覚えてないし、CPU 食うような処理を別マシンでやらせたいので、現状では EC2 の方が使いたいところ。Django を使ったものを何か作ったら、Google App Engine で公開するだろうけど、いつになるか分からにゃい。サーバレベルでの管理が不要だから楽だもんね。けれど、素朴な疑問、C の拡張モジュールとか使うときはどうなんだとか、そういう話があるだろうから、そういう標準のモジュール + Pure Python のモジュールで片付かないようなものの場合は、Amazon EC2 とか使うことになるのかな。Webサービスのスケールか、汎用分散処理か グーグルとアマゾンのクラウドの違い とか、ついでにクラウドつながりで 「Microsoftが何百万台ものサーバーを運用するようになる」,Gates会長が最後の基調講演 あたりも読む。とりあえず、Amazon Web Service の Amazon Elastic Compute Cloud (Amazon EC2) - Beta から EC2 の登録をして (Amazon Simple Storage Service (Amazon S3) はすでに使っている)。Amazon Web Service を見たら、High-CPU Instances Now Available (Amazon EC2 Instance Types) とかあって、デフォルトの 1.7GB メモリ、1 EC2 Compute Unit 、160 GB instance storage、32-bit platform、I/O Performance: Moderate がインスタンスに対して1時間あたり $0.10 が課金されるのに対して、一番高い、Extra Large Instance だと 15 GB memory 8 EC2 Compute Units、1,690 GB instance storage、64-bit platform、I/O Performance: High が 1時間当たり $0.80 と 8 倍の値段だが、1ヶ月のうち、数日フル稼働させるだけとかいう使い方だと、これもありだなぁとか思ったりする。あるいは CPU だけ必要なら High-CPU Instances で High-CPU Medium Instance 1.7 GB of memory、5 EC2 Compute Units、350 GB of instance storage だと $0.20 だし、High-CPU Extra Large Instance だと 7 GB of memory、20 EC2 Compute Units だと 1時間 $0.80。個人じゃ絶対に買えないような環境が使えるのは嬉しい。さまざまなインスタンスタイプを用意して、用途に応じた借り方ができるわけね。良い方向だと思う。Amazon SimpleDB や Amazon Simple Queue Service (Amazon SQS) もそのうち試してみようかな。SQS については、Whitepaper: Using Amazon EC2 and SQS とか見ると利用イメージがよく分かる。そこまで実際に自分が必要かというとそうではないのだが興味本位で使ってみたいかなと。とりあえず EC2 が先なので、OpenSolaris on Amazon EC2 のあたりを読んで、OpenSolaris on Amazon EC2 の登録をすると、確認のメールが来た。この登録は OpenSolaris AMI (Amazon Machine Image) を使うために必要なもののようだ。Getting Started を読むと、登録後は、Amazon Web Services Developer Connection や Amazon Elastic Compute Cloud Getting Started Guide (API Version 2007-08-29) (これは通常の EC2 サービス全般のお話)、Getting Started Guide for OpenSolaris on Amazon EC2(これは OpenSolaris 用に書かれたもの) を読んでやってくれろと。Linux と同様、OpenSolaris も Amazon EC2 AMI Tools や Amazon EC2 Command-Line Tools というコマンドラインツールを使って、イメージファイルを S3 にアップロードして起動する流れは変わらないようだ。Docs: Amazon EC2 (API Version 2008-02-01) のドキュメントもダウンロードしておく。基本的に、AMI (Amazon Machine Image) が違うだけで、手順の基本は Linux とだいたい同じになるのね。イメージを作るところとかは、上記のドキュメント読んだ方がよさそうだけど。「ec2-describe-images | grep b79alatest.img」でイメージは探せばよいようだ。だから、Introduction to Amazon EC2 とか、はじめてのAmazon EC2&S3 ~これからの新サービスの公開の形~ のあたりを参考にすればよいかな。Amazon Machine Images (AMIs) を見ると、いろいろあるのね。OpenSolaris 関連は、(1)OpenSolaris (SXCE) AMI for Developers. This image is provided by Sun Microsystems, Inc. 、(2) OpenSolaris ( SXCE ) GlassFish AMI provided by Sun Microystems, Inc. 、(3) Document Type: Public AMIs OpenSolaris AMI for Developers. This image is provided by Sun Microsystems, Inc. の 3つがある。SXCE (Solaris Express Community Edition) に Glassfish が入ったものと入ってないものが (1)(2)。(3) が OpenSolaris 2008.05 なので、(3) を使うことにする。OpenSolaris FAQ for Amazon EC2 users あたりも読んだ方がよさそうね。pkg install amp-dev コマンドで、Web Stack Packages をインストールできるとかいう話もここを見ると分かる。とりあえず、下調べここまで。明日以降に実際に動かしてみる。以前に AWS 関連について書いたものAmazon SimpleDB (2007.12.22)Amazon S3 の SLA (2007.10.09)ZFS のスナップショットを Amazon S3 に保存する方法 (Python で途中まで) (2007.09.09)そういえば、Amazon S3 に ZFS のスナップショットを保存する方法を途中まで書いて止まっていたなw

2008.06.05

コメント(0)

-

OpenSolaris をちょい動かす

OpenSolaris をインストールしようと思いつつ、伸び伸びになっていたので、とりあえず VMWare 上で動かしてみることにした。OpenSolaris Project: 日本ポータル も、徐々に日本語情報が増えてるのかな。OpenSolaris コミュニティ: ZFS とかも、日本語訳が全部ではないけどある。OpenSolaris コミュニティ: 高可用性クラスタ とかは、まだ翻訳が出ていない。けど、とりあえず @IT に 第5回 可用性を高めるOpen HA Cluster の記事がある。でも、さすがに Open HA Cluster は環境的になかなか気軽に試せないな。とりあえず LiveCD で起動してみると、デスクトップに OpenSolaris 2008.05 入門があるので見てみる。LiveCD 上で root の権限を得るには、pfexec su コマンドを使うのね。これで RBACK が操作を承認できるようになると書かれている。通常のユーザは jack にパスワードは jack。root のパスワードは opensolaris。LiveCD でそのまま遊んでもいいけど、ハードディスク上にインストールしてみる(VMware上でだけど)。インストール画面はきれいでいい。見かけの印象も大事だものね。デスクトップは Gonme だし、Linux ユーザもまったく抵抗感を感じないだろう。スクリーンショットたくさん入れるの面倒なので OpenSolaris 2008.05: Sony VAIO VGN-SZ72B にインストールしてみる とかの画面参照。とりあえずこんな感じのデスクトップとインストール画面。GRUB の画面もきれい。ログイン画面もきれい。ちょっと見た目は Gnome で Linux と同じ世界に入ったから、あとはパッケージのインストールが Linux 並になってくればなと。いいかげん実機の方もインストールしなおそう。とはいえ、こういうのはめんどくさがりの性格上、勢いでやらなきゃできないが、今は勢いがないので先延ばしw OpenSolaris2008.05環境でのPython Tracing とか見てみる。IPS(Image Packaging System)やxVMをはじめ多くのツールなどがPythonにて、提供されております。実は、xVMが入ってきた当時、USDTにて、PythonのDTrace Probesが入ってました。HotTopicsセミナーで何回か紹介したのですが、DTraceにて、Pythonの追跡ができるようになっております。おぉー、こういうことできるのね。やっぱり DTrace ちゃんと勉強しよう。パッケージ管理システムには Python で書かれた IPS(Image Packaging System) が採用されているようだが、とりあえず Image Packaging System Documentation の Getting Started With the Image Packaging System あたりをちらと見る。これを見ると分かりやすいか。パッケージのインストールは GUIをとりあえず使うのありだな。(JA) IPS on OpenSolaris 2008.5 とか見ると、IPSとして追加されたコマンドはpkg, pkgsend, pkg.depotd で、パッケージの追加、削除など、主に利用するコマンドは pkg コマンドのようです。 pkgコマンドは感覚的には yum に近いです。 install, list等々のコマンドの使い方もかなり似ています。それにimage-create等のオプションが追加された感じでしょうか。ということらしい。

2008.06.03

コメント(0)

-

Amazon EC2 が OpenSolaris に対応

OpenSolaris on Amazon EC2 が始まったのね。Sun is offering two Amazon Machine Images (AMIs) in the beta program:OpenSolaris OS 2008.05 - Sun's first supported offering of OpenSolaris (formerly known as "Project Indiana") Solaris Express Community Edition - Sun's binary release for OpenSolaris developers based on the latest OpenSolaris source base (code named "Nevada")そういえば、OpenSolaris OS2008.05 (いわゆる Project Indiana もの) が、リリースされたということで、そろそろ、手持ちのマシンに入れたいなぁとか思っているのだが、なにせ非力なマシン、Virtual Machine 上で動かしても遅い。実機で動いているものを入れ替えるのもとりあえず面倒。新しいマシンを買わずに、こいつでいくかなぁとか密かに思っていたりする。他人にサービスを提供するためじゃなく、使いたいときだけ動かしてというのであれば、一ヶ月あたりの維持費も抑えられるかなと。とかいいながら動かしっぱなしにして月に1万円ぐらいかかっちゃいましたとか、気がしないでもないが、まあ、年間にならしたときに、あまり高く付かなければいいかなと。ということで、毎日ちょっとずつ調べて、動かす方向で考える。とりあえず、Amazon Machine Image (AMI) として、OpenSolaris OS 2008.05 を使うのか、Solaris Express Community Edition を使うのか検討するか。そのためにはローカルで両方が動く環境を用意して、動かして、あぁ、やっぱり新しいマシンが欲しい(爆)あぁ、でも、Solaris Express Community Edition (SXDE) のページを見たら、Note: This marks the end of the SXDE program. To provide a smooth transition, the SXDE 1/08 site will remain available through July of 2008. At that time, the site will be taken down and links redirected to the OpenSolaris site. Existing SXDE documentation will remain available on docs.sun.com and at the Solaris Developer Center. Thank you for your support and participation. We look forward to seeing you at opensolaris.com.このプロジェクト SXDE の橋渡しの役割は終わったから、OpenSolaris の方が本筋で Go! Go! になるのね。ということで、OpenSolaris OS の方を使ったほうがいいのかもね。EC2 もちょっとあれこれまじめに調べてみるかな。

2008.05.06

コメント(0)

-

仮想化技術とプロジェクト Indian

Solaris/OpenSolaris Hot Topics #2~ ~ 仮想化技術とプロジェクト Indiana ~ ~ が、2008年05月09日(金)サン・マイクロシステムズ株式会社 神宮前オフィス B1F セミナールームで開かれるらしい(申し込み開始日時は 4月25日(金) 17:00)。無償だし、行きたいところなのだがうーん出不精なのだよなぁ。ストリーミングで流して欲しい。そういえば、Nexenta Operating System は Nexenta Core Platform 1.0 がリリースされているし、BeleniX 0.7 Released だし、常時動かしているマシンもアップグレードしようと思いつつそのままになっている。冷蔵庫買うときに HDD も買って、丸ごと入れ替えるかな(どういう脈絡なんだか、要するに気分と勢いの問題)。インテルは 次のIntelの価格改定は7月、最新のクアッドコアCPUが半額に らしいので、新しいマシンもそのうち欲しい。

2008.04.24

コメント(0)

-

FreeBSD 7.0 が ZFS に対応

japan.internet.com Webテクノロジー - 性能が大幅に向上した『FreeBSD 7.0』がリリース を読む。主な改善点は、旧バージョンの FreeBSD 6.x 系に比べて高負荷時のピーク性能が1500%向上したことだ。って、何が 1500%向上なのか分からない。高負荷時のファイルIOなのか、ネットワークIOなのか、何がよくなったのかな。FreeBSD Projectを見てみると、ベンチマークの詳細は分からないけど、スレッド処理を始めとしてベーシックなところで改良が入っているから全般的に速くなりそうな感じか。SMP 関連の改良も 8 CPU までリニアにパフォーマンスがよくなっていくらしいのがすばらしい。Dramatic improvements in performance and SMP scalability shown by various database and other benchmarks, in some cases showing peak performance improvements as high as 350% over FreeBSD 6.X under normal loads and 1500% at high loads. When compared with the best performing Linux kernel (2.6.22 or 2.6.24) performance is 15% better. Results are from benchmarks used to analyze and improve system performance, results with your specific work load may vary. Some of the changes that contribute to this improvement are: * The 1:1 libthr threading model is now the default. * Finer-grained IPC, networking, and scheduler locking. * A major focus on optimizing the SMP architecture that was put in place during the 5.x and 6.x branches.Some benchmarks show linear scaling up to 8 CPUs. Many workloads see a significant performance improvement with multicore systems.1500% というのは高負荷時の特別な場合のベンチマークなので上記のようなところが効いてくるのだな。でも、通常の負荷でもピークパフォーマンスが 350% 高速化されたものがあるようだ。最速の Linux カーネルと比べて 15% 速いらしい。何にも増して ZFS 対応が入っているから、これで FreeBSD、MacOS でも ZFS が使えるようになって、ZFS の利用者が増えるのがいいなぁと。とか書いておいて、最近、FreeBSD 触ってない。けれども ZFS を使う人が増えてくると、あれこれツールとかも出てくるかなぁとか、そういうところを期待していたりする。

2008.03.04

コメント(0)

-

OpenxVM, VirtualBox, OpenSolaris Deloper Preview 2, Solaris Express Developer Edition 1/08

Sun,仮想化対応のデータセンター管理ツール「xVM Ops Center」を提供開始 らしいので、OpenxVM.org を見てみる。ついでに VirtualBox も見てみる。そういえば IBM は Xen ベースに Virtual Iron とかやっているのね。HP は仮想化で開発インフラを“パッケージ化”――日本HPが新サービスを提供開始 (2008/02/20) とかだし。まあ、世の中、仮想化、仮想化で流行になってきた。でも、VmWare なんかもすでに EMC に買収されちゃっているわけで、ハードウェアを作っている会社の一部として生き残っていく技術に過ぎなくなっちゃっているわけだし、Sun が OpenVM とかいう動きを見せたりしているのもその一環だろうと。OS の仮想化とかいっても、結局はハード屋さんがついてきてくれなきゃ、効率的なものは作れない。マイクロソフトの Hyper-V にしたって、インテルがつるんでいるからこそだろうし。とかいうのはさておき、とりあえず、VirtualBox とか試してみる。とりあえず Windows 版を試す。Solaris Express Developer Edition をインストールしてみる。使えそうな感じ。ついでに、 OpenSolaris Project: Indiana はどうだろうということで、OpenSolaris Developer Preview 2 も試してみる。期待はしているけど、日本語がまだ簡単に使える状態じゃなさそうなのでちょこっと動かしただけで止める。Akira Ohsone's Weblog: プロジェクトIndiana Preview2 とか見ると、現在のIndianaのパッケージは基本的にNevadaのSVR4パッケージから生成されている(よう)です。元になっているNevadaのbuild 79bは1900個位のパッケージがありますから、まだまだ半分位しかないのでしょうか。ざっと見た感じではまだまだローカリゼーション関連は入っていないようです(ま、その辺を詰めるためにまもなく出張する人間が近くに座っていますけど :-)。とかあるので、期待してしばらく待つことにする。現状、Solaris Express Developer Edition をベースに Blastwave でパッケージ管理が楽で実用的だと思う。最初は、Sunfreewareのパッケージも使っていたのだが、Blastwave の方がインストール時に依存性も自動的に解決してくれて楽なので、若干、バージョンが古いことは我慢して Sunfreeware の方は基本的に使うのを止めた。DebianベースのGNU/Solaris OS Nexenta OS が日本語を簡単に扱えるようになったら、それもありかなとか思っているけど、これもまだっぽいので放置。OS 日本語化大好きオタクだったら日本語使えない方が楽しめるんだろうけど。。。。。一回バイナリインストールで慣れちゃうと、ソースを取ってきてコンパイルしてっていうのは、特別なことがないかぎり、めんどくさくて嫌ってなってしまった。Solaris Express Developer Edition だったら ATOK も使えるし、最低限必要なものは入っているので一番楽。時間がないので OpenxVM はまたの機会に試すことにする。とりあえず、Solaris は Solaris Container もあるから、仮想環境を作るのに選択肢の広さからすると最強となったんじゃなかろうか。とりあえず、何でもありになった。パフォーマンスや安定性の点では OpenxVM をまだ試していないので Linux 上で Xen を動かすのと比べてどうなのか分からないけど。Solaris だけなら Container の方が速くて安定しているわけだから、OpenxVM で別の OS を動かしたときにどうかってところ。それがよいパフォーマンスで安定して動くのであれば、Solaris をベースに他の OS を仮想サーバとして動かすっていうのもいい選択肢になる。Dellとの提携が意味するもの を読む。まあ、DELL は売れれば何でもやるからそれほどの意味はないかと思う反面、一定の数は出るだろうということで提携したのだろうから、やっぱり意味あるな。世界中に流通しているSolarisインスタンスの約3分の1がDellで稼動していることは、注目に値することです。これは確かに、サンとDellの双方にとって、提携の動機となります。ちなみに、私の Solaris も Dell で動かしている(別に SPARC マシンもあるけど)。安いところは Dell に渡しちゃうのは仕方ないという割り切りなのだろうな。では、Solarisをサン独自のハードウェアに閉じこめておかずに、こうしたパートナーシップを結ぼうとするのはなぜでしょうか(そうなのです、いまだにこういった質問を受けます)。それは、Solarisの使用をサンのハードウェアに限定することは、ワイヤレス通信事業者がローミングのできない電話を販売するようなものだからです。また、自動車メーカーが、車を買った客にそのメーカーからガソリンを買うことを義務づけることと同じです。自動車メーカーが、車を買った客にそのメーカーからガソリンを買うことを義務づけることと同じです。という喩えは、けっこう使えるな。ちなみに、プリンターやコピー機は、車を買った客にガソリンも売ることで成り立つような産業だったりするから、ビジネスモデルに大きな違いがある。驚くべきなのが、最も重要なパートナーはRed Hatです。同社は、Microsoftのように、同社のハイパーバイザーについて、相互運用性の提供を予定しています。昔、母親に言われたとおり、良いゲスト、そして良いホストになることが大事なのです。私たちは、その両方になろうとしています。というところかな。ハードウェア Sun、Solaris 上で Red Hat 動かすありだし、Red Hat 上で Solaris 動かすありだしというところで、Sun のハードウェアが売れる素地も用意するということか。良いゲスト、そして良いホストのお利口さん。結局、大きいソリューションとして Sun の技術を選んでもらえれば、全体としてペイしていく構造を作り上げていくということなんだろうな。Java はすでに勝者なわけだし。そういえば、IBM、コンピュータメーカーへ大回帰 コンサルとの「死の谷」越えられずIBMは今回の再編で、ハードの製品営業による「最適なIBMハード」の顧客別の直接販売を推進すると同時に、パートナーやディストリビュータの再編を図るこの動きって、実は仮想化マンセー時代になってきたからというのもあるかもしれない。細かいのちまちま売るでなく、でかいのがーんと入れて仮想化マシンたくさん動かしてとかいうことになると、ハード売りに力を入れるのも分かる気がする。だから回帰というより、ハードでおいしく儲けられる可能性に賭けているんじゃなかろうかと。大企業が Dell のサーバマシンをちまちま沢山入れるのと、IBM のドカーンと入れるのと比較して入れてくれるような素地ができているわけで。中小企業にしても、だんだんと使い方が高度化してきて、おいしいところも出てきているわけだし。単にハードの売上げが落ちてきたから再編というより、再編コストをかけても、今より良くなる可能性が高いからじゃなかろうか。単純な回帰じゃないでしょ。一時はじり貧かとも思われた Sun がハードウェアのメーカーとしても盛り返してきたこととかも関係しているかもしれない。その時々でバランスは変わるもんだと思う。関係ない話として CLRとJVMにおける動的言語 を読む。MicrosoftのDynamic Language Runtime みたいなものの Java 版として Da Vinciプロジェクト なるものがあるのね。the Da Vinci Machine: a multi-language renaissance for the Java Virtual Machine architecture ということで。Python が動くようになったら試してみたい。まあ、いつだか分からないけど。もちろん、どちらのアプローチもそれぞれ長所と短所がある。Microsoftがとったライブラリのアプローチでは、市場に出すまでにかかる時間が短く、そして修正したものはCLRとは別に出荷することができる。Sunのアプローチはすでに優れた性能を出している(Da Vinciが無くても、JRubyは既にオリジナルのCコードのバージョンのRubyよりも優れたベンチマークの性能を示している)が、開発のサイクルはかなり長くかかっている。IronPython も CPython より速かったりして、仮想マシンだから遅くなるんじゃないのという期待を裏切るところがおもしろい。というか動的言語の場合、C で書かれていても一種のバーチャルマシン上で実行されることになるから、そのバーチャルマシンが最適化されたものの方が速くなっちゃうのは必然だったりするのかもしれない。New Language on the JVM (pdf) とか見てみる。Microsoft 2008 Lang.NET Symposium で発表された資料だったりするところがおもしろい。

2008.02.23

コメント(0)

-

iSCSI で Windows から Solaris のディスクを使う

iscsiで接続 solaris(target)-windows(initiator) に書かれている手順で試してみる。試しに 5GB のディスク領域を割り当てる。# svcadm enable svc:/system/iscsitgt:default# zfs create -V 5gb mypool/windows# zfs set shareiscsi=on mypool/windows# iscsitadm list targetTarget: mypool/windows iSCSI Name: iqn.1986-03.com.sun:02:9999999-999c-zz99-999c-9999999999999 Connections: 0 (iqn. のところは変えてある) 確かに、あっけないほど簡単に Solaris 側の設定が終わった。Windows 側も をインストールして、デスクトップ上にできた Microsoft iSCSI Initiator でIP アドレスを指定して問題なく接続できた。後は、コンピュータの管理のディスクの管理で通常のハードディスクと同じように見えるのでパーティションを割り当ててフォーマットして使う。そして、あっさり Windows から Solaris のディスクを iSCSI で使えるようになった。マニュアルは Solaris iSCSI ターゲットおよびイニシエータの構成。ZFS すばらしい。

2007.11.19

コメント(0)

-

OpenSolaris ベースのソフトウェアストレージアプライアンス NexentaStor

OpenSolaris と NexentaOS で以前書いた Nexenta Operating System だが、ストレージ製品の NexentaStor を出してきた出てきた。Nexenta Offers Free ZFS-Based Storage Management Software PR Newswire, Nov. 12, 2007 。Nexenta は、OpenSolaris をカーネルとして、GNU/Debian/Ubuntu のよいところを使っているから、けっこう期待している。ZFS は取り扱い楽だし。ストレージのソフトウェアアプライアンスというのは、いい線ついていると思う。来年の2月には 1.0 がリリースされるようだが、VMware で動く NexentaStor Virtual Appliance が出ているので試してみるかな。そういえば Solaris の iSCSI の機能をまだ試していなかった。試してみようかな。Solaris iSCSI ターゲットおよびイニシエータの構成。Xen ベースの仮想化技術 Solaris xVM も出てきたし、来年はこれまでより広い層に普及するんじゃないかな。

2007.11.19

コメント(0)

-

OpenSolaris の Project Indiana の成果を見てみる

使い勝手をLinuxに近づけたSolaris LiveCDでインストールできるOpenSolaris公開へ を読む。今回リリースされたのは OpenSolaris Developer Preview で、来年3月に正式版がリリースされる予定らしい。 Project Indiana milestone reached! を見ると、次のようなことが書かれている。1枚の LiveCD で、インストール前にも動作を確認できる(try before you install' capabilities)インストーラは Caiman で使い勝手が向上しているZFS がデフォルトのファイルシステム になったイメージパッケージシステム(IPS)はネットワークインストールが可能になったGNU utilities が $PATH に追加されたbash がデフォルトのシェルになったデスクトップ環境は GNOME 2.20OpenSolaris Project: Indiana の Get the OpenSolaris Developer Preview のページから ダウンロードして起動してみる。発表されたばかりだからだろうか、ダウンロードにはだいぶ時間がかかった。とりあえず、VMWare 上で動かしてみる。メモリは 512 MB、ハードディスクは 10GB が最低必要。とりあえず起動してみると、あれこれアプリケーションが使える状態で起動した。デスクトップにあるインストーラを起動してハードディスクにインストールしようと思ってもエラーでストップしてしまう。パーティションがあらかじめないとだめなのかなと root になろうとしたがなれない。Username "jack"、Password "jack" でログイン。root パスワード "opensolaris" と Release Notes for the OpenSolaris Developer Preview に書かれているが、jack ではログインできるが、root ではログインできなかった。なんでかな。これは、インストーラを起動して設定をすると、root のパスワードが動作環境にも繁栄されるために、インストーラを起動したあとは root のパスワードがその設定したものになるからだった。起動してすぐに su するときには "opensolaris" 。インストーラを動かした後は途中で失敗したとしても、そこで設定した root のパスワードに置き換わる。また、途中でインストーラがエラーで止まった場合、そこで追加したユーザ名が /etc/passwd に追加されているので 2度目にはそのユーザを削除しておかないと設定できない。結局、format コマンドでパーティションを作ってからインストールしようと思ってそうしてみたのだが、やっぱり途中でしまってしまってハードディスクへのインストールはできなかった。VMWare にインストールが成功している人もいるようなので、どこかちょっとしたことが問題になっているんだろうけど分からない。インストールできても、OpenSolaris Forums: VMWare tools installation error.... ... とか、Bug 66 ? No network interface found とか対処しないとダメなようだ。ということで、VMWare にインストールしようとしたら、それなりに分かっている人でないとちゃんと使えるようにできないかもしれない。しばらくバージョンが上がるの待って、もう少し楽に使えるにようになってからにするかな。OpenSolaris Forums: unable to install zones ... とかいろいろまだ問題はあるようで、ほんとうの Solaris の開発者用のレベルなので、一般ユーザがまだ手出しする段階にはない。まあ、リリース自体が Developer Preview なので当然といえば当然だが。でも、雰囲気として半年後はけっこう期待できそうな感じ。とはいえ、当面は新しいもの好きでも、自己解決能力がある人でない限りは Solaris 10 の Developer Edition とか使っておいた方がよいと思う。逆にいえば、あれこれ問題を解決しながらコミュニティに参加しつつ楽しみたいというのであれば、バグにしてもたくさんあるだろうから貢献できそうねという感じ。その手のことが好きな人にはけっこう楽しいフェーズじゃなかろうか。ちなみに、日本語の記事にインストーラは Slim と書かれていて、Caiman とは違うのかなと見てみると Slim Install Documentation 、LiveCD 用のコアコンポーネントのインストールは Slim インストーラとある。Caiman のサブプロジェクトという位置づけかな。FireFox や GIMP などのアプリケーションも CD から起動しただけで使える。デスクトップの左上のインストーラアイコンをダブルクリックするとインストーラが起動する。

2007.11.07

コメント(2)

-

Sharity3 で Solaris から Windows 共有にアクセス

Solaris から Windows の共有ファイルにアクセスしたいと思って Sharity-Light を使おうと思ったが、エラーが出て接続できないので商用版の Sharity3 を試してみた。ちなみに Sharity-Light は、Rumbaはどこに? Sharity-LightでWindowsボリュームをマウントする や smbfsとSharity-Light(Rumba)を使ったファイル共有 参照。Sharity3 をダウンロードしてライセンスを登録しないまま使うと、トライアルモードになる。お金を払ってライセンスを取得すれば、そのまま正式版になるようだ。ライセンス料は1sheet $199.00 で結構高い。ホームユーザーなら $29.00。とりあえず、ダウンロード、解凍して、setup を動かす。いくつかの質問に答えてオプションを設定してインストール。sharity man mount とかすると、mount の仕方が分かる。sharity -h でヘルプ。shritygui で GUI モードで使えば分かりやすい。トライアルモードだと1カ所のマウントポイントしか持てず、1ユーザしか使えないが、ちょっと、Windows の共有ディレクトリを参照するには十分。ただし、日本語のファイル名は扱えない。文字コードのマッピングファイルを自分で作ればもしかしたら動くかもしれないが、やっていないので分からない。ちなみに smbmount とかは Solaris だと使えないし、smbfs も Linux カーネル依存なので使えない。smbclient は使えるので、ちまちまアクセスする場合にはこれでも使えないことはないが、面倒なのでやっぱりマウントしたい。ということで、日本語ファイル名だめなのは仕方なしでちょっと Windows の共有フォルダをマウントしてなにかしたいという用途であれば Sharity3 を使うことにした。OpenSolaris Project: CIFS client for Solaris が組み込まれればマウントして日本語のファイル名も使えるようになるようだ。が、まだ Alpha 2。早く組み込まれてほしい。

2007.10.14

コメント(0)

-

ZFS ditto blocks って?

明日からでも使いたい次世代ファイルシステム ノートPCでこそ使いたいZFS 2007/06/29 を読んでいたら、ditto blocks という言葉が出ていた。んー、そんなのあったのかと思いつつ、考えてみたら、ZFS を使ってディスクの部分的なエラーに強い設定にする で書いた zfs set copies=2 mypool とかのことか。先日 ZFSでも壊れることはある October 4, 2007 を体験したので、ディスク容量は使うけれども、重要なところだけやっとくかな。でも、新しいハードディスク買うまでそれほど余裕もないしバックアップでしのぐ、というかこのオプション実は Solaris Express Developer Edition 9/07 にならないと使えない。メインの実機は Solaris Express 8/07 だから使えないのであった。実機も、Developer Edition に入れ替えようかなとか思いつつ、とりあえず面倒なので VMWare 上だけで新しい機能は試す。ZFS は基本部分は十分使えるにしても、進化中だから必ずしもどこかに書かれていることが自分の動かしているバージョンで動くとは限らないので注意。Solaris は何気にいろいろバージョンがあるから、これも注意ってことだな。

2007.10.10

コメント(0)

-

Solaris の新しいパッケージ管理、インディアナはどの程度期待できるのか

OpenSolaris最新事情 USBメモリ4本でRAID構成をデモ、OpenSolaris 2007/10/09 が @IT に載っていた。USB メモリで RAID構成の実験をするのは、USBメモリで ZFS ! を読んですでにやっていたのでよいとして、インディアナLinuxの世界では当たり前になった「パッケージ管理機能」だ。コアパッケージのバイナリは、再配布可能になり、より入手が容易になるという。いつから公開されるんだろうか。どの程度のパッケージに対応するんだろうか。んー、/usr/sfw のところがちゃんとパッケージ化される程度なのか、それ以上なのか。sunfreeware.com とか blastwave.org とかのパッケージなしでもかなり揃ってしまうぐらいの気合の入れようなんだろうか。記事を読んでも分からない。調べてみようと思ったが面倒なのでやめた。

2007.10.10

コメント(0)

-

Solaris Express Developer Edition 9/07

Sun,オープンソースUNIX「Solaris Express Developer Edition」の新版を公開 を VMWare 上にとりあえずインストールしてみた。画面は、(JA) Solaris Express Community Edition(nevada) b70 と同じ感じで今風になった。デスクトップもきれいになってアプリケーションも増えた。なによりもユーザ管理に SMC を使わなくて済むようになったのが進歩だったりして。ユーザーの追加とかもやりやすくなった。ユーザビリティは確かに向上している。実機でも Developer Edition 使うかなぁという誘惑に駆られる。とりあえず DTrace の GUI フロントエンド D-Light なんて試してみようかな。Solaris Express Developer EditionSolaris Express Developer Edition 9/07 Featuresドキュメント: Solaris Express Developer Edition 9/07インストール画面ユーザ管理画面

2007.10.06

コメント(0)

-

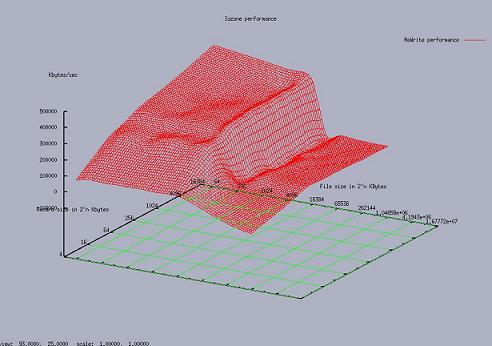

Solaris 10 で iozone を使ってディスクIOのパフォーマンスを「見る」

iozones をダウンロードして、解凍、iozone3_283/src/current にソースが展開されるので、「make Solaris10gcc」または「make Solaris10」等でコンパイルする。「make」 だけで実行するとオプションが表示されるので、そこから適切なもの選べばよい。あるいは makefile の先頭を見るか。コンパイルが終わったら実行する。(-g 4G のところは、4G を自分のマシンのメモリーの容量と同じにする)。./iozone -a -g 4G > config1.out./Generate_Graph config1.outを実行する。Generate_Graph を実行するためには、あらかじめ GnuPlot がインストールされている必要があるので、/opt/csw/bin/pkg-get -i gnuplotでインストールしておく(Blastwave のパッケージを使っている場合。Sunfreeware.com にも同じバージョンの GnuPlot があるが、Blastwave の方が依存パッケージをインストールしてくれるので楽。おっと、考えてみたら iozone もあるかもしれないなと、見てみるとちゃんとあった。$ /opt/csw/bin/pkg-get -D iozone# (Descriptions from site ibiblio.org )iozone - IO benchmarking toolゆえに上のようにわざわざソースをとってきてコンパイルしなくても一発でインストールできる。# /opt/csw/bin/pkg-get -i iozoneただし、グラフをまとめて書いてくれるスクリプトが付属していないようなので、ソースをとってきて、Generate_Graph を実行すればよいかな。Generate_Graph は、gengnuplot.pl を引数を付けて呼び出しているだけ。gengnuplot.pl が read とか rewrite とかテストに応じて必要な箇所を取り出して gnuplot 用のファイルを作って表示してくれる。が、gengnuplot.pl の #!/bin/sh は、#!/usr/bin/bash に変更しないと、Solaris だと構文エラーになる。ksh だからか。$ ./Generate_Graphs config1.out ./gengnuplot.sh: 構文エラー 行 28: `(' unexpected./gengnuplot.sh: 構文エラー 行 28: `(' unexpected...で無事動かせると、こんな感じでいくつものグラフが表示される。コマンドラインでリターンをたたくと、次のグラフに変わる。もう一つ report.pl がついていて、これは次のように複数の条件でパフォーマンスを取っておいたものを比較するのに使えるようだ。$ ./report.pl config1.out config2.out実行すると上記の場合 report_config1_config2 というディレクトリに png ファイルが作成される。config1.out だけを引数として渡せば、report_config1 というディレクトリに単独の結果が png ファイルで作成される。これいいかもしれない。チューニングをしたときに簡単にパフォーマンスチェックができてよいかもしれない。

2007.10.06

コメント(0)

-

Solaris で Webmin を使う

Solaris 10 で Webmin って簡単に使えたのね。# /usr/sfw/bin/webminsetupで、リターンをぽんぽんと打つと、port 10000 で Webmin が動くので、https://localhost:10000/ でアクセスすればよい。デフォルトでセットアップすると、SSL でアクセスするので https でアクセスするのを忘れずに。そういえば、最近、楽天ブックスって洋書を扱うようになっているのね。

2007.10.06

コメント(0)

-

ZFSでも壊れることはある

3台のハードディスクで ZFS のプールを作って使っていたが、ファイルが一つ壊れた。次のようなメッセージが出た。# zpool status -xv プール: tank 状態: ONLINE状態: 1 つまたは複数のデバイスでエラーが発生し、 データが壊れました。アプリケーションがこの影響を受ける可能性があります。アクション: 復元できる場合は、問題の発生したファイルを復元します。復元できない場合は、バックアップから プール全体を復元します。次のサイトを参照してください: http://www.sun.com/msg/ZFS-8000-8A スクラブ: 何も要求されませんでした構成: NAME STATE READ WRITE CKSUM tank ONLINE 0 0 2 c0d1p0 ONLINE 0 0 2 c1d0p0 ONLINE 0 0 0 c1d1p0 ONLINE 0 0 0errors: Permanent errors have been detected in the following files: /export/path/to/the/file/corruptedArticle for Message ID: ZFS-8000-8A を見ると、このエラーは復旧できないようだ。ということで、バックアップから復旧する。ストライプの状態で(単に3つのHDDをプールにして使っていた)ので RAID構成にしていなかった。やはり ZFS といえども安全のためには raidz、raidz2 か mirror にしておいた方がよいかな。ただし、RAID構成にするためには同じ大きさのHDDでなくてはならない。異なる大きさのHDDを追加していくのであれば、RAID構成をとっているときに比べてリスクが大きいわけだから、バックアップ頻度をきちんと考えないとダメ。まあ、当然といえば当然だが。

2007.10.04

コメント(0)

-

ZFS の ZIL を USB フラッシュメモリにするの失敗

ZFS のパフォーマンス を書いたときに知った IOzone Filesystem Benchmark を使って、ZFS の ZIL ((ZFS Intent log)) をメインプールと別に用意すると書き込みが速くなるらしい を試してみようかと思った。ログデバイスの設定がなぜかできない・・・・・・。 結果、ログデバイスを分離したときの効果は確認できず。 Example 4?2 Adding a Mirrored Log Device のように zpool add newpool log mirror c1t11d0 c1t12d0 を実行しようとしても、エラーになってしまう。bash-3.00# zpool create newpool raidz c3t0d0p0 c4t0d0p0 c5t0d0p0bash-3.00# zpool add newpool log mirror c6t0d0p0 c7t0d0p0cannot open 'log': no such device in /dev/dskmust be a full path or shorthand device nameどうも log を ZIL のキーワードとして認識していないような感じ。ZFS のバージョンのせいなんだろうか。まだソースから作っていないとだめなのかな。Creating a Storage Pool with Log Devices とかにも書かれていることは書かれているのだが。。。。Solaris Express 8/07 使っているのだが、 Solaris Express Developer Edition 9/07 が出ているから、それにしたらどうなるか。今はそこまで気力がないのでやらない。そもそも、こういう実験するのは Community Edition を使った方がいいのかな。ここ とか見ると、最近リリースされた Solaris Express Developer Edition 9/07 で入った新しいインストーラーも b70 で入っていたようだし。「日本語ロケールは UTF-8 がデフォルトになります。」とかいうところも早いし。とはいえ、ある程度安定したバージョンを使いたいから、Nevada を仮想環境にインストールして試せるようにするというのもよいか。仮想環境ならディスクもたくさん足せるわけだし。でもパフォーマンスを見るにはよろしくない。うーん。Solaris xVM putback into OpenSolaris Completed とか、Nevada を使っていれば新しいものが試せるのはメリットだろうけど。CentOS を動かしているマシンをつぶして Nevada 用にするかな。しかし、そこまで Solaris ばかりで遊んでどうするのという話もあるし、しばらく待っていればよいのでやめておく。とりあえず 余っている HDD がないので pool を作って壊してとかの実験がなかなかできなかったので、USBメモリを調達したので ZFS の実験がいろいろできるようにはなった。とりあえずやったこと。USB フラッシュメモリの 2GB (1個2000円程度) のものを 5本使った。USB メモリで ZFS を使うための設定については、やっぱり Sun がスキ! USBメモリで ZFS ! を参考にした。# svcadm disable volfs # volfs を止める リムーバブルメディアの管理 (概要) # format -e デバイス名の確認# fdisk /dev/rdsk/c3t0d0p0 c3t0d0 のパーティションを切り直す# fdisk /dev/rdsk/c4t0d0p0 c4t0d0 のパーティションを切り直す::注意点としては、スライス0 に全容量をアサインし、partition の label は SMI Label にすることとあったので、それに従った。SMI は従来の VTOC ラベルで、1テラバイトに満たないディスク用で、EFI は 64 ビットSolaris カーネルを実行しているシステムで1T バイトを超えるディスクをサポートするものってことかな。Solaris 10 リリースでの新しいディスク管理機能 、Solaris のシステム管理(デバイスとファイルシステム) (pdf) ftp://docs-pdf.sun.com/819-0386/819-0386.pdf 参照。zpool create usb-raidz raidz c3t0d0p0 c4t0d0p0 c5t0d0p0 c61t0d0p0 c71t0d0p0# zpool status pool: usb-raidz state: ONLINE scrub: none requestedconfig: NAME STATE READ WRITE CKSUM usb-raidz ONLINE 0 0 0 raidz1 ONLINE 0 0 0 c3t0d0p0 ONLINE 0 0 0 c4t0d0p0 ONLINE 0 0 0 c5t0d0p0 ONLINE 0 0 0 c6t0d0p0 ONLINE 0 0 0 c7t0d0p0 ONLINE 0 0 0errors: No known data errorsとりあえず mkfile を使って簡単に試してみる。# ptime mkfile 1g test.datreal 3:44.069user 0.280sys 10.126ハードディスク上で試すと、下の程度なのでお話にならないぐらい遅い。real 19.660user 0.528sys 17.304raidz が遅いのかと思って、RAID 構成にせずに試してみる。zpool destroy usb-raidz # いったん削除して作り直しcreate usb-pool c3t0d0p0 c4t0d0p0 c5t0d0p0 c61t0d0p0 c71t0d0p0それでも次の程度。bash-3.00# ptime mkfile 1g test.datreal 2:15.469user 0.270sys 9.563大分、速くなったものの、やっぱりとてつもなく遅い。ファイルが大きいとダメなのかと小さいサイズにしてみると、数MB~数十MB 程度だと USB メモリを使った方が速そうで、KB 程度だとほぼ変わらない感じ。小さ目の一次ファイルを読み書きするディスクとしてはかなり使えるが、大きいファイルはダメということになるか。まあ、これは USB メモリの特性も関係あるのかもしれない。もっと高速なフラッシュメモリを使えばいいかもしれない。どこからパフォーマンスが劣化し始めるかざっくり見てみると、26MB まで OK で、それ以上になるとダメになった。とりあえず、大きくない一時ファイル用のディスクとして使うというのは、十分実用的に HDD の代わりになりそう。 100MB桁違いに遅い HDD USBreal 1.712 13.632user 0.044 0.025sys 1.485 0.92327MB遅い遅い HDD USBreal 0.427 6.699user 0.012 0.009sys 0.407 0.24626MBこのあたりから速いreal 0.417 0.252user 0.012 0.008sys 0.392 0.24125MBreal 0.425 0.245user 0.012 0.008sys 0.404 0.2335MB HDD USBreal 0.082 0.057user 0.003 0.002sys 0.072 0.0531MBなぜかとても速い HDD USBreal 0.079 0.020user 0.001 0.001sys 0.076 0.018100KB同じぐらいになる HDD USBreal 0.009 0.008user 0.001 0.001sys 0.007 0.00610KB同じ HDD USBreal 0.008 0.008user 0.001 0.001sys 0.006 0.0061KB同じぐらい HDD USBreal 0.007 0.008user 0.001 0.001sys 0.005 0.006IOZone を使ってのテストはまた別の機会にする。霜降り肉がある: グルメ王 神戸牛のおんどる食彩館 くいしん坊万才!のお取り寄せ ミナト

2007.10.03

コメント(0)

-

ZFS を使ってディスクの部分的なエラーに強い設定にする

ZFS では、ディスクにファイルを書き込むときに内部的に 2つの領域にデータを書き込むことができる(最大で3)ようになったということを知る。ディスク全体が吹っ飛んでしまうのには対応できないが、部分的な不良には、このオプションを使えば対応できる。いいかもしれない。# zfs set copies=2 mypool # mypool に書き込まれるデータコピーを 2つに設定# zfs get copies # 確認のためとすれば、mypool にファイルが書き込まれるときに 2つ分書き込まれる。万が一、片方が書き込まれているディスク領域がエラー問題になっても、もう一つが生きているので大丈夫と。この設定は、プールの作成時にしていしてもいい。# zfs create -o copies=2 mypoolもちろん、データを書き込めば 2倍の領域が使われるのでディスク領域は食う。また、複数のディスクを使っていても、必ずしも別のディスクに書き込まれるということはないようなので、RAID のように 1つのディスクが飛んでも大丈夫とかいうものではない。それでも、部分的なディスク不良には対応できるのでいいかもしれない。詳しい話は、ZFS, copies, and data protection を参照。

2007.09.24

コメント(0)

-

ZFS の ZIL をメインプールと別に用意すると書き込みが速くなるらしい

Solaris 10 のファイルシステム ZFS は、書き込み時にトランザクションログ ZIL (ZFS Intent log) を使っている。通常は Main Pool から動的に必要なブロックを取り出してログを書きこんで、使い終わったら解放してということが起きているが、このログのための領域を別途確保してやることによって、書き込み速度が向上するらしい。これについて、slog blog (or blogging on slogging) に書かれている。加えて、そのログ領域に NVRAM や SSD (Solid State Drive) などを使えばさらに速くなるという実験結果が書かれている。そのうち試してみたい。ちなみに、別のところを読んでいたら、どの程度の領域サイズが必要かというと、最大でメモリの 1/2 のようだ。まだ、自分は試していないが、そのうちUSBメモリでも使ってやってみる。

2007.09.24

コメント(0)

-

Solaris ゾーンの移動

Solaris Zone をあるディレクトリに作ったが、移動したくなった。単にディレクトリを移動するだけだと動かなくなってしまった。まあ、当然といえば当然か。シンボリックリンクを元のディレクトリに張って見かけ上同じにしようとしたがだめ。調べてみるとちゃんとコマンドがあった。移動する前には halt で止めておかないといけないのは当然。# zoneadm -z zone-name halt# zoneadm -z zone-name move /move/to/dir/zone-name# zoneadm list -iv# zoneadm -z zone-name boot分かってしまえば簡単便利。マニュアル一通りちゃんと読んで、ある程度頭に入れておかないといけないなとは思いつつ、必要な 第 23 章 非大域ゾーンの移動と移行 (手順) だけ読んだ。

2007.09.21

コメント(0)

-

Solaris 10 のフリーソフトのパッケージ管理

Solaris 10 8/07 を SPARC のマシンにとりあえずインストールし直した。Solaris 10 8/07 リリースの新機能。Solaris でオープンソースのパッケージを楽にインストールするには、Sunfreeware.com、 Blastwave.com がある。どちらも pkg-get でインストールできるので楽。Sunfreewareの方は依存性については考慮していないので、必要なものを自分で選択しなければならない。Blastwave の方は依存性をチェックして必要に応じてダウンロード、インストールしてくれる。というわけで、メンテナンスの点からは Blastwave が楽。How To Get Started With Blastwave.org for Solaris 10 Users に手順がある。Blastwave のものは、/opt/csw に完全に独立した形でインストールされる。Sunfreeware のものは /usr/local にインストールされる。Sunfreeware の方には CoolThreads (TM) Optimized Open Source Software Stack (Cool Stack) というのがあって、Apache, PHP, MySQL を Solaris 用に最適化した状態でひとまとめにしている。この部分に関しては、Cool Stack というのもありなのかな。試してはいない。さらに Companion CD についてくるパッケージがある。Solaris 10 をどんとインストールすると、/usr/sfw にインストールされる。結局、パッケージが 3つに分散されて、だんだんわけが分からなくなってくる。ちなみに、全部インストールされる Python のバージョンは 次のようになっている。無造作にインストールしていくと、ぐちゃぐちゃの状態になっていくので災いの元。/usr/bin/python 2.4.4/usr/sfw/bin/python 2.3.3/usr/local/bin/python 2.5.1/opt/csw/bin/python 2.3.5CSW (Blastwave) は楽だし、対応している数も多いが、バージョンが 2.3系で古いのが気に入らない。全般的にバージョンアップは保守的なのかな。SFW も古い。Sunfreeware が新しいものに対応しているのでうれしい。が、依存性については自分で注意しなければならないし、対応しているパッケージも少ない。あれこれあるとディスク容量もオーバーヘッドがあって無駄になる。CSW の Python はバージョンが確認できたので、もう使わないし削除。邪魔くさいので /usr/sfw の python も削除してしまうことにした。GNOME2 のカテゴリになっているが大丈夫かな。。。。これで /usr/bin/python (2.4.4) /usr/local/bin/python (2.5.1) と少しすっきりした。ん、以前は /usr/bin/python なんてなかったのにな。あまりに無造作にインストールしてしまったので、ほかにもこうした状況ができているかもしれないので、調べてみないといけない。楽するつもりがいまいち楽にならない。Nexenta Operating System とか、サン、「Indiana」プロジェクトの「OpenSolaris」支援に期待 とか、そのあたりがある程度のところまできたら、もう少し、そういう問題を気にしなくてよくなって広まるかな。

2007.09.20

コメント(0)

-

Solaris コンテナを使い始める

Solaris 10 オペレーティングシステムの Solaris コンテナ でしばらく遊んでみることにする。Solaris コンテナは物理的にひとつのサーバ上に、複数のアプリケーション実行環境を実現することができる。Xen や VMware なども同じようなサーバの仮想化の技術として注目されているが、Solaris コンテナの方が効率の点からいったらば好ましいと思う。ただし、好きな OS を何でもインストールして動かしたいというニーズは満たせない。ハードウェア資源を仮想化して有効活用するという目的はどれでも果たせるが、柔軟性の点においては、Xen や VMWare。効率の点から言えば Solaris コンテナということ。FreeBSD Jails に近いだろうか。Sun も仮想化技術に関しては Solaris コンテナがそれはそれで優れていることは自信を持っているようだが、顧客のニーズをすべて満たすことはできないので、『仮想化』の未来を考える で Xen への対応は不可避であることが述べられている。そして、サン、Xenベースの仮想化技術を「xVM」と命名 とかで Xen を取り込んだりしているようだし、サン、「Solaris 10」をアップデート--ヴイエムウェアとの提携も発表 とかもしているようなので、選択肢もそのうち増えるだろう。Solaris のコンテナ上で Linux を動かすことができる Brandz もやっとではあるが Experimental Linux 2.6 Support で Kernel 2.6 に対応するようになってきたようだ。まあ、とりあえず、そんなことはどうでもいいとして、コンテナ関係のドキュメントを少し眺めてみる。Solarisコンテナの真相に迫る を読む。最初、コンテナと Zone の区別がよく分からなかったのだが、実際にはごっちゃになって言及されることが多いので、混乱するのも当然という感じか。Solaris 10コンテナの正式な定義は、リソース管理機能を利用するSolarisゾーンです。しかし普段の会話では、ゾーンとコンテナを区別する人はほとんどいません。コンテナ = Zone + リソース管理機能といったんとらえておけば問題ないか。この文書では Global Zone を「大域ゾーン」と訳して、Local Zone を「ローカルゾーン」と訳して、それでいて Non-Global「非グローバル」ゾーンなんて出てくるので日本語を読んでいると気持ち悪い。まあ、このあたりは訳語の問題だけだが。Solaris 10 Feature Spotlight Solaris ゾーン ではグローバルゾーンと非グローバルゾーンと書かれているし、訳語の統一がなってないな。。。。やっぱり、こういう用語はきちんと訳語を決めて統一した方が混乱がないと思うのだが。Solaris コンテナ - ゾーン(要ログイン) あたりにちゃんとまとめられているが、なんでログインしなきゃ見られないのか不便。Solarisコンテナ:内容と使用法 の この図 のイメージが分ければなんてことはないが。Solaris Container サーバおよびアプリケーションの統合 あたり、マルチプロセッサを使っているときに CPU のリソースの割当が行えたりとかいうメリットが分かりやすい。メリットとしては Solaris コンテナ(Zone)に対するリソースの割り当て のFSS スケジューリングクラスとリソースプール。シェアを割り当てておくことができるので、Zone の中に暴走アプリがあっても、そのシェアの中だけで動くので全体に与える影響が限定されるというのもいいところだろう。グローバルゾーンのディレクトリを継承できるから(デフォルトでは /sbin, /lib, /usr が継承される)ので、ディスク容量も 他の仮想 OS をインストールしたときより、ずっと少なくてすむのもメリット。探してみるといろいろ資料があるのだが、とりあえず Solaris コンテナ(Zone)構築ガイド から始める。4ページ目のリンクから 次のページ をクリックすると、エラーが出る。というか、5ページ目は目次にもなくて、本来このリンクが余計なようだが、サンの方はメンテナンスちゃんとした方がいいと思う。Sun ONE Application Server - HTTP Status 404 ErrorThe requested resource (/solaris10/zones/private/guide5.html) is not available.Type: Status ReportMessage: /solaris10/zones/private/guide5.htmlまあ、とりあえず、前にもやったことがあるが、改めて Zone の作り方とログインを復習してみた。でもって、これからは、あれこれテストするときは zone の中でやることにして常時使ってみる。ちなみに理屈はさておきというなら Solaris コンテナ(Zone)構築ガイド だけ読めば、一応動かせる。

2007.09.19

コメント(0)

-

ZFS のスナップショットを Amazon S3 に保存する方法 (Python で途中まで)

Solaris の ZFS には スナップショット といってファイルシステムの変更部分だけを保存する方法がある。これを使えば差分バックアップを効率的にとることができる。しかし、バックアップは物理的に別なメディア(ハードディスクやテープ、DVD 等) に保存しておかなければ、いざハードディスクがクラッシュしたときには手の打ちようがない。さてどこに保存するか。バックアップの保存先として、Amazon Simple Storage Service (Amazon S3) を使えば、ハードディスクを新たに購入する必要もないし、テープドライブなどのハードウェアも購入する必要がないし、メンテナンスも必要ない。お手軽で比較的低コストなバックアップメディアとしての Amazon S3 という存在。米Amazon、容量無制限・高速スケーラブルなストレージのWebサービスZFS のスナップショットを取って、これを Amazon S3 に保存するための手順が、Storage Utilities in Practice: ZFS Snapshot to Amazon S3 にまとめられている。スナップショットを取るところまでは通常の zfs コマンドを使っての操作。その後実際に Amazon S3 にファイルを送信するのは、Amazon S3 Library for REST in Java を使っている。実際にコストはどの程度かかるのか。この事例だと 1TB のバックアップを毎月保存(1TB, 2TB, 3TB と毎月、保存量が増えて1年後に12TB を使用)したとき、この1年間コストは、$11,700、送信時の帯域使用量が年間 $1,380。これには、毎月 1TB ずつの送信と、バックアップからの復旧等のために 500GB のデータを取り出すのを年に2回分の料金が含まれる。そうすると、年間で $13,080 という事例が載っている。ということは、例の 1/10 の使用量 100GB のデータをバックアップするケースであれば、年間 1308ドル。1ドル115円として計算すると 150,420 円ということになる。年間、ほぼ 15万円程度で合計 1.2 TB のバックアップメディアを確保できることになる。もちょっと小さくして、毎月 10GB の転送なら約 1万5千円、1GB なら 1500円。月に直せば、100GB 単位で 12,535 円、10GB単位で 1,254円、1GB単位で 126円程度か。10GB 単位で毎月バックアップをとる約 1,254円 というのは、そこそこよいかもしれない。途中で古い世代のものを消しながら使えば、もっと安くなるだろうし。ちなみに、料金はストレージの月の使用料が 1GB 単位で 0.15 ドル だから 100GB で 15ドル。これに転送料が最初の 1TB は 1GB 単位で 0.18 ドルだから 100GB で 18ドル。使っただけ課金される。毎月 10GB のデータを転送し、古い世代のものは 3世代だけ残して削除するとしたら、10GB, 20GB, 30GB, 30GB,.... とストレージ料金がかかるので、1.5ドル、3ドル、4.5ドル..... で延々使い続けると 1ヶ月あたり 4.5ドルとして、月に 516円程度。転送料金は 10GB ずつなので 1.8ドルで 207円。転送で PUT や一覧をチェックするために LIST 等のリクエストを送ると 1000リクエストあたり 0.01ドルだが、これは無視しておき、516 + 207 = 723円。月に 1000円以下で 10GB の 3世代を保存しておけるバックアップ先ができる。バックアップだけのためにハードディスクを買うとして、バックアップメディア自体の障害を考えて RAIDZ で構成したとしても、750GB x 3 が 25000円 x 3 = 75000円程度としたら高いといえば高いか。でも、Amazon S3 なら、いっときにすべてを払う必要がないことや、電気代や設定やメンテナンス等の手間賃、ハードディスクの騒音、あるいは、火災や地震が起きてもデータは大丈夫とか考えると、リーズナブルかもしれない。データが増えたら増えたで、容量制限はないからハードディスクの拡張とかも気にする必要がない。毎月約 1000円程度かけて、重要なものだけ 10GB のバックアップを取って Amazon S3 に保存するというのもリーズナブルかもしれない。今のところ実はバックアップ先は困っていないが、地震、火事等の消失に備えて月 1000円というのはありかなとか思いながら、微妙だなぁ。最重要データだけ 1GB に絞り込んで、上記の計算の 1/10 とすれば 100円以下になるから、重要データの災害対策のバックアップ先として考えるとよいか。とりあえず、ものは試しなのでアカウントを作ってみる。Amazon S3使ってみた には S3Fox Organizer for Amazon というのが紹介されていて、FireFox からファイルを操作できるようだ。Amazon Simple Storage Service(A3)をバックアップストレージとして利用する をみたら、いろいろなアプリケーションもあるようなのでそういうものを使ってもいいのかもしれない。が、とりあえず、API を使ったプログラミングをするなら、Amazon S3 Library for REST in Java 以外に Perl なら Amazon S3 Authentication Tool for Curl があり、Python もいくつかある。Amazon S3 Library for REST in Python もあるが、直感的に boto - AWS for Python が楽に使えそうだと思ったので試してみる。download したら、"python setup.py install" でインストールできる。シェルに bash 等を使っているのであれば、export AWS_ACCESS_KEY_ID=アクセスキーを入れるexport AWS_SECRET_ACCESS_KEY=秘密鍵を入れるとすると、ファイルの編集をしなくても環境変数からアクセスキー等を取り出してくれるしくみになっている。とりあえず、そうしておいて、「python test.py -t s3」でテストしてみる。$ python test.py -t s3--- running S3Connection tests ------ tests completed ---.----------------------------------------------------------------------Ran 1 test in 8.458sOKOK が出ているのでうまく動いているようだ。サンプル等を参考に適当なものを書いてみると、なんとか使えそうな感じ。ファイルのアップロードとダウンロード、メタデータの設定などできた。メタデータは UTF-8 を使ったら日本語も大丈夫だった。とりあえず、ここまで。#!/usr/bin/env python# -*- coding: utf-8 -*-import timefrom boto.s3.connection import S3Connectionfrom boto.s3.key import Key# Amazon S3 に接続するconn = S3Connection('自分のキーを入れる', '秘密鍵を入れる')# バケットを3つ作る。名前はユニークなものでないとならない。# 誰かが作った名前と同じではダメbucket_name = 'kugutsushi-%d' % int(time.time())bucket = conn.create_bucket(bucket_name)bucket_name = 'kugutsushi-%d' % int(time.time())bucket = conn.create_bucket(bucket_name)bucket_name = 'kugutsushi-%d' % int(time.time())bucket = conn.create_bucket(bucket_name)# bucket をすべて表示するrs = conn.get_all_buckets()print "---- buckets: %d ----" % (len(rs))if rs > 0: for b in rs: print b.name# 最後に作成されたバケットを取り出すbucket = conn.get_bucket(bucket_name)# アクセスコントロールを private にする。# bucket.set_acl('private')# 作成したバケットの中に myfile というキーを作るk = Key(bucket)k.key = 'myfile'# ファイル(test.tar.gz) をアップロード# 別の名前でダウンロード (test2.tar.gz) してあとで確認k.set_contents_from_filename('test.tar.gz')print "---- test.tar.gz uploaded ----"k.get_contents_to_filename('test2.tar.gz')print "---- test2.tar.gz downloaded ----"# メタデータを設定するk.set_metadata('meta1', 'This is the first metadata value')k.set_metadata('meta2', u'日本語は大丈夫かな')# メタデータの確認print "----- meta data ------\n"print k.get_metadata('meta1')print k.get_metadata('meta2')if bucket.lookup('myfile') != None: print "myfile は存在します"# すべての bucket の名前と ACL を表示するprint "---- bucket & acl ---"rs = conn.get_all_buckets()print len(rs)for b in rs: print b.name acp = b.get_acl() for grant in acp.acl.grants: print grant.permission# キーをすべて削除するall = bucket.get_all_keys()print "----- keys ----"for k in all: print k.key bucket.delete_key(k)# バケットを削除するconn.delete_bucket(bucket)

2007.09.09

コメント(1)

-

受刑者にプログラミング言語を覚えさせるとしたら

受刑者にプログラミング言語を覚えさせるとしたらどの言語が最適だと思いますか? 理由も含めてお答えいただけたらと存じます を読んでいておもしろいと思った。なんにしても、受刑者にはなりなくないが、もし、自分が受刑者になったら何を習いたいか考えてみる。DTrace の D 言語かな。どうせすぐに出られないのだったら、じっくり新しいことをやりたいから。システムコールのレベルで OS を理解する必要もあるし。たとえば DTrace を完全に使いこなせるようになってチューニング専門家になる。パフォーマンスチューニングっていうのは、地道なところがあるから刑務所でやるのにぴったりじゃないかとか思ったりする。発注者側からしてみても、ロジックを組ませるのがなんとなく怖かったりしても、チューニングを行いその結果をもらうという形であれば抵抗感は薄れるのじゃなかろうか。誰がどう書いたものであっても作ったものは第三者によるレビューを通すべきだろうが。チューニングであれば、気を入れて見る箇所が限定されるので抵抗感は薄れるだろうし。Solaris 10 DTrace 使ってみよう - 使ってみよう のページの最後の方、Probe の数を調べるのに次のように書かれているが、これは翻訳ミスで、赤字の部分が抜けているんじゃなかろうか。# dtrace -l | wc -l 45363

2007.09.09

コメント(0)

-

富士通が改めて Unix 戦略