จำได้ไหม? พวกเราจำได้ใช่ไหม? ปีที่แล้ว Google เผยแพร่งาน วิจัยการใช้โครงข่ายประสาทเทียมที่เรียนรู้จนสามารถแยกแยะวัตถุที่เห็นในภาพต่างๆ ได้ ล่าสุด Microsoft ก็โชว์ผลงานลักษณะเดียวกันนี้ให้เห็นบ้าง โดย Microsoft อ้างว่านี่เป็นครั้งแรกที่ระบบซอฟต์แวร์สามารถเอาชนะมนุษย์ได้สำเร็จในการแยกแยะวัตถุในภาพ

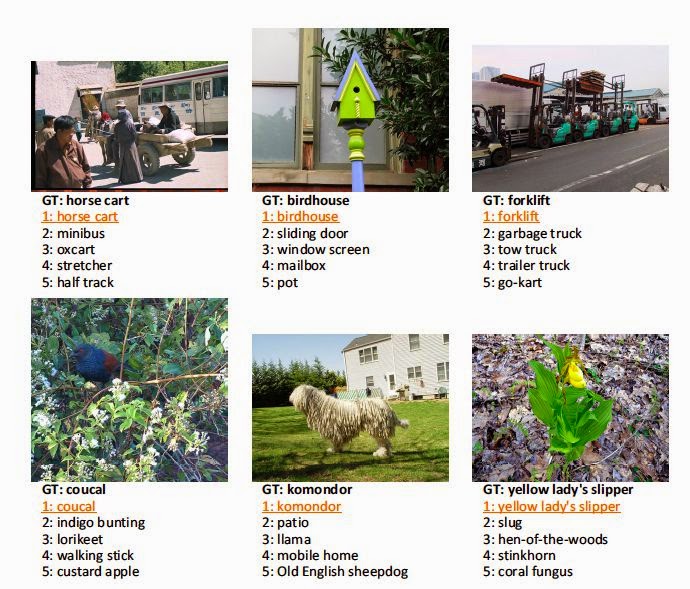

Microsoft อ้างอิงจากการแยกแยะวัตถุในภาพจากคลังภาพของ ImageNet (เจ้าเดียวกับที่จัดการแข่งขันซอฟต์แวร์แยกแยะวัตถุในภาพชื่อ ILSVRC ที่ Google ได้แชมป์บางประเภทในปีก่อน) โดยระบุว่าผลงานของ Microsoft ระบุข้อมูลวัตถุในภาพผิดไปเพียง 4.94% ต่ำกว่าค่าประมาณอัตราการผิดพลาดจากการแยกแยะด้วยสายตามนุษย์ซึ่งอยู่ที่ 5.1%

Microsoft ระบุว่าในบางครั้งระบบคอมพิวเตอร์ของพวกเขาก็ยังไม่ฉลาดเท่ากับการพิจารณาโดยมนุษย์ โดยเฉพาะอย่างยิ่งในกรณีที่ต้องอาศัยการพิจารณาข้อมูลในบริบทหรือต้องใช้การอนุมานเข้ามาช่วย หรืออย่างในกรณีที่ต้องอาศัยความรู้ความเชี่ยวชาญเฉพาะด้านในระดับสูงมาช่วยระบุวัตถุในภาพนั้นมนุษย์ก็ทำได้ดีกว่าคอมพิวเตอร์เช่นกัน

อย่างไรก็ตามคอมพิวเตอร์สามารถทำหน้าที่ได้ดีกว่าสายตามนุษย์ในสถานการณ์ที่ต้องแยกแยะสิ่งต่างๆ โดยอาศัยรายละเอียดเล็กๆ ยกตัวอย่างอธิบายว่า การแยกแยะระหว่าง "แกะ" และ "วัว" นั้นถือว่าไม่ใช่เรื่องยากสำหรับมนุษย์และคอมพิวเตอร์ แต่การแยกแยะว่า "แกะ" หรือ "วัว" ในภาพนั้นเป็นสายพันธุ์ใดกลับกลายเป็นโจทย์ยากสำหรับมนุษย์ในขณะที่คอมพิวเตอร์ยังคงใช้ข้อมูลรายละเอียดปลีกย่อยเรื่องสี, รูปร่าง, พื้นผิว มาจำแนกสายพันธุ์ได้ถูกต้องแม่นย่ำกว่า

น่าสนใจว่าหากจะวัดกันแล้ว งานวิจัยเรื่องการแยกแยะวัตถุในภาพของ Microsoft และ Google นี้ ใครจะเจ๋งกว่ากัน

ที่มา - GigaOm

Comments

deep learning มาแรงจริงๆ paper สาย computer vision พากันเทมาทางนี้หมดเลย

เห็นข่าวนี้แล้วผมขออาศัยแปะลงที่นี่ด้วยเลยแล้วกันนะครับ ไม่เห็นข่าวที่อื่นด้วย

OneDrive มีระบบ auto-tag แล้วครับ ดูจากเนื้อหาในภาพเราโดยตรงและแท็กสิ่งที่เกี่ยวข้อง ทั้งสถานที่ (จาก location tag) และวัตถุในภาพ ส่วนมากก็ตรงด้วย ไม่แน่ใจว่าใช่ระบบในข่าวนี้หรือไม่

ภาพจาก OneDrive ผมครับ อึ้งสุดก็ตรง #ห้างสรรพสินค้า นี่แหละครับ อุตส่าห์รู้ด้วยนะ

โอ้โห เดี๋ยวผมต้องไปเปิดดูบ้างละ ฮ่าๆ

_#เสา :)

โชคดีมีแค่สามเสา 555 :P

โอ้ว เมพ ฝั่งพี่กูมีบ้างรึยังหนอ

เทคโนโลยีไม่ผิด คนใช้มันในทางที่ผิดนั่นแหละที่ผิด!?!

อันนี้เจ๋งจริง อาทิตย์ก่อนผมอัพโหลดภาพคอนเสิร์ตขึ้น OneDrive ระบบใส่แท็ก #การแสดง ให้ด้วย แต่พลาดขำ ๆ อันนึง ภาพแมวนอนขด กลายเป็น #อาหาร (หรือจริง ๆ แมวเป็นสัตว์กินได้ ?!)

ต้องลองครับ อย่าลืมรีวิวลงพันทิปนะครับ

แมวพิม เอ้ย แมวแทก รึป่าวครับ.. ชั้นหิวแล้ววว เอาอาหารมาาาา #เมี้ยว

ลองเลี้ยวตามไปดู .. ถ้าเปิดแบบภาพใหญ่แล้วกดดู info มันมีส่วน extracted text ให้ด้วย แล้วหากในนั้นมี link ก้อแยกเฉพาะ url มาให้อีกตะหาก (เค้าไปกินขิงมารึไง เมพไปแล้น)

แต่ของผมเปนภาษาอังกฤษมารัวๆ เลย พวกแทกก้อด้วย.. ไว้เดวไปลองเปลี่ยนภาษาในแอคเคาทอื่นดูอีกที

ปล. ขอบคุณที่ช่วยชี้เป้าคร้าบผม

extracted text นี่มานานมากแล้วครับ เกินปีมาได้พักใหญ่แล้ว ตั้งแต่สมัยชื่อ SkyDrive กันเลย

SkyDrive เพิ่มฟีเจอร์แปลงภาพเป็นข้อความ (OCR) โดยใช้เทคโนโลยีจาก Bing

และ มันยังภาษาไทยไม่ได้ครับ orz

ก็ว่าทำไมลงรูปแล้วมันติด Tag เอง(ในบางรูป) ที่แท้เพราะระบบนี้สินะ...... น่าใช้ในความน่ากลัวนะ

Mekokung's Story บล็อกส่วนตัวที่ย้ายไป Blogger แล้วนะ

มันรู้จัก เสาด้วย

เจอ blog ของ ms แจ้งฟีเจอรนี้ไว้เมื่อปลายเดือน มค .. blog.onedrive.com/introducing-an-all-new-way-to-view-manage-and-share-your-photos-in-onedrive/

รวมถึงฟีเจอร extracted text ที่ผมเอ่ยถึงไว้ใน reply ด้านล่างด้วย [blognone.com/node/65718#comment-791662] .. ผมค้นด้วยคำว่า extracted text นี่แหละ มีเอ่ยถึงกันไม่กี่ที่เอง

กำลังสงสัยว่าระบบเบื้องหลังจะเปนอันเดียวกับฟีเจอรนี้ใน sway [blognone.com/node/63594] .. และคาดว่าจะค่อยๆ เปิดให้ใช้ผ่าน app/service ต่างๆ ของ ms (โปรโมทจิงจังอาจจะเปนตอนเปิดตัว office รุ่นถัดไปมั้ง?)

ของใหม่น่าลอง เทส

น่าลองเทสกับปกนางแบบ AV คนไหนเหมือนปกหนัง คนไหนไม่เหมือน...

ถ้าทำดีๆ ที่พันทิปคงไม่มีกระทู้มาตั้งถามแล้วสินะว่าแมลงตัวนี้คือแมลงอะไร