เว็บ 9to5Mac อ้างเอกสารภายในของแอปเปิล ซึ่งส่งให้กับทีมงานของโครงการระบบสแกนภาพถ่าย เพื่อค้นหาภาพอนาจารเด็ก (child sexual abuse material - CSAM) หลังจาก แอปเปิลประกาศโครงการนี้ อย่างเป็นทางการต่อสาธารณะ และเกิดข้อกังวลเรื่องกระบวนการค้นหาภาพ ที่อาจไม่สร้างความเป็นส่วนตัวกับผู้ใช้งาน

เนื้อหาในเอกสารนี้เริ่มด้วยการขอบคุณทีมงานทุกฝ่าย ที่ร่วมกันทำให้โครงการนี้สำเร็จ โดยสามารถปกป้องเด็กได้ และยังสามารถปกป้องความเป็นส่วนตัวผู้ใช้งานที่แอปเปิลให้ความสำคัญ นอกจากนี้ยังกล่าวว่าหลังประกาศโครงการออกไป กระแสตอบรับทางบวกก็มีอยู่มาก แต่บางคนยังเข้าใจไม่ถูกต้อง และบางส่วนแสดงความกังวลในการใช้งานจริง ซึ่งแอปเปิลจะเผยแพร่รายละเอียดให้มากขึ้น เพื่อสร้างความเข้าใจว่าเรากำลังทำอะไรอยู่

ประเด็นที่ถูกตั้งคำถามเรื่องความเป็นส่วนตัวในการใช้งานนั้น นอกจาก ผู้อ่าน Blognone แล้ว ก็ยังมีการตั้งคำถามจากทั้ง Edward Snowden และ องค์กร EFF ด้วย

ที่มา: 9to5Mac

Comments

อยากรู้ว่า สมมุติโครงการนี้ผ่าน แล้วใช้งานจริง หลักฐานคือสิ่งที่แอปเปิ้ลส่งไปให้นี่ ฟ้อง/จับกุม ได้เลยรึเปล่า แล้วทำไมถึงทำแค่เคสนี้ เคสอื่น ๆ ที่ผิดกฏหมายถึงไม่ยอมทำให้ เช่น ปลดล๊อกมือถือผู้ก่อการร้าย?

อาจจะส่งฟ้องได้ แต่ก็จะมาตายตอนที่นำเสนอหลักฐานต่อศาล เพราะคุณไม่สามารถบอกศาลได้ว่า ค่า hash ตรงกัน 95% เลยถือเป็นรูปอนาจารเด็ก คุณต้องหารูปที่ว่ามาให้ได้จริงๆ

เว้นแต่จะส่งข้อมูลบุคคลให้หน่วยปราบปรามไปเก็บหลักฐานอื่นต่อด้วยตัวเอง

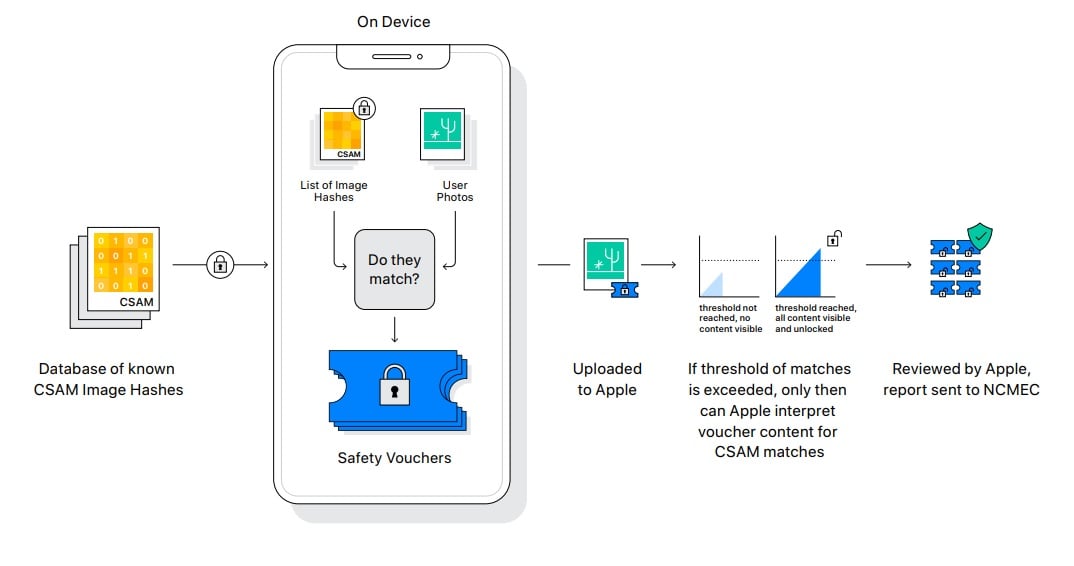

ถ้าเรามีรูปที่มีค่า Hash ตรงกันมากเกินที่กำหนด พนักงานของ Apple จะ "เข้ามาดู" รูปของเราใน icloud เราเลยครับ เพราะงั้นการส่งหลักฐานต่อให้พนักงานฟ้องต่อจึงไม่ใช่เรื่องยาก

คือตอนนี้ที่เข้าใจคือคนใช้ icloud photo ก็โดนสแกนอยู้แล้วใช่ไหมครับ

blog

ถ้าสแกนบนคลาวด์ตอนภาพถูกอัปโหลดไปแล้วไม่เท่าไหร่ พอเข้าใจได้ แต่ล้วงลูกมาสแกนในเครื่องนี่มันละเมิดสิทธิส่วนบุคคลไหม แล้วถ้าแบบนี้ทำได้ อย่างอื่นก็ทำได้ ไหนว่ากูเกิ้ลล้วงข้อมูลคนใช้แอนดรอยด์ ตัวเองทำบ้างเหมือนกัน

ยังคิดไม่ออกว่าข้อมูลเรื่องรูปภาพโป๊ในเครื่องมันจะทำเงินให้ Apple ยังไง

แต่ฝั่ง google นี้ชัดเลยว่าจงใจเก็บข้อมูลลูกค้าเพื่อเอาไปหาเงินชัดๅ

เขาไม่ได้โฟกัสที่แสกนภาพอะไรแล้วเอาไปทำอะไร แต่เขาโฟกัสตัวระบบแสกนภาพที่รุกล้ำความเป็นส่วนตัวครับ

เมื่อมีระบบแสกนภาพแล้ว จากนี้ไปถ้าอยากจะแสกนรูปอะไรเพิ่มก็ไม่ใช่เรื่องยาก และมันไม่มีใครการันตีว่า Apple จะเก็บข้อมูลแค่เรื่องภาพโป๊อย่างเดียว ทั้งในปัจจุบัน และในอนาคต

โดยทั่วไป การการันตีที่ว่าจะสามารถเกิดขึ้นได้เมื่อมีความโปร่งใสและการตรวจสอบ ซึ่ง Google Facebook และอื่นๆไม่ว่าจะเอาข้อมูลไปทำอะไร ถ้ามีความโปร่งใส มีการตรวจสอบ ผู้ใช้รับรู้และยินยอม ก็ไม่มีปัญหาอะไร แต่เคส Apple ที่เป็นประเด็นคือมันมีรัฐมาเอี่ยวด้วยนี่แหละ

+1

มันรู้สึกเหมือน ทำ platform เพื่อสแกนรูปในเครื่องมาแล้ว ในอนาคตแค่เปลี่ยนจาก สแกนภาพโป๊ ไปสแกนเอกสาร หรือข้อมูลอื่นๆ แบบนี้ก็น่ากลัวนะ

ทำไมผมรู้สึกว่ามันอันตราย และไม่มีความเป็นส่วนตัวเพราะถ้ามีทั้งภาพโป๊เด็ก วัยรุ่น และผู้ใหญ่รวมๆ กัน ระบบจะฉลาดขนาดนั้นเลยหรือว่าภาพโป๊ที่เห็นเป็นภาพโป๊เด็ก วัยรุ่น หรือผู้ใหญ่ ..ถ้าเกิดวัยรุ่นอายุ 20+ แต่มีรูปร่างเล็กคล้ายเด็ก ระบบจะมองว่าเป็นภาพโป๊เด็กไหม? หรือภาพเด็กที่เห็นกลับมีรูปร่างคล้ายวัยรุ่นอายุ 20+ มันแยกออกหรือ? แบบนี้ไม่โดนลบผิดฝาผิดตัวกันหรืออย่างไร? แถมถ้า Apple มีการสแกนแล้วเงวเถิดไปล้วงลูกภาพอื่นๆ ที่ไม่ใช่ภาพโป๊เด็ก เพื่อเอาไปใช้ทำโฆษณาของตัวเองขึ้นมา ใครจะไปทราบกับ Apple ได้ ..เพราะงี้แหละถึงได้มีความกังวลเรื่องความเป็นส่วนตัวกัน

ถ้าดูจากตามข่าวก่อนหน้า ใช้ระบบสแกนจากรูปที่ถูกเข้ารหัสไปแล้ว แสดงว่ามันต้องมีภาพต้นฉบับก่อนครับ เช่น รูปที่หลุดมาจากอินเตอร์เน็ต อาจจะมีองค์กรส่งภาพร้องขอให้แอปเปิ้ลสแกนภาพนี้ทีว่่มีในเครื่องคนอื่นมั้ยน่ะครับ และบางทีอาจจะตรวจสอบว่ารูปเป็นไฟล์ต้นฉบับ หรือมีอยู่ก่อนอัพโหลดขึ้นเนตรึเปล่า เพื่อตามหาคนร้ายที่อัพรูปนี้ขึ้นไป

ไม่ได้ใช้ AI สแกนรูปที่มีในเครื่องว่าเป็นภาพโป๊เด็กหรือเปล่า

ซึ่งจริง ๆ แล้ว ระบบนี้ไม่เกี่ยวอะไรกับรูปโป๊เด็กเลย เพราะระบบมันไม่รู้ด้วยซ้ำว่ารูปอะไร อยู่ที่แอปเปิลเลยที่จะสกรีนว่าจะให้สแกนอะไร

รัฐบาลทุกประเทศ กด Like ให้กับสิ่งนี้

ถ้าเป็นการโหลด Hash ลงเครื่องก่อนค่อยทำการเปรียบเทียบ ไม่ใช่อัพโหลดไปเทียบ Hash บนเซอร์เวอร์ ผมว่าก็ยังถือว่ามีความเป็นส่วนตัวในระดับนึงนะครับ

อีกอย่างที่แถมรัฐบาลกด Like ให้ด้วย คือถ้ามีเอกสารทางการที่มี Hash ก็จะสามารถใช้กลไกนี้หาได้ด้วยเหมือนกันเนี่ยสิ

ประเด็นที่ Apple กำลังสร้างความไม่พอใจต่อคนที่กังวลด้านความเป็นส่วนตัว และการสอดแนมอยู่ที่ ความน่าเชื่อถือ โปร่งใส และความเป็นไปของเครื่องนี้ตัวนี้ เพราะในอดีตเราเคยมีเคสอยู่บ่อย ๆ ที่เครื่องมือเหล่านี้ถูกใช้เพื่อการสอดแนมแทนที่จะนำไปใช้งานตามวัตถุประสงค์ที่ตอนแรกมันถูกสร้างขึ้นมา

หากขยายความเพิ่มเติม ปํญหาไม่ใช่วิธีการใช้ค่า hash มาซ่อนข้อมูลจริง และแสกนบนเครื่องของผู้ใช้ก่อนส่งขึ้น cloud แทนที่จะแสกนบน cloud และคาดหวังว่ามันจะสร้างความเป็นส่วนตัวได้

ขอให้คิดตามที่ผมจะนำเสนอเคสตัวอย่างต่อไปนี้

แล้วหากต่อไป มันไม่มช่แค่รูปภาพ แต่เป็นไฟล์เอกสาร ข้อความที่ส่งกันไปมาหล่ะ มีหนึ่งก็มีสองแหละเคสแบบนี้

ในเคสที่คุณ Ford AntiTrust เสนอมานั้น ผมได้พิจารณารวมถึงเห็นผลร้ายที่จะเกิดขึ้นของการมีเครื่องมือใหม่นี้เข้ามาอยู่ในชีวิตประจำวันของทุกคนแล้วครับ ทั้งนี้ผมมองว่ามันเป็นการสร้างระบบตรวจจับที่เพื่อให้คนที่จะกระทำผิดต้องหยุดยั้งชั่งใจก่อนจะลงมือ โดยมีลักษณะคล้ายตำรวจตั้งด่านตรวจ ที่เหมารวมคนที่ "มีพิรุธใกล้เคียงกับผู้กระทำความผิด" เช่นกัน

ผมวิเคราะห์โดยคร่าวๆ ว่า ปัจจัยที่จะนำไปสู่การจับบุคคลนี้มีส่วนที่เกี่ยวข้อง คือ

1. พฤติกรรมการใช้อินเตอร์เน็ต และพฤติกรรมความระมัดระวังของตัวบุคคล

2. กฎหมายที่ทำให้สามารถนำมาใช้เพื่อเอาความผิดจากการเปิดโปงดังกล่าว

3. อำนาจเจ้าหน้าที่รัฐผู้ใช้ดุลยพินิจ หรือผู้บังคับใช้กฎหมาย

4. เครื่องมือที่จะนำไปสู่การจับกุม ในที่นี้คือระบบของแอปเปิล โดยสมมุติว่าบังคับใช้แล้ว และตามหาตัวบุคคลได้จริง

ผมฝากให้คิดว่า ในกรณีที่ผู้กระทำความผิด ทำเพื่อเปิดโปงการทุจริต หรือความไม่โปร่งใสของรัฐ ข้อใดที่ควรจะปรับปรุงแก้ไข หรือเพิ่มเติมขึ้นมา เพื่อให้บุคคลดังกล่าวไม่ต้องถูกจับกุมครับและในอีกกรณีนึง ถ้ามีผู้กระทำความผิดเรื่องภาพโป๊เด็กจริง ข้อไหนคือสิ่งที่ควรจะปรับปรุงแก้ไข เพื่อให้นำไปจับได้ซึ่งบุคคลนั้นครับ

ทั้งนี้ผมเห็นด้วยกับบางคอมเมนต์ว่าทางแอปเปิลไม่ควรออกตัวแสดงให้เห็นเองก่อนว่าสามารถทำได้ และควรให้รัฐเป็นคนประกาศ แล้วแอปเปิลคิดสิ่งนี้ออกมาเป็นทางแก้ครับ ไม่งั้นก็ช่วยเสริมภาพลักษณ์การครองโลกของแอปเปิลจริงๆ นั่นแหละครับ

ให้ยามหน้าหมู่บ้านผมอยู่ๆ มาตั้งด่านตรวจเอง ผมก็ไม่ค่อยสบายใจเท่าไรเหมือนกันครับแหะๆ

เอิ่มเกิดแฟนเขาเป็นโลลิ แล้วมาแสกนอย่างนี้ แล้วพนังงานแอเปิลเข้ามาดูก็เท่ากับมาเห็นรูปลับแฟนชาวบ้านสิครับ ทำเกินขอบเขตไปหรือเปล่า...

เท่าที่ผมอ่านกระบวนการทำงาน แอปเปิลไม่เห็นเป็น "รูป" นะครับ ไม่แน่ใจว่าผมอ่านตรงไหนผิดไปรึเปล่า

ถ้ามีจำนวนรูปที่ตรงกับค่า Hash เกินที่กำหนด เจ้าหน้าที่ของ Apple จะเข้ามาดูรูปของเราเพื่อตรวจสอบครับ

อันตรายจริงๆ ด้วยครับแบบนี้ ยังงี้ต้องเก็บเข้าคอมตัวเองอย่างเดียวแล้วละครับ :P

ไปแบนต้นทางสิ จะมาทำอะไรที่ปลายทาง ยังไงก็คือละเมิด ไม่ต้องมาเลี่ยงบาลีใด ๆ หรอก