แอปเปิลเปิดตัวระบบสแกนภาพถ่ายเพื่อหาภาพอนาจารเด็ก (child sexual abuse material - CSAM) บน iPhone และ iPad อย่างเป็นทางการ พร้อมกับเพิ่มระบบบล็อคคำค้นที่เกี่ยวข้องกับภาพโป๊เด็กบน Safari และ Siri ทั้งบน Apple Watch, iPhone, iPad, และ Mac ตรงตามที่ Matthew Green นักวิจัยความปลอดภัยไซเบอร์ นำข้อมูลมาเปิดเผยเมื่อวานนี้

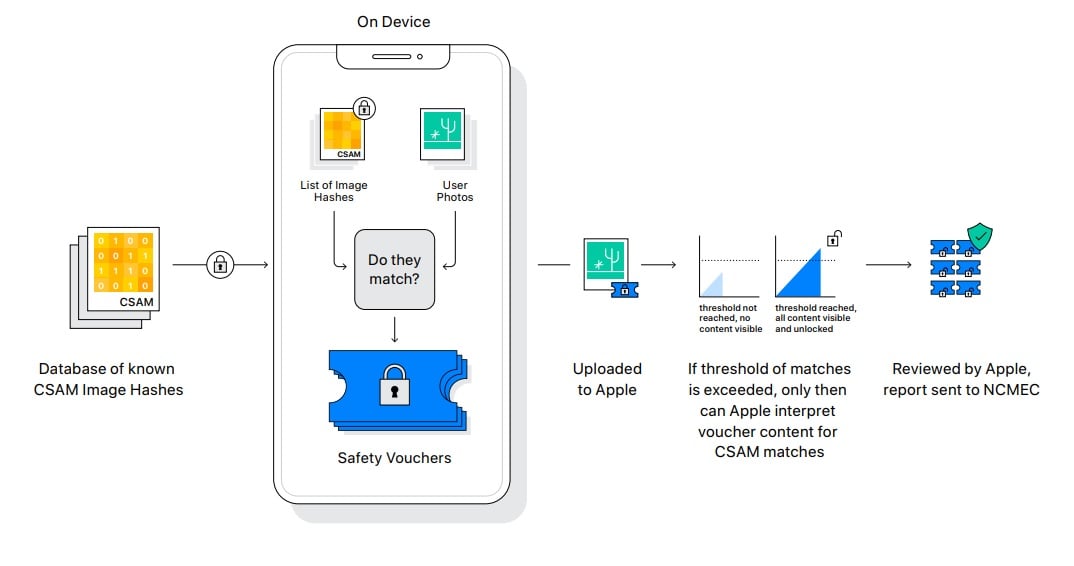

ระบบสแกน CSAM จะทำงานสแกนภาพก่อนจะอัพโหลดขึ้น iCloud เท่านั้น โดยแอปเปิลระบุว่าเป็นการรักษาความเป็นส่วนตัวของผู้ใช้เนื่องจากไม่ต้องการไปสแกนภาพบนคลาวด์โดยตรง เมื่อสแกนแล้วจะสร้างรายการภาพที่ตรงกับฐานข้อมูลภาพโป๊เด็กจากหน่วยงานรัฐ เรียกว่า safety voucher แล้วอัพโหลดขึ้น iCloud ไปพร้อมกับภาพ

เมื่อภาพอัพโหลดขึ้น iCloud จะตรวจสอบว่าจำนวนภาพที่ตรงกับฐานข้อมูลเกินกำหนดหรือยัง หากเกินแล้วจะมีพนักงานของแอปเปิลมาตรวจสอบ และหากยืนยันว่าเป็นภาพโป๊เด็กจริงก็จะรายงานหน่วยงานที่เกี่ยวข้องต่อไป

ก่อนหน้านี้เคยมีข่าวว่าแอปเปิลยกเลิกโครงการเข้ารหัสไฟล์บน iCloud แบบ end-to-end เปิดทางให้หน่วยงานรัฐสามารถขอข้อมูลผู้ใช้จากแอปเปิลโดยตรงได้ การสร้างระบบแจ้งเตือนที่ซับซ้อนเช่นนี้จึงดูไม่จำเป็นนัก เพราะในความเป็นจริงแอปเปิลก็สแกนภาพบน iCloud ได้โดยตรง แต่กระบวนการที่ซับซ้อนเหล่านี้ช่วยให้แอปเปิลมั่นใจได้ว่าพนักงานที่เกี่ยวข้องจะไม่เข้าไปดูข้อมูลผู้ใช้โดยไม่จำเป็น

กระบวนการสแกนภาพใช้อัลกอริทึม NeuralHash ที่สามารถจับภาพได้แม้ถูกแปลงบางส่วน เช่น การหมุนภาพ, เอากล้องมาถ่ายภาพจากหน้าจอ, หรือการวางลายน้ำทับภาพ

นอกจากการสแกนภาพแล้วแอปเปิลยังอัปเดต Siri และ Safari ให้แจ้งเตือนผู้ใช้เมื่อพยายามค้นหาด้วยคำที่เกี่ยวข้องกับภาพอนาจารเด็ก พร้อมกับขึ้นลิงก์สายด่วนให้ความช่วยเหลือผู้มีความคิดและพฤติกรรมเสี่ยง แอปเปิลเตรียมอัพเดตใส่ฟีเจอร์นี้บน iOS, iPadOS, watchOS, และ mac OS ภายในปีนี้

ที่มา - Apple

Comments

ปัญหาสำคัญคือแอปเปิลกำลังทำให้โทรศัพท์กลายเป็นเครื่องมือตรวจสอบพฤติกรรมผู้ใช้

วันนี้ภาพ (ที่กำลังอัปโหลด) วันต่อไปจะมีอะไรอีก ภาพยังไม่ได้อัปโหลด, ตรวจสอบคำสำคัญในแชต (ที่ประกาศมาก็มีตรวจคำสำคัญใน search แล้ว)

lewcpe.com , @wasonliw

ถ้าใช้ได้แค่ใน US ก็ไม่น่าจะมีปัญหาหรอกครับ แต่กลัวเรื่องเดียว กลัวฝั่ง Android ของ Google จะเอากับเขาด้วย โดยเฉพาะรูปใน Google Photo / Drive / Search

แต่สำหรับกรณีภาพโป๊เด็ก พูดยากอยู่นะครับ มันเป็นปัญหาเรื้อรังมานานของที่นั่น จึงต้องออกมาตรการเฉพาะของที่นั่นมา แต่ทั้งนี้ต้องดูกระแสด้วยว่าจะมีการโต้กลับยังไงบ้าง

แค่มนุษย์คนนึงที่อยากรู้เกี่ยวกับวงการไอที

Apple กำลังวางโครงสร้างเพื่อ "ปกครอง" ประชาชนครับ

และในอนาคตกฏของ Apple จะกลายเป็นบรรทัดฐานที่สังคมทั่วโลกต้องปฏิบัติตาม

สุดท้ายแล้วมนุษย์จะกลายเป็นส่วนหนึ่งของ Ecosystem ที่เขาอยากให้เป็น

อาจจะต้องย้อนกลับมาว่า การตรวจสอบการทำผิดกฎหมายที่มีลักษณะเฉพาะ (ในที่นี้คือภาพโป๊เปลือยเด็ก) เป็นสิ่งที่ควรจะให้มี เพื่อแลกมากับการไม่เป็นส่วนหนึ่งของ Ecosystem หรือไม่ครับ ซึ่งผมมองว่าส่วนนี้เป็น Dilemma หนึ่ง ทั้งๆ ที่จริงๆ แล้วมันเกิดขึ้นจากเหตุการณ์ที่คนหมู่น้อย ไม่เคารพกฎเกณฑ์ที่ตั้งไว้ร่วมกัน ทำให้ต้องเกิดการค้นหาเชิงรุกขึ้น

ถ้า Ecosystem ที่เค้าอยากให้เป็น เป็นเหมือนประเทศที่ดีในแง่ของการที่มี Detective Control ที่ดี เพื่อให้คนทุกคนอยู่ร่วมกันได้อย่างมีความสุข (?) แค่มีความหวาดกลัว (?) ว่าจะโดนจับได้ว่าทำผิด (?) แล้วส่งผลให้คนทำผิดโต้งๆ น้อยลง (แต่ไปทำแบบหลบมากขึ้น?) แบบนี้อาจจะดีแล้ว (ก็ได้?)

ส่วนตัวผมสนับสนุนการให้คนกลัวทำการผิดครับ ถ้าอนาคตคนใกล้ตัวผมต้องประสบปัญหาจากการถูกละเมิด เนื่องจากการควบคุมส่วนนี้ถูกปัดตกไป จังหวะนั้นก็คงรู้อะไรไม่สู้รู้งี้ละครับ

ในทางกลับกัน ถ้าการตรวจสอบนี้ทำให้เกิดการละเมิดความเป็นส่วนตัวของคนหมู่มาก ก็ควรจะต้องมีการจัดตั้งส่วนของผู้ตรวจสอบการใช้ข้อมูลนี้อีกที แต่จากประสบการณ์ของผมที่ใช้ Apple มา ผมขาดความรู้ไปมากเลยครับว่า Apple ใช้ข้อมูลเราไปทำอะไรบ้างที่ละเมิดความเป็นส่วนตัว

+1 ครับ Apple กำลังทำตัวเหมือน US ยุคก่อน Trump ที่พยายาม Acting เป็นตำรวจโลก

อ๊ะ Thought Police

ไม่โอนะ ผมว่ารุกล้ำเรื่องส่วนตัวมากเกินไป ยิ่งการเซนเซอร์คำ มันก็ไม่ต่างอะไรกับ GFW ของจีนเลย ฟีเจอร์นี้ควรถูกเลือกใช้ปฏิบัติตามภูมิภาคของกฎหมายมากกว่า

child sexual abuse มันก็ไม่ใช่เรื่องส่วนตัวขนาดนั้นนะครับ ยิ่งฝ่ายถูกกระทำไม่มีปากเสียงด้วย

แต่การจะตีตราให้ทุกคนบนโลกเป็นผู้ต้องสงสัยchild sexual abuseไว้ก่อน ก็ไม่น่าจะใช่รึปล่าว

+1

+1

+1

ที่ห่วงกันไม่ใช่แค่ child porn ครับ วันนี้สแกน child porn วันหน้าสแกนอะไรอีกบ้าง? เพราะมีช่องทางมาแล้ว

ถ้าบอกว่า "ไว้ใจ Apple" ก็ไม่ต่างอะไรกับเวลาหน่วยงานราชการบอกให้ไว้ใจ จะใช้แค่จับคนผิดนี่แหละ

"Features available in the U.S."

จุดที่ดอกจัน คือฟีเจอร์บล็อคคำค้นของ Siri ครับ ไม่ใช่การสแกนภาพ

lewcpe.com , @wasonliw

แต่เขาใส่ดอกจันทุก feature เลยนะ

+1 ไปอ่านมาแล้ว ใช่ครับ ดอกจันหมดเลย

แค่มนุษย์คนนึงที่อยากรู้เกี่ยวกับวงการไอที

โอ๊ะ เจอล่ะครับ ใส่ดอกจันได้ด้านล่าง

lewcpe.com , @wasonliw

อาจจะทำเพราะต้องร่วมมือกับรัฐก็ได้นะครับจริงๆ ในเนื้อหานี้น่าจะเขียนระบุไปด้วยนะครับเนี่ยว่าเฉพาะ US

ถ้าไม่ได้ทำผิดก็ไม่เห็นต้องกลัวอะไร ... วนกลับมาที่คำนี้ อีกแล้วหรือ?

แค่จุดเริ่มต้น ต่อไปไม่รู้แอบตรวจอะไรอีก

ไม่เชื่อว่าหรอกแค่ตรวจสอบ Child Porn

ละเมิดสิทธิส่วนตัวเกินไป นี้ Apple หรือ SJW / คอมมี่จีน

รอดูโดนด่า

ปล.1 มาใน iOS 15

ปล.2 เหมือนจะใช้แค่ใน US

น่าสนใจตรงที่ แล้วมันจะมีปัญหาเรื่องของเชื้อชาติหรือเปล่า แบบผู้ใหญ่เอเซียดันดูเหมือนเด็กยุโรป แล้วระบบแยกไม่ออก อะไรแบบนี้ครับ

แต่เค้าน่าจะเทรนมาดีแล้วล่ะมั้ง

ข่าวต่อไป : นักแสดงหนังผู้ใหญ่ฝ่ายหญิงต้องคัพ C ขึ้นไป....

I need healing.

ฟังดูจากเทคนิคคือจะมีลิสของรูปอยู่แล้วตรวจสอบว่ารูปที่เรามีมัน match ในลิสนั้นไหมนะครับ

เพราะงั้นปัญหาดังกล่าว ถ้าเขาไม่เพิ่มรูปที่ว่าเข้าไปในฐานข้อมูลก็ไม่น่าจะมีปัญหาอะไร

"ถ้าเขาไม่เพิ่ม" นะ...

ไม่น่าเกี่ยวอะไรกับเชื้อชาติเลยครับ เพราะเป็นการหาภาพคล้ายกับภาพในฐานข้อมูล ก็ขึ้นกับว่าฐานข้อมูลมีภาพอะไรประเภทไหนบ้าง

อย่าง NeuralHash ตอนทำงานวิจัยนี่ใช้หาภาพวัตถุได้ด้วย มันไม่ใช่การพยายาม detect จากลักษณ์ภาพ (หาภาพเด็กต่ำกว่า 18 มีลักษณะอนาจาร) แต่เป็นการหาภาพที่เหมือนภาพในฐานข้อมูล

ผมสงสัยว่าฐานข้อมูลมันจะใหญ่แค่ไหน อาจจะต้องตัดเฉพาะภาพที่ยัง active มีการแชร์กันอยู่ หรืออยู่ระหว่างการช่วยเหลือเหยื่อ

lewcpe.com , @wasonliw

ขอบคุณสำหรับข้อมูลครับ

ปธน. Xi Jinping ถูกใจสิ่งนี้

พึ่งทราบแฮะว่ามันไม่เข้ารหัสแบบ end to end แล้ว

แบบนี้คงคุยโม้เรื่องความปลอดภัยไม่ได้แล้วมั้ง เพราะเล่นแสกนได้แบบนี้ iClound คงไม่ปลอดภัยอีกต่อไป เพราะในอนาคตหมายถึงจะขโมยหรือแอบส่องข้อมูลในเครื่องอะไรก็ได้

แล้ววันดีคืนดีระบบรั่ว หรือโดนแฮก คงน่าดูชมพลึก

iCloud ไม่เคย end-to-end หนิครับ ที่ end-to-end คือ iMessage

lewcpe.com , @wasonliw

ซึ่งตอนนี้ iMessage ก็ยัง ene-to-end นะ แค่ขอแสกนก่อน end เอ๊งงง

ด้วยแนวทางที่ประกาศมา ถ้าอยู่ใน iMessage เฉยๆ ไม่ backup ขึ้น iCloud น่าจะไม่ถูกสแกนนะครับ

lewcpe.com , @wasonliw

ตัว Communication safety in Messages จะสแกนก่อนส่งนี่ครับ ถ้าสมมติ user เป็นผู้เยาว์แล้วส่งรูปใดๆที่ถูก flagged ว่าเป็นภาพโป๊ จะโดนเตือนและถ้าจะส่งจะแจ้งผู้ปกครองเลย (ุถึงแม้ Apple จะบอกว่าทำที่ client-side นะเราไม่เห็นว่าเป็นรูปอะไร)

อันนั้นคนละฟีเจอร์ และไม่ได้เปิดทำงานหากไม่ใช้ parental control ครับ

ส่วน CSAM นี่ปิดไม่ได้

lewcpe.com , @wasonliw

อ่าใช่ครับ แต่ผมแค่กังวลว่ามันมีฟีเจอร์ในการสแกน iMessage มาละ ต่อไปก็อาจจะสแกนเนื้อหาอื่นๆ ใน account อื่นๆเพิ่มเติมได้

น่าจะแสกนได้เกือบทุกรายมั้งครับ เพราะแต่ค่าตั้งต้นถ้าไม่ได้ไปปิดมันคือ backup ขึ้น iClound - -"

มันมี iCloud Keychain ด้วยครับ

อันนั้นน่าจะคนละ layer ครับ ตัว iCloud ไม่ได้ end-to-end แต่เรา (หรือบริการอื่น เช่น keychain) อัพโหลดข้อมูลที่เข้ารหัสไป ตัว iCloud ก็อ่านข้อมูลไม่ได้อยู่ดี

lewcpe.com , @wasonliw

กินแบตด้วยสินะ

Apple กำลังทำตัวเกินหน้าที่

เมื่อเปิดช่องเพื่อให้แสกนอย่างหนึ่งได้แล้ว จะทำให้มันแสกนเพิ่มได้อีกสองสามอย่างก็ไม่ใช่เรื่องยาก

ฟังดูจากเทคนิคแล้ว... มันสามารถเพิ่มรูปใดๆลงไปในฐานข้อมูลแล้วตรวจสอบได้เลยโดยที่ไม่ต้องแก้อะไร และฐานข้อมูลดังกล่าวก็ดูเหมือนจะไม่ได้อยู่ในความดูแลของ Apple ด้วย

มือถือสมัยนี้เหมือนเราไม่ใช่เจ้าของเท่าไร

อ่านรอบแรกตกใจ แต่อ่านอีกที

น่าจะโอเคนะกับการเทียบรูปในลิส ที่มีโอกาสพลิกแค่ หมุนรูปใส่ลายน้ำอะไรแบบนั้น

อีกอย่างคือ US ค่อนข้าง Serious กับเรื่อง Chid Porn อยู่แล้ว

Pornhub ยังลบคลิปไม่เหลือเพราะประเด็น Chid Porn เลย

อนาคตอาจจะมี รัฐธรรมนูญApple / Facebook / Android

เอาจริงๆ ปัจจุบันเค้าสแกนกันอย่างลับๆ อยู่แล้วถ้าเป็น หนังโป๊เด็กนะ

มีเอกสารที่เค้าว่าว่าทำไหมครับ

ไม่ลับนะครับ แต่สแกนบน Cloud Storage

ครั้งนี้น่าจะเป็นครั้งแรกที่มาใช้เครื่องผู้ใช้สแกนเอง

lewcpe.com , @wasonliw

ไหนบอกว่า Privacy ของลูกค้า สำคัญมากไงขนาด FBI มาขอความร่วมมือยังปฏิเสธเลย

ถ้าเป็นตัวละครอนิเมะไม่ใช่เด็กแต่รูปร่างเล็ก แนวโลลิจะโดนไปด้วยรึเปล่าน่ะ (ไม่มีครอบครองแค่สงสัย)

แล้วภาพโป๊เด็กเป็นสิ่งผิดกฎหมาย ถ้าตรวจเจอตำรวจสามารถจับได้เลย

ที่ผ่านมาแค่ไม่โดนตรวจเลยไม่โดนจับ apple แค่ทำตามและปกป้องเด็กแล้วทำไมคนใน blognone ถึงเต้นกัน

ตามที่เข้าใจน่าจะมีภาพชุดอยู่ก่อนแล้ว หากแสกนแล้วตรงกันภาพนั้นก็จะถือเป็นภาพเข้าข่าย และจะมีการยืนยัน ส่งเรื่องให้ผู้เกี่ยวข้องต่อไป

ที่กลัวกันเพราะเมื่อมีระบบในการสแกนหาแล้ว การจะเพิ่ม "อย่างอื่น" เข้าไปเป็นเรื่องง่ายครับ เช่นเกิดรัฐสั่งให้สแกนหารูปที่เป็นการต่อต้านรัฐ ใบปลิวโจมตีรัฐบาล จะอ้างว่าเข้าถึงข้อมูลคนใช้ iPhone ไม่ได้อย่างแต่ก่อนก็ไม่ได้แล้ว (ซึ่งกรณีนี้ก็อาจจะไปเทียบกับฐานข้อมูลที่มีอยู่แล้วเช่นกัน)

+65536 มันเป็นการเปิดช่องให้รัฐเข้ามาควบคุมได้ง่ายมากขึ้น

"Those who make peaceful revolution impossible will make violent revolution inevitable." JFK.

ไม่ (น่าจะ) มีใครเต้น เพราะเหตุผลด้านการปกป้องสิทธิของผู้เยาว์

แต่สิ่งที่กังวลกัน คือความสามารถของมัน ที่อาจจะถูกในไปใช้เพื่อการ "อย่างอื่น" มากกว่า ตามที่หลายความเห็นได้ว่าไว้

คนขี้ลืม | คนบ้าเกม | คนเหงาๆ

คุณต้องแยกให้ออกระหว่าง "ทำในส่งที่ดี" กับ "ทำเกินหน้าที่" ครับ

(ถ้าทุกคนทำในสิ่งที่ดีกันหมดทั้งโลก ก็ไม่จำเป็นต้องสนใจว่าใครมีหน้าที่ทำอะไรอีกต่อไป)

ผมนึกถึง setting ในอนิเมชั่นญี่ปุ่นเรื่อง Psycho-Pass นะมันจะเป็นอย่างไรถ้ามีกระบวนการตัดสินโทษบุคคลก่อนที่เขาจะมีโอกาสก่ออาชญากรรม เมื่อทุกคนจะมีค่าสัมประสิทธิ์อาชญากรรมให้พร้อมถูกสแกนได้ทุกเมื่อ ทุกที่ ทุกเวลา

อันที่จริงมีภาค the movie ที่ตัวสแกนมันโดนแก้ค่าให้เป็นตรวจค่าสัมประสิทธิ์อย่างอื่นแทนและหลอกว่ามันคือค่าสัมประสิทธิ์อาชญากรรม

"Those who make peaceful revolution impossible will make violent revolution inevitable." JFK.

ถ้าหนังก็ MINORITY REPORT

ถ้าหนังก็ MINORITY REPORT

โลกมืดมันมีพลังเยอะ มองแบบวิชาการนะ นี่เป็นจุดเริ่มต้นการล่มสลายของแอพ ซอฟแวร์จะไปอยู่ในลักษณะ wasm มากขึ้น ระบบปฏิบัติการโทรศัพท์เก่าๆอาจถูกนำกลับมาทำต่อ หลักๆมันมีแค่utilitiesพื้นฐานกับweb browserเท่านั้นเอง แอพใช้wasmแทน

ถ้าเด็กวัยรุ่นถ่ายรูปตัวเองจะไม่โดนใช่ไหม

เอเปิลทำดีแล้ว ปลอดภัยรอยเปอร์เรื่องความเป็นส่วนตัแนนอนถ้าค่ายอื่นทำแบบนี้ไมได้หรอก

พอเอามาผูกกับเรื่องภาพอนาจารเด็กแบบนี้ผมล่ะกลัวจริง ๆ ว่าเวลามีคนออกมาวิจารณ์เรื่องความเป็นส่วนตัวจะโดนคนออกมาบอกว่าเพราะแกเป็นพวกชอบดูภาพพวกนี้เลยกลัวล่ะสิ

ทั้งที่จริง ๆ มันน่ากลัวมาก ๆ เลยนะเพราะตอนนี้สิ่งเดียวที่คานอำนาจกับผู้ใช้อำนาจรัฐคือพนักงานที่มาตรวจว่าเป็นภาพอนาจารเด็กจริงมั้ย เพราะจากรายละเอียดการทำงานแล้วผู้ใช้อำนาจรัฐก็แค่เพิ่มภาพเข้าไปในฐานข้อมูลเพื่อใช้สอดส่องได้และอ้างได้ว่าไม่อยากให้คนนอกเข้ามาตรวจฐานข้อมูลเพราะกลัวภาพในฐานข้อมูลหลุดไปได้ด้วยจึงไม่มีใครสามารถรู้ว่าในฐานข้อมูลนั้นมีแต่ภาพอนาจารเด็กจริงหรือไม่ แล้วถ้าหากสามารถซื้อตัวคนตรวจได้นี่เสร็จเลยนะ...

ทำไมผมเข้าใจว่าการค้นหาผ่าน hash คือยังเคารพ privacy อยู่นะ คือสุดท้ายก็ยังไม่รู้ว่ารูปมันคืออะไรอยู่ดี เพราะเข้าใจว่าอย่าง internet ของฝั่ง US ทางฝั่ง ISP เขาก็ scan พวก header เป็น hash เพื่อดูว่ามีการวิ่งในรูปแบบ malware/bot/ddos รึเปล่า ถ้าเจอเยอะๆก็จะได้ป้องกันทัน ซึ่งทาง ISP ก็ไม่รู้อยู่ดีว่าคนที่ใช้งาน วิ่งผ่านเว็บอะไร หรือ ข้อมูลวิ่งอะไรแบบไหน

ปํญหาไม่ใช่วิธีการใช้ค่า hash มาซ่อนข้อมูลจริงครับ

ปํญหาคือระบบส่วนกลางของ Apple หรือองค์กรที่ดูแลข้อมูลตัวนี้ สามารถใส่ค่า hash ใดๆ ที่เราก็ไม่รู้ว่าค่า hash นั้นสื่อถึงข้อมูลที่เป็นภาพโป๊เด็กจริงๆ หรือไม่

อาจจะเป็นข้อมูลรูปภาพบางอย่างที่ส่งไปยังเป้าหมายเพื่อตรวจสอบสอดแนมในระดับรัฐ ซึ่งในโลกนี้อาจจะมีเป้าหมายดังกล่าวเพียงคนเดียวที่จะได้ภาพภาพนั้นที่มีค่า hash ตรงกับในระบบ ซึ่งก็อาจจะเป็นภาพโป๊เด็กที่ทำขึ้นมาเฉพาะ ฯลฯ ก็ได้

ถ้างั้นคือเราไม่รู้ว่าฐานข้อมูลภาพโป๊เด็กอันนี้มาจากไหน มีหน่วยงานที่เชื่อถือได้แค่ไหนเอามาทำ hash หรือเอาแค่ภาพคนธรรมดามาทำ hash ใช่ไหมครับ?และต้องมั่นใจว่า algorithm นี้ไม่สร้าง hash ที่ชนกันเยอะเกินไปจนสร้าง false alarm ที่ trigger ให้เจ้าหน้าที่มาตรวจสอบภาพที่ไม่เกี่ยวข้อง

อันนี้คือถ้าเครื่องมือของ Apple อันนี้หลุดขึ้นมา (หรืออาจจะเป็นคนใน Apple ทำเองก็ได้) ไปใช้ในทางที่ผิด ก็จะเป็นปัญหาที่รุกราน privacy ขึ้นมาใช่ไหมครับ?

ใช่ครับ เป็นปัญหาด้านความน่าเชื่อถือ โปร่งใส โลกเราเคยมีเคสอยู่บ่อยๆ ที่เครื่องมือสอดแนมหลุดจนต้องหาทางป้องกันกันอยู่

เห็นภาพชัดขึ้นแล้วครับ ขอบคุณครับ

สรุปฟีเจอร์นี้เฉพาะใน U.S. ใช่ไหม?

รึยังไง?

เพราะไปอ่านต้นทาง บอกว่าเฉพาะ U.S.

ตอนนี้ US แต่เมื่อมีระบบแล้ว หากประเทศอื่นจะออกกฏหมายบอกให้ Apple ทำบ้างในประเทศตัวเองก็คงไม่ยากอะไร

อนาคตถ้าใครใช้ iPhone แปลว่าคบได้ระดับนึง เพราะคนนั้นไม่ดูหนังโป๊เด็ก จบข่าว