Apple

public://topics-images/apple_webp.png

SCB10X

public://topics-images/347823389_774095087711602_515970870797767330_n_webp.png

Windows 11

public://topics-images/hero-bloom-logo.jpg

Huawei

public://topics-images/huawei_standard_logo.svg_.png

Google Keep

public://topics-images/google_keep_2020_logo.svg_.png

Instagram

public://topics-images/instagram_logo_2022.svg_.png

SCB

public://topics-images/9crhwyxv_400x400.jpg

Microsoft

public://topics-images/microsoft_logo.svg_.png

Basecamp

public://topics-images/bwpepdi0_400x400.jpg

FTC

public://topics-images/seal_of_the_united_states_federal_trade_commission.svg_.png

Pinterest

public://topics-images/pinterest.png

Palantir

public://topics-images/-nzsuc6w_400x400.png

AIS Business

public://topics-images/logo-business-2021-1.png

PostgreSQL

public://topics-images/images.png

JetBrains

public://topics-images/icx8y2ta_400x400.png

Krungthai

public://topics-images/aam1jxs6_400x400.jpg

Palworld

public://topics-images/mccyhcqf_400x400.jpg

Bill Gates

public://topics-images/bill_gates-september_2024.jpg

VMware

public://topics-images/1nj4i1gp_400x400.jpg

Take-Two Interactive

public://topics-images/0khle7nh_400x400.jpg

OpenAI

public://topics-images/ztsar0jw_400x400.jpg

Thailand

public://topics-images/flag_of_thailand.svg_.png

ServiceNow

public://topics-images/ytnrfphe_400x400.png

Klarna

public://topics-images/urcllpjp_400x400.png

Google Play

public://topics-images/play.png

Drupal

public://topics-images/drupal.png

Virtua Fighter

public://topics-images/virtua_figther_2024_logo.png

Paradox Interactive

public://topics-images/paradox_interactive_logo.svg_.png

Europa Universalis

public://topics-images/europa-icon.png

Nintendo Switch 2

public://topics-images/mainvisual.png

Cloudflare

public://topics-images/cloudflare_logo.svg_.png

Samsung

public://topics-images/samsung.png

Google

public://topics-images/google_2015_logo.svg_.png

Uber

public://topics-images/uber.png

Microsoft 365

public://topics-images/m365.png

USA

public://topics-images/flag_of_the_united_states.svg_.png

GM

public://topics-images/0pe0po-z_400x400.jpg

Perplexity

public://topics-images/perplex.jpg

Xperia

public://topics-images/xperia.png

iOS 18

public://topics-images/ios-18-num-96x96_2x.png

True

public://topics-images/true_logo.png

SoftBank

public://topics-images/softbank.jpg

Pac-Man

public://topics-images/pacman.png

Harry Potter

public://topics-images/harry.png

Marvel

public://topics-images/marvel.png

Skydance

public://topics-images/skydance.png

SEA

public://topics-images/sealogo.png

Find My Device

public://topics-images/find.png

Gemini

public://topics-images/google_gemini_logo.svg__1.png

Accessibility

public://topics-images/accessibility-128x128_2x.png

Material Design

public://topics-images/m3-favicon-apple-touch.png

Android 16

public://topics-images/android16.png

Android

public://topics-images/android_0.png

Firefox

public://topics-images/firefox_logo-2019.svg_.png

Google Messages

public://topics-images/messages.png

Notepad

public://topics-images/notepad.png

Singapore

public://topics-images/flag_of_singapore.svg_.png

Airbnb

public://topics-images/airbnb.png

PS5

public://topics-images/ps5.png

Krafton

public://topics-images/krafton.png

Doom

public://topics-images/doom-game-s_logo.svg_.png

AMD

public://topics-images/amd_logo.svg_.png

GTA

public://topics-images/gta_0.png

DoorDash

public://topics-images/doordash.png

YouTube

public://topics-images/yt.png

YouTube Music

public://topics-images/yt-music.png

Facebook

public://topics-images/fb.png

iQiyi

public://topics-images/iqiyi_0.png

Viu

public://topics-images/viu.png

Amazon Prime Video

public://topics-images/prime-vid.png

Spotify

public://topics-images/spotify.jpg

Apple TV

public://topics-images/apple-tv.png

HBO Max

public://topics-images/max.png

Threads

public://topics-images/threads.png

Alexa

public://topics-images/alexa.png

Kindle App

public://topics-images/kindle.png

Shopee

public://topics-images/shopee.png

Waze

public://topics-images/waze.png

Bilibili

public://topics-images/bili.png

Google Maps

public://topics-images/maps.png

Apple Music

public://topics-images/apple-music.png

Claude

public://topics-images/claude.png

TikTok

public://topics-images/tiktok.png

Xbox

public://topics-images/xbox.png

Tesla

public://topics-images/tesla.png

Chrome

public://topics-images/chrome.png

Google Calendar

public://topics-images/gcal.png

Google Home

public://topics-images/ghome.png

Google Meet

public://topics-images/meet.png

NotebookLM

public://topics-images/notebooklm.png

Reddit

public://topics-images/reddit.png

Assassin’s Creed

public://topics-images/ac.png

Mark Zuckerberg

public://topics-images/zuck.jpg

Meta

public://topics-images/meta.png

Meta AI

public://topics-images/meta-ai.png

Epic Games

public://topics-images/epic_games_logo.svg_.png

Unreal

public://topics-images/unreal_engine_logo-new_typeface-svg.png

Fortnite

public://topics-images/fortnite.png

DeepMind

public://topics-images/deepmind.png

Databricks

public://topics-images/databricks.png

Netflix

public://topics-images/netflix-logo.png

Microsoft Azure

public://topics-images/azure.png

Microsoft Copilot

public://topics-images/microsoft_copilot_icon.svg_.png

Bing

public://topics-images/bing.png

EA

public://topics-images/ea.png

Intel

public://topics-images/intel.png

Amazon

public://topics-images/amazon.png

AWS

public://topics-images/aws.png

Zoom

public://topics-images/zoom.png

Dropbox

public://topics-images/dropbox_0.png

Roblox

public://topics-images/roblox.png

Dell Technologies

public://topics-images/dell-tech.png

Nothing

public://topics-images/nothing.svg_.png

Microsoft Teams

public://topics-images/teams.png

Mojang

public://topics-images/mojang.png

Minecraft

public://topics-images/minecraft.png

Redis

public://topics-images/redis_logo.svg_.png

Ubisoft

public://topics-images/ubisoft_logo.svg_.png

Elden Ring

public://topics-images/elden.png

Brave

public://topics-images/brave.png

Opera

public://topics-images/opera.png

Vivaldi

public://topics-images/vivaldi.png

Microsoft Edge

public://topics-images/edge.png

Duolingo

public://topics-images/duolingo.png

LinkedIn

public://topics-images/linkedin.png

Canva

public://topics-images/canva.png

Realme

public://topics-images/realme.png

NASA

public://topics-images/nasa-logo.png

Booking.com

public://topics-images/booking.png

Agoda

public://topics-images/agoda.png

Bolt

public://topics-images/bolt.png

Grab

public://topics-images/grab.png

Temu

public://topics-images/temnu.png

LINE

public://topics-images/line.png

Facebook Messenger

public://topics-images/messenger.png

WhatsApp

public://topics-images/whatsapp.png

Telegram

public://topics-images/telegram.png

Signal

public://topics-images/signal.png

X.com

public://topics-images/x.png

Grok

public://topics-images/grok.png

xAI

public://topics-images/xai.png

CapCut

public://topics-images/capcut.png

Edits

public://topics-images/edit.png

Google One

public://topics-images/gone.png

Tinder

public://topics-images/tinger.png

Whoscall

public://topics-images/whoscall.png

OneDrive

public://topics-images/onedrive.png

Lightroom

public://topics-images/lr.png

Meitu

public://topics-images/meitu.png

Outlook

public://topics-images/outlook.png

Excel

public://topics-images/excel.png

PowerPoint

public://topics-images/ppt.png

Microsoft Word

public://topics-images/word.png

Phone Link

public://topics-images/phone-link.png

OneNote

public://topics-images/onenote.png

Windows App

public://topics-images/windows-app.png

Notion

public://topics-images/notion.png

Google Drive

public://topics-images/drive.png

YouTube Kids

public://topics-images/yt-kids.png

Gboard

public://topics-images/gboard.png

DeepSeek

public://topics-images/deepseek_logo.svg_.png

Prince of Persia

public://topics-images/prince-persia.png

Sony

public://topics-images/nq0nd2c0_400x400.jpg

Tencent

public://topics-images/z4xi4oyc_400x400.jpg

Cisco

public://topics-images/jmyca1yn_400x400.jpg

Alibaba

public://topics-images/4axflwia_400x400.jpg

Alibaba Cloud

public://topics-images/qm43orjx_400x400_cloud.png

Coinbase

public://topics-images/consumer_wordmark.png

CarPlay

public://topics-images/carplay.png

Rust

public://topics-images/rust-logo-blk.png

Red Hat

public://topics-images/redhat.png

Anthropic

public://topics-images/anthropic.png

Xcode

public://topics-images/xcode.png

Tim Cook

public://topics-images/tim-cook.jpg

Donald Trump

public://topics-images/trump.jpg

Microsoft Surface

public://topics-images/surface.jpg

Copilot+ PC

public://topics-images/copilotpc.png

Stellar Blade

public://topics-images/stellar-blade.jpg

Snapdragon

public://topics-images/snapdragon_chip.png

Qualcomm

public://topics-images/qualcomm-logo.svg_.png

CoreWeave

public://topics-images/coreweave.png

Ford

public://topics-images/ford.png

Xiaomi

public://topics-images/xiaomi.png

Google Cloud

public://topics-images/google_cloud_logo.svg_.png

PlayStation Network

public://topics-images/psn.png

PlayStation Plus

public://topics-images/ps-plus.png

Windsurf

public://topics-images/windsurf.png

Square Enix

public://topics-images/square-enix.png

MIT

public://topics-images/x7hyjl3t_400x400.jpg

Zoox

public://topics-images/zoox.jpg

Evernote

public://topics-images/1neatidg_400x400.jpg

Magic the Gathering

public://topics-images/magic.png

Call of Duty

public://topics-images/cod.png

NVIDIA

public://topics-images/nvidia_logo.svg_.png

Satya Nadella

public://topics-images/nadella.png

Nintendo

public://topics-images/nintendo.png

Japan

public://topics-images/japan_flag.png

China

public://topics-images/china-flag-sq.png

Sam Altman

public://topics-images/sam-altman.png

SNK

public://topics-images/snk_logo.svg_.png

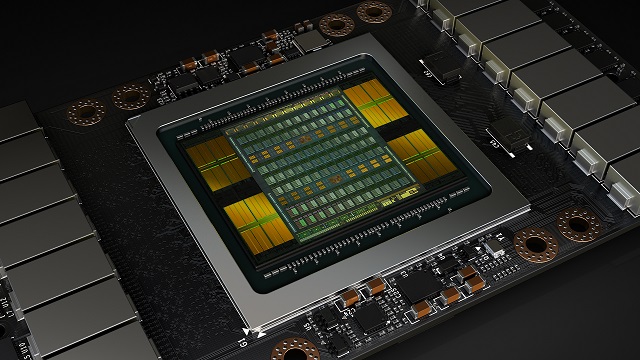

อืม.. ไกลถึงเวลาเปิดตัว GTX

waroonh Thu, 05/11/2017 - 10:44

อืม.. ใกล้ถึงเวลาเปิดตัว GTX Titan XP Service pack 1 แล้วสินะครับ

จาก p เป็น v แทน สงสัยจะเป็น

nununu Thu, 05/11/2017 - 10:55

In reply to อืม.. ไกลถึงเวลาเปิดตัว GTX by waroonh

จาก p เป็น v แทน สงสัยจะเป็น Vista ครับ 5555

^

waroonh Thu, 05/11/2017 - 12:05

In reply to จาก p เป็น v แทน สงสัยจะเป็น by nununu

^ใจเย็นๆ ครับ ผมเข้าความรู้สึกนะ

ปีที่แล้ว เดือน 6 เปิดตัว GTX Titan มา $1,200 (ซื้อนี่)

2 เดือนที่แล้ว เปิดตัว GTX 1080Ti มา $699 แต่แรงกว่า Titan (WTF ?)

พอโดนด่าเข้า เยอะๆ ก็ประชดออก GTX Titan รุ่นใหม่

เดือนที่แล้ว GTX Titan Xp แรงกว่า 1080Ti ประมาณ แมลงหวี่ กับ แมลงวัน บินแข่งกัน

(ซื้อตัวนี้ อีกรอบ ?)

เดือนนี้ ประกาศว่า Volta ที่จะมาเป็น Series 2000 ออกขาย ประมาณเดือน 7-8ขอให้เจริญๆ นะครับ nVidia

15 'FP 32' TFLOPS -> 15 'FP32

McKay Thu, 05/11/2017 - 12:37

15 'FP 32' TFLOPS -> 15 'FP32' TFLOPS จะดีกว่าครับ

ข้อสังเกตของ V100 คือ FP16 ไม่ได้เร็วเป็น 2 เท่าของ FP32 เหมือน P100 อีกแล้ว แต่เป็น 8 เท่าแทน!

เป็นหน่วยวัดใหม่ที่ผมเพิ่งเคย

twometre Thu, 05/11/2017 - 14:26

In reply to 15 'FP 32' TFLOPS -> 15 'FP32 by McKay

เป็นหน่วยวัดใหม่ที่ผมเพิ่งเคยเห็นน่ะครับ เลยเว้นวรรคผิด ขอบพระคุณครับ

แสดงว่าใส่ ALU FP16 รัวๆ

lew Thu, 05/11/2017 - 19:31

In reply to 15 'FP 32' TFLOPS -> 15 'FP32 by McKay

แสดงว่าใส่ ALU FP16 รัวๆ ไม่ได้เอา FP32 มาแบ่งครึ่งแล้ว?

จากที่อ่านลิ้งที่คุณ k2w2yut

McKay Fri, 05/12/2017 - 02:13

In reply to แสดงว่าใส่ ALU FP16 รัวๆ by lew

จากที่อ่านลิ้งที่คุณ k2w2yut โพสมาสรุปว่าเพิ่ม ALU แบบใหม่ขึ้นมาจริงๆครับ แต่ไม่ใช่ FP16 ปกติ โดยเป็น core เพื่อประมวลผล Matrix-Matrix multiplication (BLAS GEMM) -- Tensor Cores ซึ่งใช้ในงาน deep learning แทน FP32(@16) ALU แบบปกติครับ

ดังนั้นที่ผมเม้นไปว่า x8 อันนั้นคงผิดเพราะมันไม่ใช่ FP32/16 แบบปกติ(และน่าจะประมวลผล FP16 แบบปกติไม่ได้) ซึ่งคงต้องใช้การ optimize พอสมควร อันนี้ NVIDIA โฆษณาว่า

รายละเอียดเพิ่มเติมอ่านได้จาก

k2w2yut Fri, 05/12/2017 - 07:58

In reply to จากที่อ่านลิ้งที่คุณ k2w2yut by McKay

รายละเอียดเพิ่มเติมอ่านได้จาก blog CUDA แล้วครับ

”Each Tensor Core performs 64 floating point FMA mixed-precision operations per clock (FP16 input multiply with full precision product and FP32 accumulate, as Figure 8 shows) and 8 Tensor Cores in an SM perform a total of 1024 floating point operations per clock”

สรุปง่ายๆคือ"โกง"นับ FLOPS มันตรงๆเลย ไม่สนว่าเป็น 16/32/64

Peak FP32 TFLOP/s : 15 (32-bit each)

Peak Tensor Core TFLOP/s : 120 (1-bit each,1455x640x64x2)

*นอกเรื่อง เทียบกับ TPU ของ Google ที่ยัด 8-bit 256x256 MAC (10K fp/clock/unit) ดูยังห่างกันหลายขุม แต่ทางนั้นเน้น inference ล้วนๆไม่เน้น learning

ref:https://devblogs.nvidia.com/parallelforall/cuda-9-features-revealed/

ไอ้ FP32

McKay Fri, 05/12/2017 - 08:22

In reply to รายละเอียดเพิ่มเติมอ่านได้จาก by k2w2yut

ไอ้ FP32 นี่ไม่น่าจะถือว่าโกงหล่ะครับเพราะตัว shader มันให้ raw perf ได้แบบนั้นจริงๆไม่ต้อง optimize อะไร

แต่ตัว Tensor Cores นี่ถ้าไม่ได้ใช้ cuBLAS GEMM FP16->FP32 Mixed Precision นี่ก็แทบจะไม่ได้ประโยชน์อะไรเลย

ผมไม่แน่ใจถ้าไม่ได้ใช้ cuBLAS

k2w2yut Fri, 05/12/2017 - 10:44

In reply to ไอ้ FP32 by McKay

ผมไม่แน่ใจถ้าไม่ได้ใช้ cuBLAS แล้วตัว compiler จะฉลาดพอ,หรือต้อง inline assembly เอาถึงจะใช้งานได้

งงครับ จากที่มา ตอนที่

tekkasit Thu, 05/11/2017 - 21:55

In reply to 15 'FP 32' TFLOPS -> 15 'FP32 by McKay

งงครับ จากที่มา ตอนที่ "NVIDIA Tesla V100 Specifications" ยังระบุว่า

เหมือน Deep Learning ก็ยังไม่ใช่ Single-Precision

whitepaper

k2w2yut Thu, 05/11/2017 - 22:11

In reply to 15 'FP 32' TFLOPS -> 15 'FP32 by McKay

whitepaper ยังไม่ออกก็คงได้แค่เดาๆแหละครับ

2x FP32->FP16x22x FP64->FP16x4 native instruction ใหม่?

4x 8 TensorCore core ที่ใส่มาน้อยมากแต่ไม่บอกรายละเอียด?

ref:https://devblogs.nvidia.com/parallelforall/inside-volta/

ปล.Nvidia น่าจะหมดมุขไม่หั่นไม่แก้ SM ไปอีกพักใหญ่คงได้แต่ยัดตัวประมวลผลเฉพาะทางมากขึ้น - -

"สเปคทรงพลังเกินกว่าจะเล่นเกม

art_duron Thu, 05/11/2017 - 13:47

"สเปคทรงพลังเกินกว่าจะเล่นเกมจริงๆ"ผมว่าไม่น่าจะจริงนะครับถ้าเอามาใช้กับ Dell UP3218K ที่ native นะครับ 555

ไม่น่าจะเล่นเกมได้รึเปล่าครับ

sapjunior Thu, 05/11/2017 - 19:18

ไม่น่าจะเล่นเกมได้รึเปล่าครับ เพราะ Tesla ไม่มี Output นิครับ

ก็เอาไปพ่วงกับ Quadro สิครับ

MaylinZ Thu, 05/11/2017 - 20:30

In reply to ไม่น่าจะเล่นเกมได้รึเปล่าครับ by sapjunior

ก็เอาไปพ่วงกับ Quadro สิครับ ถ้ามันมีหัวต่อ SLI นะ 555+