モラルジレンマ(道徳的ジレンマ)と言うと、

有名なのが「トロッコ問題」

トロッコ問題

あなたは線路を走るトロッコの運転手です。

突然トロッコのコントロールが効かなくなりました。

このままだと、線路にいる作業員5人を轢き殺してしまいます。

しかし、

途中のポイントを切りかえれば別の線路に入れます。

そこには作業員はひとりだけです。

あなたはポイントを切りかえますか?

また、

あなたは線路を見おろす橋にいます。

トロッコが暴走し、このままでは作業員5人が轢き殺されてしまいます。

しかし、

あなたの横には大男がいます。

彼を突き落とせば作業者5人を助けることが出来ます。

あなたは大男を突き落としますか?

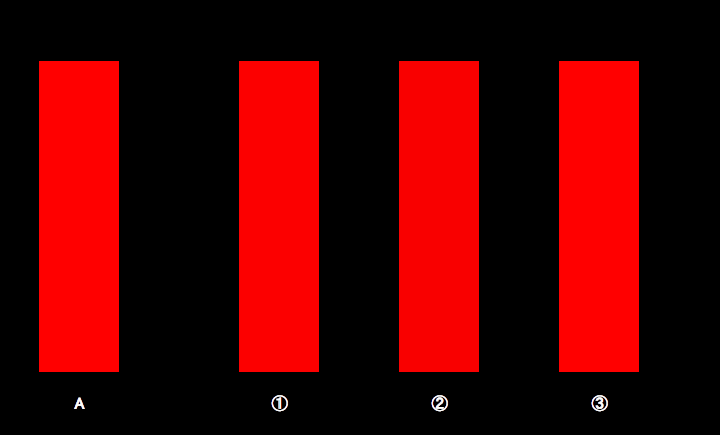

状況は違うものの

1人が死ぬか5人が死ぬかの選択は同じです。

この質問に大多数が

前者ではポイントを切りかえ、(5人を選択)

後者では大男を突き落とすことはしません。(1人を選択)

何故でしょう?

それは

前者では偶然性(アクシデント:Accident)であって、

後者は意図的(インテンション:Intention)によるものだと思われます。

つまり、

前者は「事故」であるため、5人を救うことを選びますが、

後者では大男を突き落とせば「事件」となるため、1人を選択します。

※自閉症患者や前頭葉を損傷した人は、トロッコ問題では大男を突き落とします。

AI 人工知能

さて、最近話題のAI「人工知能」

様々な分野で開発されていますが、

AIのモラルジレンマはどうでしょう?

いま、問題になっているのは車の自動運転(自動走行車)です。

MITメディアラボでは

自動運転による人工知能の道徳的意思決定に関する研究を公開しています。

MITメディアラボ

https://www.media.mit.edu/

MITメディアラボ(モラル・マシン)

http://moralmachine.mit.edu/hl/ja

ジレンマの例としてトロッコ問題のほか

「囚人のジレンマ」などが有名です。

![[商品価格に関しましては、リンクが作成された時点と現時点で情報が変更されている場合がございます。] [商品価格に関しましては、リンクが作成された時点と現時点で情報が変更されている場合がございます。]](https://hbb.afl.rakuten.co.jp/hgb/16a0393e.c048f795.16a0393f.c8c0c0bc/?me_id=1258569&item_id=10000350&m=https%3A%2F%2Fthumbnail.image.rakuten.co.jp%2F%400_mall%2Fedyshop%2Fcabinet%2Fproduct%2Fedy-r-point%2Fedy-r-card_black.jpg%3F_ex%3D80x80&pc=https%3A%2F%2Fthumbnail.image.rakuten.co.jp%2F%400_mall%2Fedyshop%2Fcabinet%2Fproduct%2Fedy-r-point%2Fedy-r-card_black.jpg%3F_ex%3D128x128&s=128x128&t=picttext)