2016年02月の記事

全15件 (15件中 1-15件目)

1

-

シンガポール旅行 帰国

無事に帰国しました。6:00前、予定より早く羽田空港に着陸。入国審査→荷物受け取り→Global WifiにモバイルWifiを返却→パーク&ライドに連絡して車受け取り→自宅まで車で移動で、8:15ごろ自宅に到着。-----〇今回の旅行で気づいたこと・Global WifiでモバイルWifiを借りた。移動中でもWEBやマップを確認できてよかった。今後も、海外に行くときには借りるかもしれない。・シンガポールの車道は日本と同じ左側通行。・シンガポールは、比較的渋滞がひどくない感じがした。・シンガポールの街中には、高層住宅ばかりで平屋があまりなかった。・ジョホールバルには、普通の古い平屋があった。・地下鉄で切符を買うときに親切な人に手伝ってもらえた。・マリーナ・ベイ・サンズ屋上は風が強く、地上に比べて涼しい感じがした。-----やっぱり、海外旅行は刺激的で楽しい。にほんブログ村

2016年02月29日

コメント(1)

-

シンガポール旅行 3日目

朝8:10 ホテル出発、マレーシアのジョホールバルへ。30分ほどで国境に着いた。出入国手続きをしてマレーシアに入国。↓ヒンズー寺院オランダから輸入したガラスで内装したらしい。↓マレー文化村、伝統舞踊の様子昼食後、シンガポールに向かった。国境付近はすさまじい渋滞だった。観光バスは、優先レーンを走れるので、渋滞には巻き込まれずに済んだ。ジョホールバルではお祭りがあり、それが原因ということだった。15:00ごろ、オーチャードロードの免税店で解散。地下鉄(MRT)でオーチャードロードからベイフロントへ。マリーナ・ベイ・サンズの56階展望台に上がった。↓展望台からのスーパー・ツリー・グローブ↓展望台からのフラワードーム↓展望台からの金融街16:00過ぎからゆっくりとエスプラネード・シアターの方に歩いた。17:00前から屋台で軽く食事をとり、コンラッドホテルロビーに向かった。コンラッドホテルロビーで荷物を受け取り、これを書いている。19:35に空港に向かう予定。にほんブログ村

2016年02月28日

コメント(0)

-

シンガポール旅行 2日目

朝9:15ホテル出発、シンガポール半日観光へ。半日観光→トライショー観光→ナイトサファリという日程だった。↓ラッフルズ卿↓マリーナ・ベイ・サンズの様子↓観覧車のふもとでチキンライス↓ブギス・ストリート、人で溢れかえっていた。↓人力車にのってアラブストリートを通行↓KILLINEYという店でカヤジャムサンド↓チリクラブの夕食↓ナイトサファリでスナドリネコ↓ナイトサファリのショー21:15にナイトサファリを出発し、22:00過ぎにホテルに着いた。本当によく遊んだ1日だった。にほんブログ村

2016年02月27日

コメント(0)

-

シンガポール旅行 1日目

前から行きたいと思っていたシンガポールに来た。以下、1日目の日程。5:20 自宅を車で出発6:40 羽田空港の民間駐車場パーク&ライド着7:00 国際線ターミナル2FのグローバルWifiにてシンガポールのモバイルWifiを受け取り7:30 搭乗手続き、30分くらい並んだ8:20 機内搭乗8:50 SQ0631にてシンガポールへ15:30 シンガポールのチャンギ国際空港着16:00 荷物受け取り16:20 HISの現地ガイドとともにホテルに向かう17:00 コンラッドホテル着17:30 歩いてマリーナスクエアを突き抜けて、エスプラネード・シアターズへ向かう17:50 屋台で食事18:20 ぼけらっと夕暮れから夜にかけてマリーナ・ベイ・サンズとマーライオンが見えるスポットを歩いたり座り込んでいた。20:40 ホテルに戻った。↓屋台のチャーハンSGD12。ちょっと高いような。でもおいしかった。↓マーライオンを間近から↓マリーナ・ベイ・サンズ、20:00からライトアップされていた。↓金融街の夜景気温31℃、ちょっと蒸し暑かったが、雨も降らず、夕方からはおもったより快適だった。シンガポールの景色を満喫できた。にほんブログ村

2016年02月26日

コメント(0)

-

TOEICの結果

1/31に受験した結果が返ってきた。Listening 410Reading 370Total 780だった。目標としていた800点まであと20点。しかし、前回の730点から50点アップ。2か月間、以下の教材で勉強した効果を感じた。次こそは800点を超えたい。にほんブログ村

2016年02月22日

コメント(0)

-

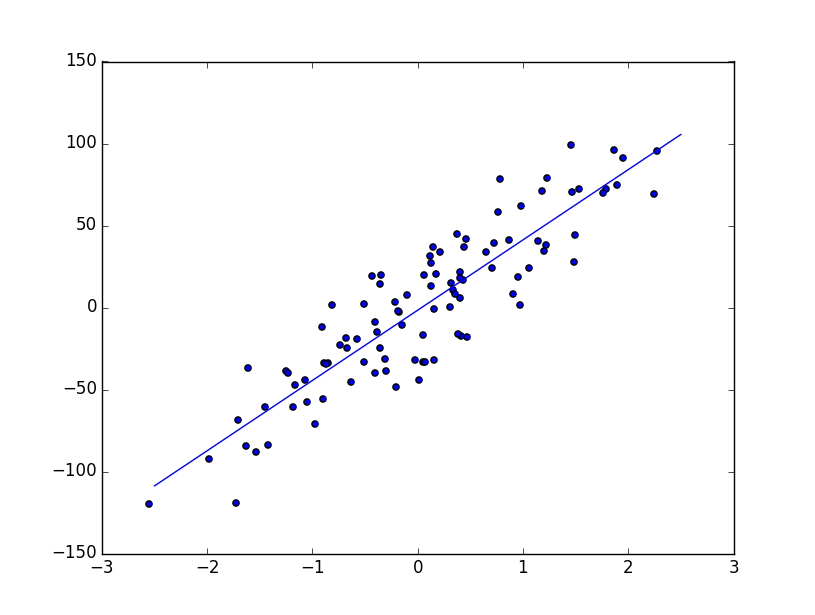

データサイエンティスト養成読本 機械学習入門編

第1部 しくみと概要を学ぼう!特集1 機械学習を使いたい人のための入門講座特集2 機械学習の基礎知識特集3 ビジネスに導入する機械学習特集4 深層学習最前線第2部 手を動かして学ぼう!特集1 機械学習ソフトウェアの外観特集2 Pythonによる機械学習特集3 推薦システム入門特集4 Pythonで画像認識にチャレンジ特集5 Jubatusによる異常検知↓ぼくにとってのポイントPythonによる機械学習のscikit-learn入門から線形回帰(linear regression)、ロジスティック回帰、サポートベクターマシン(SVM)、KMeansによるクラスタリングがコードとともに紹介されている。〇線形回帰(linear regression)# coding: utf-8import numpy as npimport matplotlib.pyplot as pltfrom sklearn import linear_model, datasetsnp.random.seed(0)regdata=datasets.make_regression(100,1,noise=20.0)lin=linear_model.LinearRegression()lin.fit(regdata[0],regdata[1])print("coef and intercept :",lin.coef_,lin.intercept_)print("score :", lin.score(regdata[0],regdata[1]))xr=[-2.5,2.5]plt.plot(xr,lin.coef_*xr+lin.intercept_)plt.scatter(regdata[0],regdata[1])plt.show()↓結果('coef and intercept :', array([ 42.85335573]), -1.6283636540614514)('score :', 0.80333572865564484)〇ロジスティック回帰ロジスティック回帰は2値(0, 1など)をとる値に説明変数であてはめようとする手法。以下は、あやめの測定値と種類(0または1)からあやめの傾向を学習し、測定値が与えられたときにあやめの種類が0か1を当てる。# coding: utf-8import sklearn.datasets as datasetsfrom sklearn.linear_model import LogisticRegressionfrom sklearn import cross_validationiris=datasets.load_iris()data=iris.data[iris.target !=2]target=iris.target[iris.target !=2]logi=LogisticRegression()scores=cross_validation.cross_val_score(logi,data,target,cv=5)print(scores)↓結果[ 1. 1. 1. 1. 1.]〇サポートベクターマシン(SVM)あやめのデータの分類を可視化。svc.fit(data,iris.target)で学習し、z=svc.predict(np.c_[x.ravel(),y.ravel()])で予測している。# coding: utf-8from sklearn import datasetsfrom sklearn import svmfrom sklearn.decomposition import PCAimport numpy as npimport matplotlib.pyplot as pltiris=datasets.load_iris()pca=PCA(n_components=2)data=pca.fit(iris.data).transform(iris.data)datamax=data.max(axis=0)+1datamin=data.min(axis=0)-1n=200x,y=np.meshgrid(np.linspace(datamin[0],datamax[0],n), np.linspace(datamin[1],datamax[1],n))svc=svm.SVC()svc.fit(data,iris.target)z=svc.predict(np.c_[x.ravel(),y.ravel()])plt.contourf( x,y,z.reshape(x.shape),levels=[-0.5,0.5,1.5,2.5], colors=["r","g","b"])for i,c in zip([0,1,2],["r","g","b"]): d=data[iris.target==i] plt.scatter(d[:,0],d[:,1],c=c)plt.show()↓結果〇KMeansによるクラスタリング教師なし学習の例。n_clusters=3で3つに分類。kmeans.fit(x)で学習させる。# coding: utf-8import numpy as npimport matplotlib.pyplot as pltfrom sklearn.cluster import KMeansnp.random.seed(0)x=np.r_[np.random.randn(30,2)+[2,2], np.random.randn(30,2)+[0,-2], np.random.randn(30,2)+[-2,2]]kmeans=KMeans(n_clusters=3)kmeans.fit(x)markers=["o","v","x"]for i in range(3): xx=x[kmeans.labels_==i] plt.scatter(xx[:,0],xx[:,1],c="k",marker=markers[i])plt.show()↓結果にほんブログ村

2016年02月21日

コメント(0)

-

Pythonエンジニア養成読本

第1章 その特徴、歴史とコミュニティよくわかるPythonの世界第2章 開発を始める前に知っておくべきことこれだけは知っておきたいPython言語はじめの一歩第3章 チーム開発に役立つ開発環境とツール開発環境とチーム開発第4章 Pythonデータ活用術PyData入門第5章 しくみを理解してアプリ開発に挑戦入門Webアプリケーション開発第6章 Ansibleで実践環境構築の自動化↓ぼくにとってのポイント〇scipyで手軽に2点間の距離を計算できる。>>> from scipy.spatial import distance>>> x=[1,2,3]>>> y=[2,3,4]>>> distance.euclidean(x,y)1.7320508075688772>>> 〇scipyで手軽に機械学習の分類ができる。>>> from scipy.spatial import KDTree>>> x,y,z=(1,1,2),(5,3,7),(2,5,1)>>> label=("x","y","z")>>> tree=KDTree((x,y,z))>>> tree.dataarray([[1, 1, 2], [5, 3, 7], [2, 5, 1]])>>> new_data=(4,5,1)>>> d,n=tree.query(new_data)>>> print "分類結果は{0}です。".format(label[n])分類結果はzです。>>> print "距離は{0}です。".format(d)距離は2.0です。>>> 〇sympyで数式の展開>>> import sympy>>> x,y=sympy.symbols("x y")>>> sympy.expand((x+y)**2)x**2 + 2*x*y + y**2-----Pythonの適用例とそのさわりが解説されている。にほんブログ村

2016年02月20日

コメント(0)

-

栃木に出張

今週は客先訪問が多い。おととい海老名に行き、今日は栃木で打合せが2件。1件目は、パラメータスタディ561ケースの結果報告。お客様には満足していただけてよかった。検収に大分近づいた。2件目は振動・騒音解析の件。今後の進め方について打ち合わせをした。同時並行で案件が3件動いている。ここ1週間が山場になりそうだ。にほんブログ村

2016年02月18日

コメント(1)

-

PCバッグ

最近、打合せが多く、毎日のように会社のパソコンを持ち歩いている。ちょっとPCバッグを見てみると、以下のものがあった。立ったままでも両手でキー操作できるそうだ。ほかにも以下のものがあった。↓シンプル↓ゴージャスにほんブログ村

2016年02月17日

コメント(1)

-

人工知能入門

第1章 人工知能とは何か第2章 人工知能研究の歴史第3章 探索による問題解決第4章 知的な探索技法第5章 知識の表現第6章 推論第7章 学習第8章 ニューラルネットワークと強化学習第9章 テキスト処理第10章 自然言語処理第11章 進化的計算第12章 群知能第13章 エージェントシミュレーション第14章 自律エージェント第15章 人工知能の未来↓ぼくにとってのポイント〇人工知能の成果自然言語認識システム、検索エンジン、自動翻訳、ネットショッピングの「おすすめ」表示、セキュリティシステム〇人工知能とは人間や生物の知的な活動をまねること〇探索人工知能の基礎技術。状態空間における状態の遷移を評価し、目標状態を探し出す。1.現在の状態から次に遷移する状態の候補をオペレータを用いて探し出す。2.遷移先の状態を決めて、状態遷移を実行する。3.遷移先の状態が目標状態でなければ1.に戻る。適用例カーナビ、チェス、将棋、囲碁など〇意味ネットワークとフレームis-a関係、has関係、non-has関係、do関係など自動車は乗り物のひとつなので乗り物と自動車はis-a関係自動車はタイヤを持っているので、自動車とタイヤはhas関係。乗り物は移動するので乗り物と移動はdo関係。オブジェクト指向プログラミングの世界観と同じようだ。-----人工知能とその適用例がわかりやすく解説されていて、参考になった。にほんブログ村

2016年02月17日

コメント(0)

-

久しぶりのかぜ

先週、水曜、昼前くらいから急に寒気と頭が痛くなってきた。木曜の祝日はほとんど寝込んでしまった。金曜の朝はだいぶましになったので、普通に仕事をした。少しずつ良くなって、現在、ほぼ治りかけ。みなさんもお大事に。↓ルキノンを飲み続けていました。にほんブログ村

2016年02月16日

コメント(2)

-

パラメータスタディの打ち合わせ

先日、561ケース投入した計算の打ち合わせ。計算結果は出揃ってないが、結果のまとめ方について打合せた。提案した内容で合意してもらえた。考え続けたかいがあった。計算結果をまとめて、来週、また報告。何かがわかる結果ならいいんだけど。にほんブログ村

2016年02月08日

コメント(0)

-

フットサルの練習

近所のサッカー仲間のつてで、近くの小学校のグラウンドでフットサルの練習。いつものように、準備体操→パス練習→シュート練習→ゲームだった。シュート練習は趣向をこらして、3人が絡む形の練習だった。実戦でも出てきそうな形だった。1ヶ月くらいやってなかったが、思ったよりは動けた。途中で、ここの小学生も参加してきた。にほんブログ村

2016年02月06日

コメント(3)

-

パラメータスタディ561ケース

設計変数が32もあるパラメータスタディをすることになった。まともにやると2水準でも2^32=4294967296ケース。とても無理なので、Latin方格かHammersleyを使うことにした。設計変数Nのときのケース数は両方とも(N+1)(N+2)/2。N=32のとき、561ケース。Hammersleyの方が、非線形性の強い応答曲面をよく再現するということだった。計算投入のコマンドを延々と描いたテキストファイルを作り、計算機3台に投入した。果たしてうまくいくだろうか。。にほんブログ村

2016年02月04日

コメント(1)

-

栃木に出張

朝から晩まで丸一日、客先だった。打ち合わせが朝と夕方で、昼間の空き時間にメールチェックなどをしていた。オフィスにいないときに限って、メールがたくさん来る。朝の打ち合わせは、トポロジー最適化について以下が要望だった。・トポロジー最適化の結果を現実的な設計案にするか・製造条件、製造コストを制約条件とできないか夕方の打ち合わせは、最適化の課題で、現状、多すぎる設計変数をいかに減らして、価値ある結果を出すかということがポイントだった。明日も別件で朝から打ち合わせだ。にほんブログ村

2016年02月02日

コメント(0)

全15件 (15件中 1-15件目)

1

-

-

- ★ おすすめのビジネス書は何ですか!…

- 働かないおじさんは資本主義を生き延…

- (2025-11-15 17:38:19)

-

-

-

- 連載小説を書いてみようv

- 59 タムタムさんカッコいい

- (2025-11-11 14:59:50)

-